AI エージェントの開発とデプロイは、最先端の領域として注目を集めています。しかし、本番環境でこういった複雑なシステムを管理するには、確かなオブザーバビリティが必要です。AgentOps は、エージェント モニタリング、LLM コスト追跡、ベンチマークなどを実現する Python SDK です。特に強力で費用対効果の高い Gemini API と組み合わせると、エージェントをプロトタイプの状態から簡単に本番環境で運用できるものにすることができます。

AgentOps の開発にあたった Agency AI の COO、Adam Silverman 氏は、AI エージェントを大規模にデプロイする企業にとって、重要な要素となるのがコストだと述べています。「私たちは、企業が LLM の呼び出しに毎月 8 万ドルをかけるのを見てきました。Gemini 1.5 なら、数千ドルで同じ出力を得られたはずです」

この費用対効果の高さと Gemini の強力な言語理解機能や生成機能を組み合わせれば、高度な AI エージェントを開発するデベロッパーにとって、理想的な選択肢が生まれます。「Gemini 1.5 Flash は、信じられないほど高速でありながら、わずかなコストで、大きなモデルと同等の品質を提供します」と Silverman 氏は言います。これにより、デベロッパーはコストの肥大化を心配することなく、複雑なマルチステップ エージェント ワークフローの開発に集中できます。

「他の LLM プロバイダでエージェントを実行すれば、1 回あたり 500 ドル以上かかります。Gemini(1.5 Flash 8B)を使えば、50 ドル未満で同じものを実行できます」

– Adam Silverman 氏(Agency AI、COO)

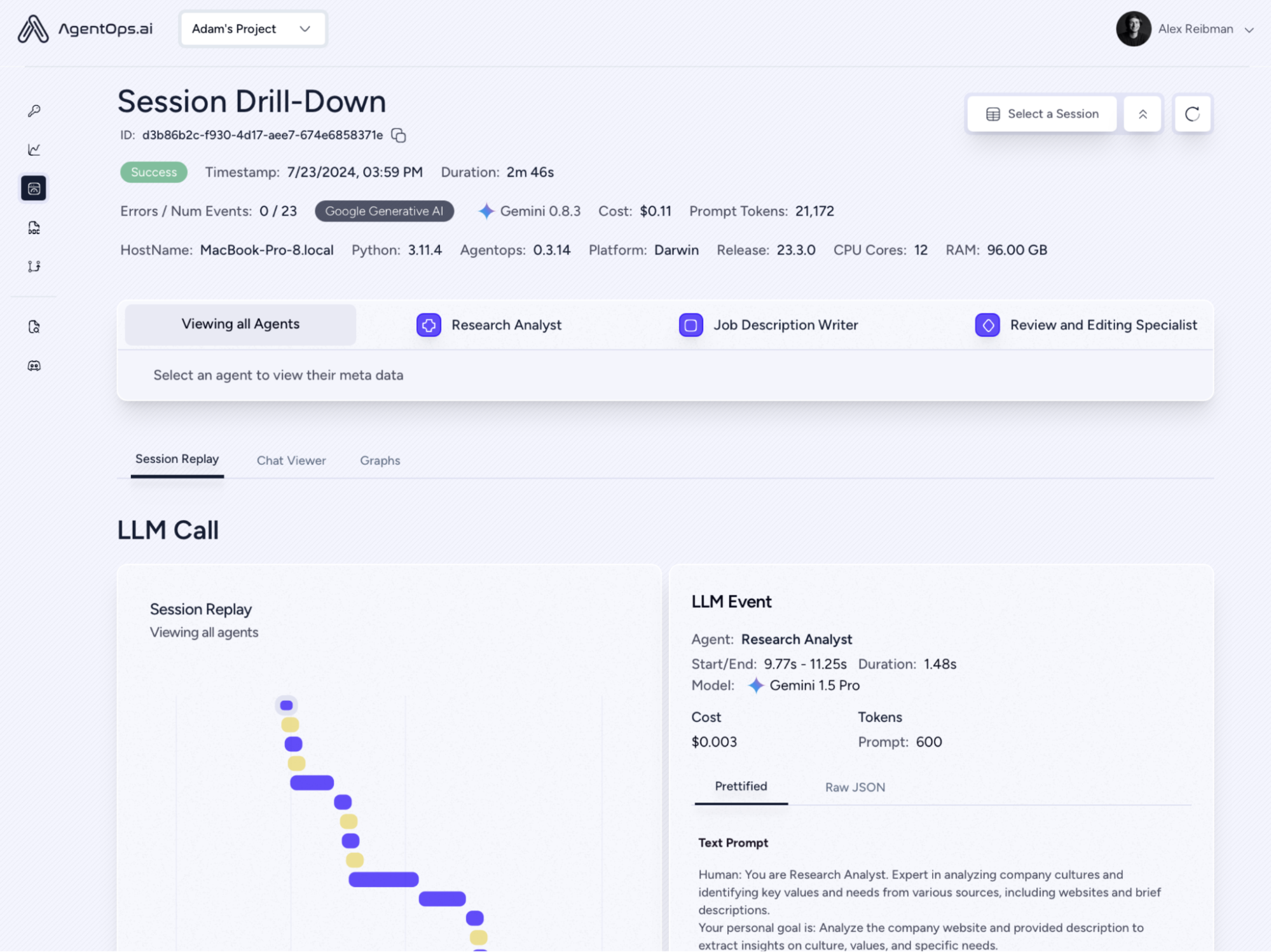

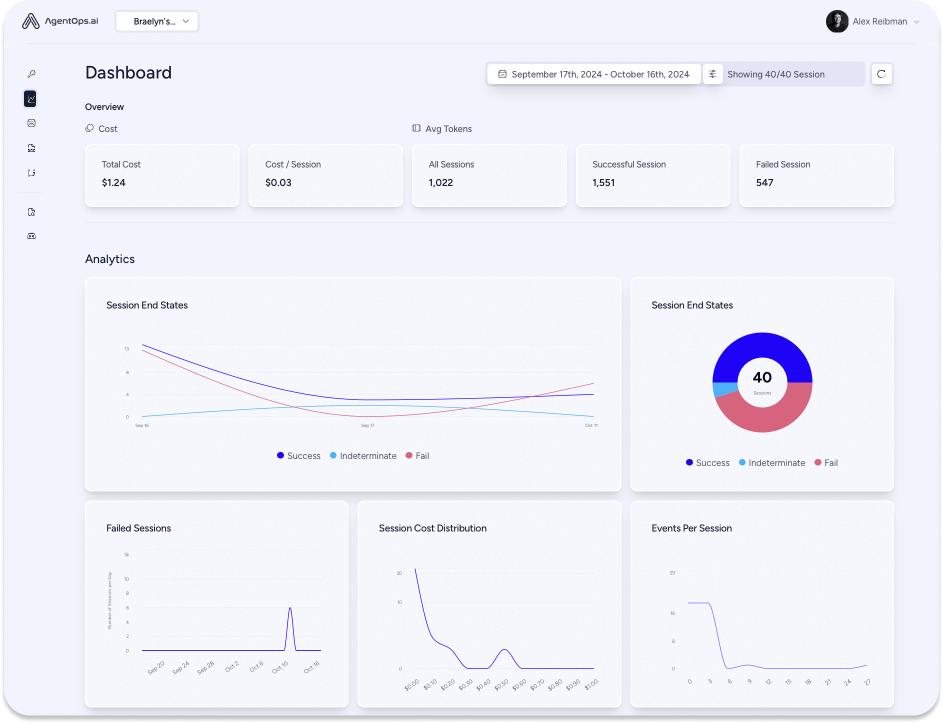

AgentOps は、LLM の呼び出しだけでなく、エージェントとのすべてのインタラクション データをキャプチャし、マルチエージェント システムの動作を包括的に確認できるように表示します。このレベルの粒度は、エンジニアリング チームやコンプライアンス チームにとって不可欠で、デバッグや最適化、監査証跡の重要な知見となります。

Gemini モデルと AgentOps は、とても簡単に連携させることができます。ほとんどの場合は、LiteLLM を使えばわずか数分で完了します。デベロッパーは、Gemini の APIcalls をすばやく可視化したり、リアルタイムでコストを追跡したり、本番稼働中のエージェントの信頼性を確保したりできます。

AgentOps は、エージェントのデベロッパーがプロジェクトをスケーリングできるようにすることに取り組んでいます。Agency AI は、企業が手頃な価格でスケーラブルなエージェントを開発する際の複雑な問題をサポートし、AgentOps と Gemini API を組み合わせることによる価値提案をさらに確かにすることを目指しています。Silverman 氏は、「エージェントを開発するデベロッパーには、ますます価格を意識することが求められるようになるでしょう」と述べています。

Silverman 氏は、「試してみてください。きっと驚きます」という明快なアドバイスを、Gemini を検討しているデベロッパーに贈っています。