Llama 4 모델의 배포 및 관리에는 복잡한 인프라 설정, GPU 가용성 관리, 확장성 보장, 지속적인 운영 오버헤드 처리 등 여러 단계가 포함되어 있습니다. 이러한 문제를 해결하고 애플리케이션 개발에 바로 집중할 수 있다면 어떨까요? Vertex AI를 사용하면 가능합니다.

Meta의 개방형 대규모 언어 모델 최신 버전인 Llama 4가 이제 Vertex AI에서 완전 관리형 API 엔드포인트로 정식 출시(GA)되었음을 알려드리게 되어 기쁩니다! Llama 4 외에도 Vertex AI에서 Llama 3.3 70B 관리형 API도 정식 출시됩니다.

Llama 4는 멀티모달 기능과 고효율 MoE(Mixture-of-Experts) 아키텍처를 통해 이전 Llama 모델에 비해 새로운 성능 정점에 도달했습니다. Llama 4 Scout는 이전 세대의 모든 Llama 모델보다 더 강력할 뿐만 아니라 멀티모달 작업에 상당한 효율성을 제공하며 단일 GPU 환경에서 실행되도록 최적화되어 있습니다. Llama 4 Maverick은 현재 Meta가 제공하는 모델 옵션 중 가장 지능적인 모델로서 추론과 복잡한 이미지 이해, 까다로운 생성 작업을 위해 설계되었습니다.

Llama 4가 완전 관리형 API 엔드포인트로 제공되므로, 이제는 Llama 4의 고급 추론, 코딩 및 지시 준수 기능을 Vertex AI의 용이성, 확장성, 신뢰성과 함께 활용하여 보다 정교하고 강력한 AI 기반 애플리케이션을 개발할 수 있습니다.

이 게시물에서는 MaaS(Model-as-a-Service)로 Llama 4를 시작하는 방법을 안내하고 주요 장점을 조명하며 얼마나 쉽게 사용할 수 있는지 보여드리고 비용에 대해서도 알아보겠습니다.

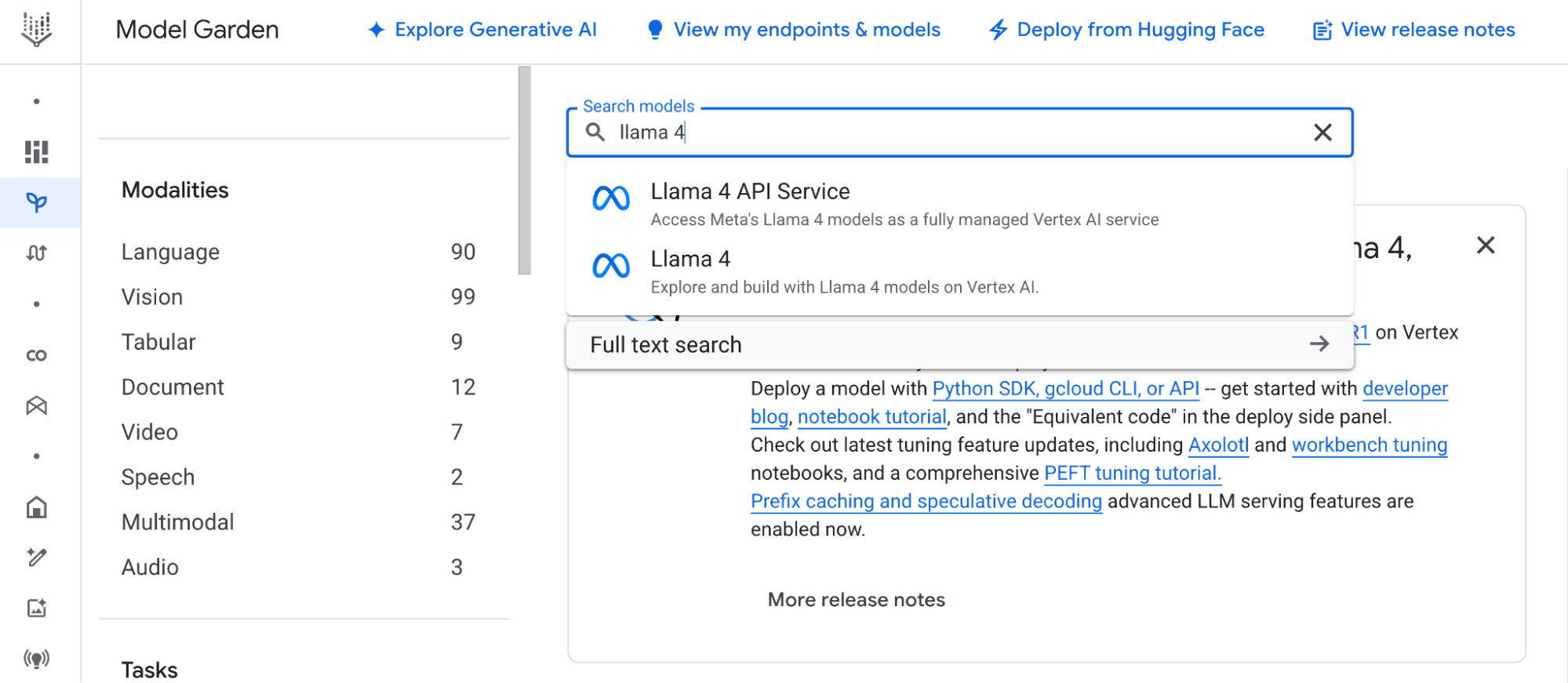

Vertex AI Model Garden은 관리형 API를 통해 Google Cloud에서 파운데이션 모델을 검색하고 배포하기 위한 중앙 허브입니다. Google 자체 모델(예: Gemini), 오픈소스 모델, 타사 모델을 엄선하여 제공하며, 모두 단순화된 인터페이스를 통해 액세스할 수 있습니다. Llama 4(GA)를 관리형 서비스로 추가하면 이 선택의 폭이 확장되어 더욱 유연한 활용이 가능해집니다.

Vertex AI에서 MaaS(Model-as-a-Service)로 Llama 4에 액세스하면 다음과 같은 이점이 있습니다.

1: 인프라 관리 불필요: Google Cloud가 기본 인프라, GPU 프로비저닝, 소프트웨어 종속성, 패치 적용, 유지 관리를 처리해 줍니다. 개발자는 간단한 API 엔드포인트와 상호 작용하기만 하면 됩니다.

2: 성능 보장: 이러한 모델에 할당된 처리 용량으로 고가용성을 보장합니다.

3: 엔터프라이즈급 보안 및 규정 준수: Google Cloud의 강력한 보안, 데이터 암호화, 액세스 제어, 규정 준수 인증의 이점을 제공합니다.

Vertex AI에서 Llama 4 MaaS를 시작하려면 Vertex AI Model Garden 내에서 Llama 4 모델 카드로 이동하여 Llama 커뮤니티 라이선스 계약에 동의하기만 하면 됩니다. 이 단계를 완료해야 API를 호출할 수 있습니다.

Model Garden에서 Llama 커뮤니티 라이선스 계약에 동의했으면 Vertex AI Model Garden 내에서 사용할 구체적인 Llama 4 MaaS 모델(예: 'Llama 4 17B Instruct MaaS')을 찾아보세요. API를 호출할 때 ID가 필요하므로 고유한 Model ID(예: meta/llama-4-scout-17b-16e-instruct-maas)를 기록해 두세요.

그런 다음 ChatCompletion API를 사용하여 Llama 4 MaaS 엔드포인트를 직접 호출할 수 있습니다. MaaS 서비스에는 별도의 '배포' 단계가 필요하지 않습니다. Google Cloud는 엔드포인트 프로비저닝을 관리합니다. 다음은 Python용 ChatCompletion API를 사용하여 Llama 4 Scout를 사용하는 방법의 예시입니다.

import openai

from google.auth import default, transport

import os

# --- Configuration ---

PROJECT_ID = "<YOUR_PROJECT_ID>"

LOCATION = "us-east5"

MODEL_ID = "meta/llama-4-scout-17b-16e-instruct-maas"

# Obtain Application Default Credentials (ADC) token

credentials, _ = default()

auth_request = transport.requests.Request()

credentials.refresh(auth_request)

gcp_token = credentials.token

# Construct the Vertex AI MaaS endpoint URL for OpenAI library

vertex_ai_endpoint_url = (

f"https://{LOCATION}-aiplatform.googleapis.com/v1beta1/"

f"projects/{PROJECT_ID}/locations/{LOCATION}/endpoints/openapi"

)

# Initialize the client to use ChatCompletion API pointing to Vertex AI MaaS

client = openai.OpenAI(

base_url=vertex_ai_endpoint_url,

api_key=gcp_token, # Use the GCP token as the API key

)

# Example: Multimodal request (text + image from Cloud Storage)

prompt_text = "Describe this landmark and its significance."

image_gcs_uri = "gs://cloud-samples-data/vision/landmark/eiffel_tower.jpg"

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": image_gcs_uri},

},

{"type": "text", "text": prompt_text},

],

}

]

# Optional parameters (refer to model card for specifics)

max_tokens_to_generate = 1024

request_temperature = 0.7

request_top_p = 1.0

# Call the ChatCompletion API

response = client.chat.completions.create(

model=MODEL_ID, # Specify the Llama 4 MaaS model ID

messages=messages,

max_tokens=max_tokens_to_generate,

temperature=request_temperature,

top_p=request_top_p,

# stream=False # Set to True for streaming responses

)

generated_text = response.choices[0].message.content

print(generated_text)

# The image contains...Important: Always consult the specific Llama 4 model card in Vertex AI Model Garden. It contains crucial information about:

Vertex AI에서 Llama 4를 MaaS(Model-as-a-Service)로 사용하는 것은 종량제 방식의 요금제와 사용 할당량을 결합한 예측 가능한 모델에서 작동합니다. Vertex AI에서 Llama 4 MaaS를 사용할 때 효과적으로 애플리케이션을 확장하고 비용을 관리하려면 요금제 구조와 서비스 할당량을 모두 이해해야 합니다.

요금제와 관련해서는, 예측 요청에 대해서만 비용을 지불합니다. 기본 인프라, 확장 및 관리 비용은 API 사용 가격에 포함됩니다. 자세한 내용은 Vertex AI 가격 책정 페이지를 참조하세요.

서비스 안정성과 공정한 사용을 보장하기 위해 Vertex AI에서 Llama 4를 MaaS로 사용할 경우 할당량이 적용됩니다. 할당량은 프로젝트가 특정 모델 엔드포인트에 대해 생성할 수 있는 분당 요청 수(RPM)처럼 여러 요인에 대해 설정된 한도를 의미합니다. 자세한 내용은 할당량 문서를 참조하세요.

이제 Llama 4가 Vertex AI에서 MaaS(Model-as-a-Service)로 정식 출시되었으므로, 필요한 인프라를 관리하지 않고도 가장 발전된 개방형 LLM 중 하나를 활용할 수 있습니다.

Vertex AI에서 Llama 4로 어떤 애플리케이션을 개발하실지 정말 기대됩니다. Google Cloud 커뮤니티 포럼을 통해 여러분의 의견과 경험을 공유해 주세요.