많은 사용자가 매일 생성형 AI와 상호작용하면서도 이러한 강력한 기능에 액세스하는 데 기본 API가 얼마나 중요한 역할을 하는지 인지하지 못하고 있습니다. API는 자동화된 에이전트와 인간 사용자가 모두 모델을 사용할 수 있도록 함으로써 생성형 AI가 힘을 발휘하도록 합니다. 내부 및 외부적으로 활용되는 복잡한 비즈니스 프로세스는 에이전트 워크플로에서 여러 API를 연결하여 구축됩니다.

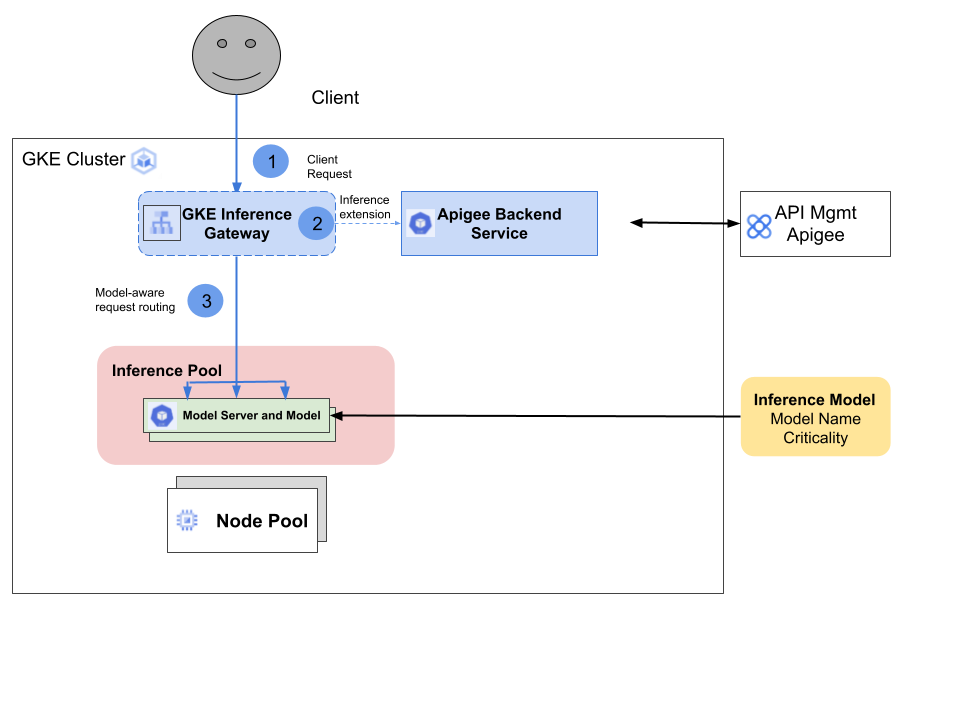

GKE(Google Kubernetes Engine) Inference Gateway는 GKE Gateway의 확장 기능으로, 생성형 AI(인공지능) 워크로드를 제공하기 위한 최적화된 라우팅 및 부하 분산 기능을 제공합니다. AI 추론 워크로드의 배포, 관리, 관측 가능성을 간소화합니다. GKE Inference Gateway는 다음을 제공합니다.

Criticality: GKE Inference Gateway를 사용하면 AI 모델의 서비스 제공 Criticality, 즉 중요도를 지정할 수 있습니다. 이를 통해 지연 시간에 민감한 요청을 지연 시간에 여유가 있는 배치 추론 작업보다 우선 처리할 수 있습니다.GKE Inference Gateway를 사용하는 대부분의 기업 고객은 에이전트/AI 워크로드를 보호하고 최적화하고자 합니다. 그들은 Agentic API 상용화 전략의 일환으로 Apigee가 제공하는 고품질의 API 거버넌스 기능에 액세스하는 동시에 Agentic API를 게시하고 수익을 창출하고 싶어 합니다.

GKE Inference Gateway는 GCPTrafficExtension 리소스를 도입해 이 문제를 해결하고, GKE Gateway가 서비스 확장 (또는 ext-proc) 메커니즘을 통해 정책 의사 결정 지점(PDP)에 '측면' 호출을 할 수 있도록 합니다.

Kubernetes용 Apigee Operator는 이 서비스 확장 메커니즘을 활용하여 GKE Inference Gateway를 통해 흐르는 API 트래픽에 Apigee 정책을 적용합니다. 이 원활한 통합을 통해 GKE Inference Gateway 사용자는 Apigee API 거버넌스의 이점을 누릴 수 있습니다.

GKE Inference Gateway와 Kubernetes용 Apigee Operator는 다음 단계를 거쳐 함께 작동합니다.

Apigee는 Google Cloud, 기타 퍼블릭 클라우드, 온프레미스 인프라 전반에서 기존 트랜잭션 API 및 LLM(Large Language Model)을 위한 포괄적인 API 관리 레이어를 제공합니다. 이 플랫폼은 강력한 정책 엔진, 전체 API 수명 주기 관리, 고급 AI/ML 기반 분석을 제공합니다. Apigee는 Gartner Magic Quadrant에서 API 관리 분야의 리더로 인정받고 있으며 복잡한 API 요구 사항을 가진 대기업에 서비스를 제공하고 있습니다.

GKE Inference Gateway와의 이번 새로운 통합을 통해 GKE 사용자는 Apigee의 모든 기능을 활용하여 API를 통해 AI 워크로드를 관리, 운영, 수익화할 수 있습니다. 여기에는 API 제작자가 API를 API 제품으로 묶어, 개발자가 셀프서비스 개발자 포털을 통해 사용할 수 있도록 하는 기능도 포함됩니다. 또한 사용자는 API 보안 및 상세 API 분석과 같은 Apigee의 부가 가치 서비스도 사용할 수 있습니다.

이 통합을 통해 GKE 사용자는 다음에 적용되는 Apigee 정책에 액세스할 수 있습니다.

이 통합에 사용되는 Kubernetes용 Apigee Operator는 관리자 템플릿 규칙도 지원하므로, 조직 관리자가 조직 전체에 정책 규칙을 적용할 수 있습니다. 예를 들어, 조직 관리자는 특정 정책을 모든 API에 적용하도록 요구하거나 조직의 API와 함께 사용할 수 없는 정책 목록을 지정할 수 있습니다.

향후 계획에는 다음을 관장하는 Apigee AI 정책에 대한 지원이 포함됩니다.

기업은 GKE Inference Gateway를 통해 Apigee의 동급 최고 API 관리 및 보안 기능을 활용함으로써 이제 AI 서비스와 API 거버넌스 레이어를 통합할 수 있습니다. Apigee의 모든 기능을 갖춘 API 관리 플랫폼을 마음껏 활용하여 GKE에서 추론 엔진을 실행하고 퍼블릭 클라우드에서 제공되는 동급 최고 수준의 AI 인프라를 활용하는 데 집중할 수 있습니다.