本日、本番環境対応 Gemini モデルの 2 つのアップデート版、Gemini-1.5-Pro-002 と Gemini-1.5-Flash-002 をリリースします。合わせて、以下の対応も行ないます。

新しいモデルは、最新の試験運用版モデルリリースがベースになっており、5 月の Google I/O で発表された Gemini 1.5 モデルを大幅に改善したものです。デベロッパーは、Google AI Studio と Gemini API を使って無料で最新モデルにアクセスできます。大規模組織や Google Cloud のお客様は、Vertex AI でもモデルを利用できます。

Gemini 1.5 シリーズは、テキスト、コード、マルチモーダル タスクという広い範囲にわたって汎用的にパフォーマンスを発揮できるように設計されたモデルです。Gemini モデルを使えば、1000 ページの PDF の情報をまとめることも、1 万行以上のコードを含むリポジトリについての質問に答えることも、1 時間の動画から有用なコンテンツを作成することもできます。

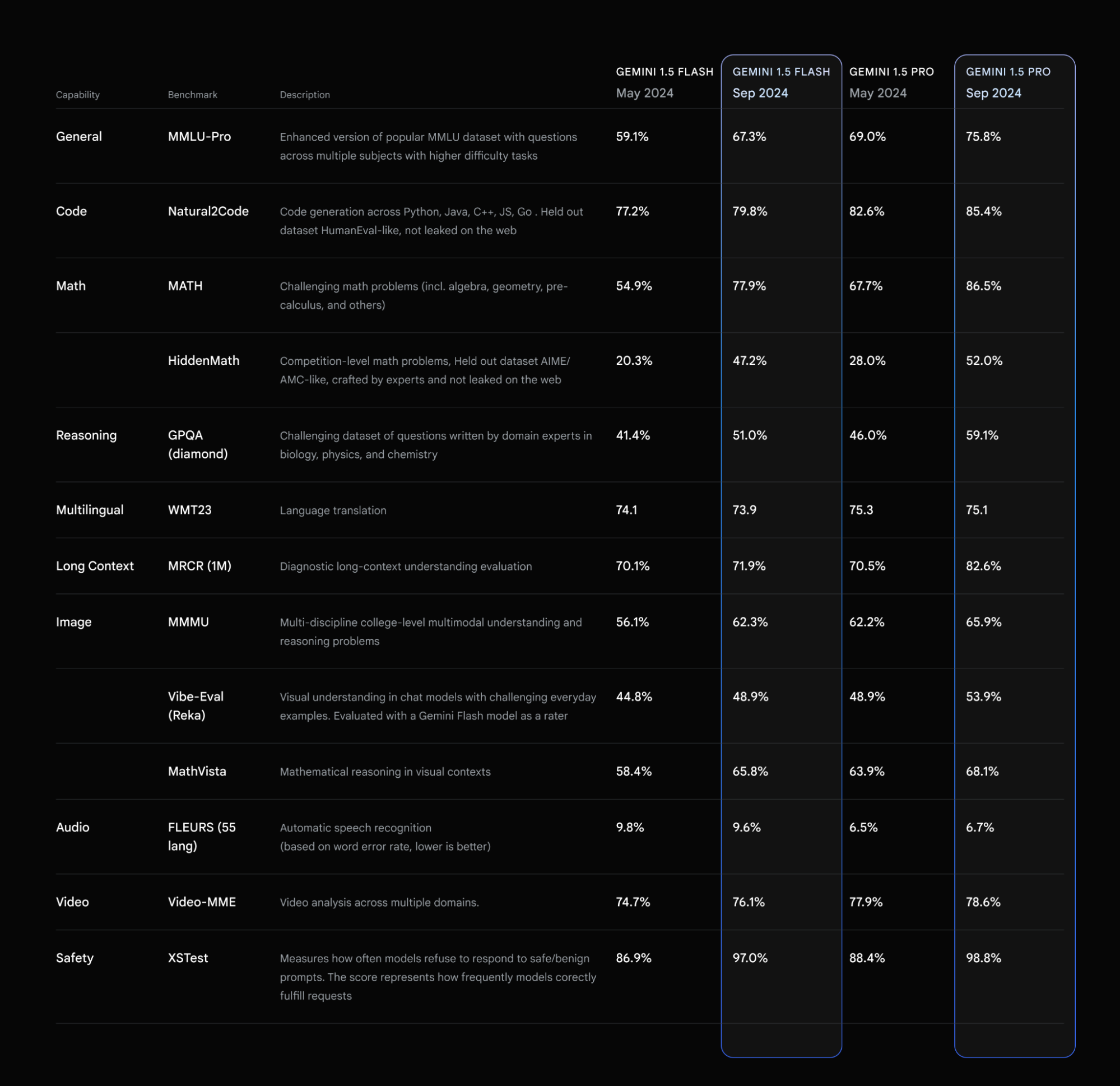

今回のアップデートで、1.5 Pro と Flash の質と速さが向上し、本番環境向けにこれまで以上に費用対効果が高い形で開発できるようになりました。人気の MMLU ベンチマークの高難易度版である MMLU-Pro で最大 7% の改善が見られ、MATH と HiddenMath(非公開の競技数学問題)ベンチマークでは、両方のモデルで最大 20% という大幅な改善を達成できました。視覚とコードのユースケースでも、視覚理解と Python コード生成の測定評価で、両方のモデルのパフォーマンスが向上しています(最大 2~7% の範囲)。

さらに、コンテンツの安全に関するポリシーと基準は引き続き遵守しつつ、モデルの応答の全般的な有用性が向上しています。つまり、さまざまなトピックにおいて、回答できなかったり拒否されたりするケースが少なくなり、役立つ回答が増えるということです。

デベロッパーからのフィードバックに応えて、どちらのモデルもスタイルが簡潔になりました。これは、モデルを使いやすくして費用を削減することを目的としたものです。要約、質問への回答、抽出といったユースケースで、アップデート版モデルのデフォルト出力長が短縮され、前のモデルよりも最大 5~20% 短くなっています。なお、チャットベースのプロダクトでは、デフォルトでユーザーが長い回答を希望する可能性があります。モデルを冗長的、会話的にする詳しい方法は、プロンプト戦略ガイドをご覧ください。

最新バージョンの Gemini 1.5 Pro および 1.5 Flash に移行する詳しい方法は、Gemini API モデルのページをご覧ください。

Gemini 1.5 Pro の 200 万トークン ロング コンテキスト ウィンドウとマルチモーダル機能を活用したクリエイティブで便利なアプリケーションには、今でも圧倒されています。動画の解釈や 1000 ページの PDF の処理など、たくさんの新しいユースケースが構築され続けています。本日は、1.5 シリーズの最強モデルである Gemini 1.5 Pro について、入力トークンで 64%、出力トークンで 52%、インクリメンタル キャッシュに保存されたトークンで価格を 64% 引き下げることをお知らせします。新しい価格は、2024 年 10 月 1 日より、プロンプトが 128K トークン未満の場合に適用されます。コンテキスト キャッシングと組み合わせて使うことで、Gemini を使った開発の費用はますます下がります。

デベロッパーの皆さんが Gemini を使って簡単に開発できるように、有料版のレート制限を緩和し、1.5 Flash で 1,000 RPM から 2,000 RPM に、1.5 Pro で 360 RPM から 1,000 RPM にします。Gemini を使ってさらに多くのものを開発していただけるように、今後数週間以内に、Gemini API のレート制限をさらに緩和する予定です。

最新モデルの中核部分を改善するとともに、ここ数週間で 1.5 Flash のレイテンシを削減したことで、1 秒あたりの出力トークン数が大幅に増加しました。これにより、強力なモデルを使った新しいユースケースが可能になっています。

2023 年 12 月に Gemini を初めてリリースしてから、安全で信頼性の高いモデルを開発することを重視してきました。最新バージョンの Gemini(-002 モデル)では、安全性のバランスを取りながら、モデルがユーザーの指示に従うように改善を行なっています。そこで、今後も一連の安全フィルタを提供し、デベロッパーが Google のモデルに適用できるようにします。本日リリースされたモデルでは、デフォルトでフィルタが適用されないため、デベロッパーはユースケースに最適な構成を決定できるようになります。

8 月に発表した Gemini 1.5 モデルのさらなる改良版「Geminii-1.5-Flash-8B-Exp-0924」をリリースします。テキストとマルチモーダルの両方のユースケースでパフォーマンスが大幅に向上しており、Google AI Studio と Gemini API から利用できます。

すばらしいことに、デベロッパーの皆さんからは、1.5 Flash-8B について非常に肯定的なフィードバックが寄せられています。今後もデベロッパー フィードバックに基づき、試験運用版から本番リリースに向かうパイプラインの準備を進めていきます。

私たちは、今回のアップデートにとても期待しています。新しい Gemini モデルで皆さんが作るものが楽しみです。そして、Gemini Advanced ユーザーの皆さんは、まもなく Gemini 1.5 Pro-002 のチャット最適化バージョンにアクセスできるようになります。