生成 AI は、私たちのテクノロジーに対する期待を根本的に変えました。大規模なクラウドベースのモデルが驚異的な方法で作成、推論、支援する力を目にしてきました。しかし、次に起きる大きな技術的飛躍は、クラウドモデルを大きくすることだけではなく、そのインテリジェンスを身近な個人向け環境に直接組み込むことです。AI が真のアシスタントとなる(私たちの日常をプロアクティブに支援する、リアルタイムで会話を翻訳する、身体的な状況を理解するなど)には、私たちが身につけて持ち歩くデバイス上で動作する必要があります。ここで重要な課題が浮かび上がります。それは、アンビエント AI をバッテリー容量に制約のあるエッジデバイスに組み込み、クラウドから解放することで、真にプライベートな終日支援体験を可能にするということです。

クラウドからパーソナル デバイスに移行するにあたり、次の 3 つの重要な問題を解決する必要があります。

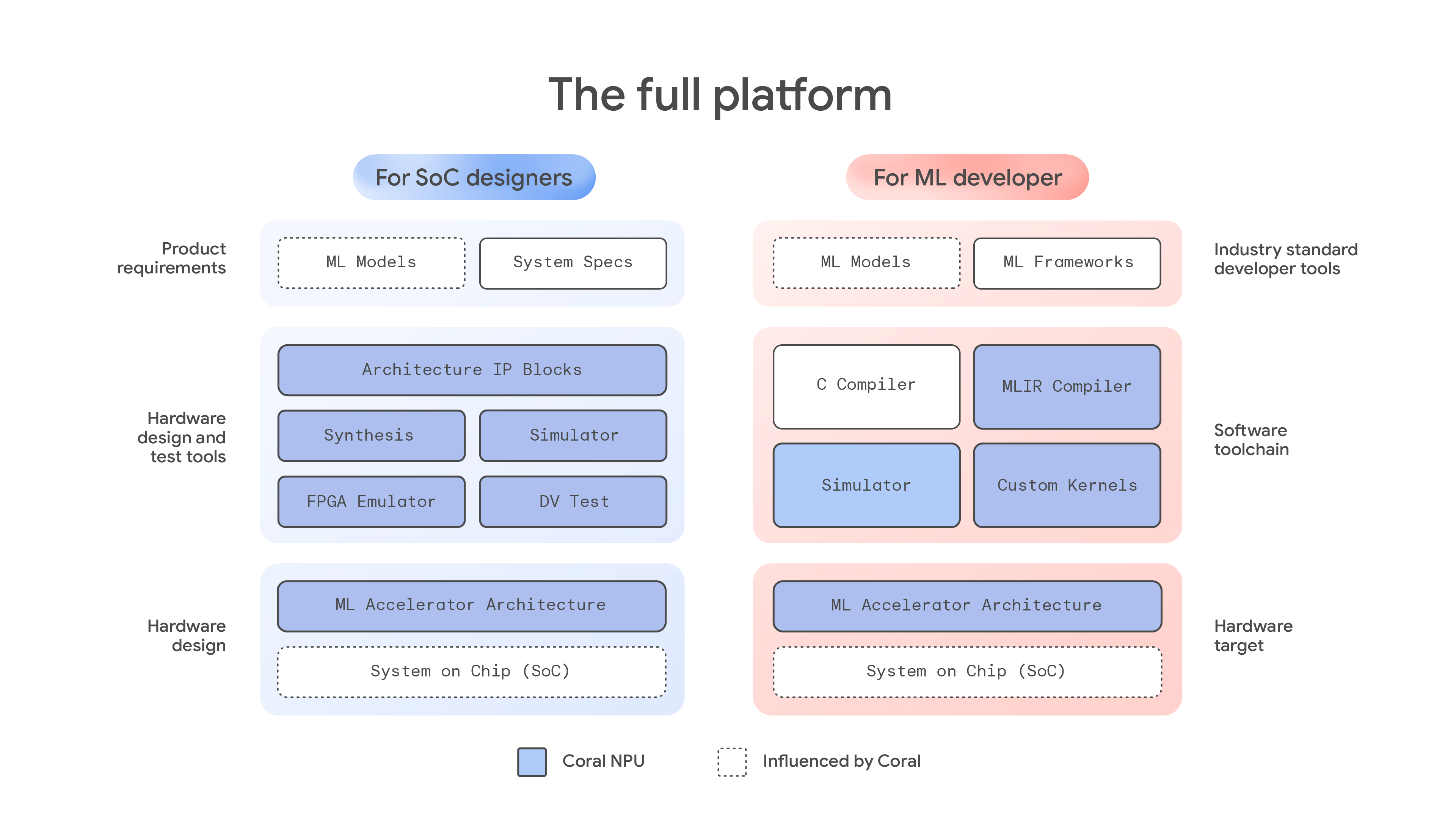

本日は、Coral NPU をご紹介します。Coral NPU は、Coral のオリジナル成果に基づいて構築されたフルスタック プラットフォームで、次世代のプライベートで効率的なエッジ AI デバイスの構築に必要なツールをハードウェア デザイナーや ML デベロッパーに提供します。Google Research および Google DeepMind と共同で設計された Coral NPU は、次世代の超低消費電力、常時稼働のエッジ AI を実現するために構築された AI ファーストのハードウェア アーキテクチャです。統合されたデベロッパーエクスペリエンスを提供し、アンビエント センシングなどのアプリケーションのデプロイを容易にします。ウェアラブル デバイス上で一日中 AI を活用できるように特別に設計されており、バッテリー使用量を最小限に抑え、より高いパフォーマンスのユースケースに合わせて構成可能です。デベロッパーやデザイナーが今日から構築を開始できるように、ドキュメンテーションとツールをリリースしました。

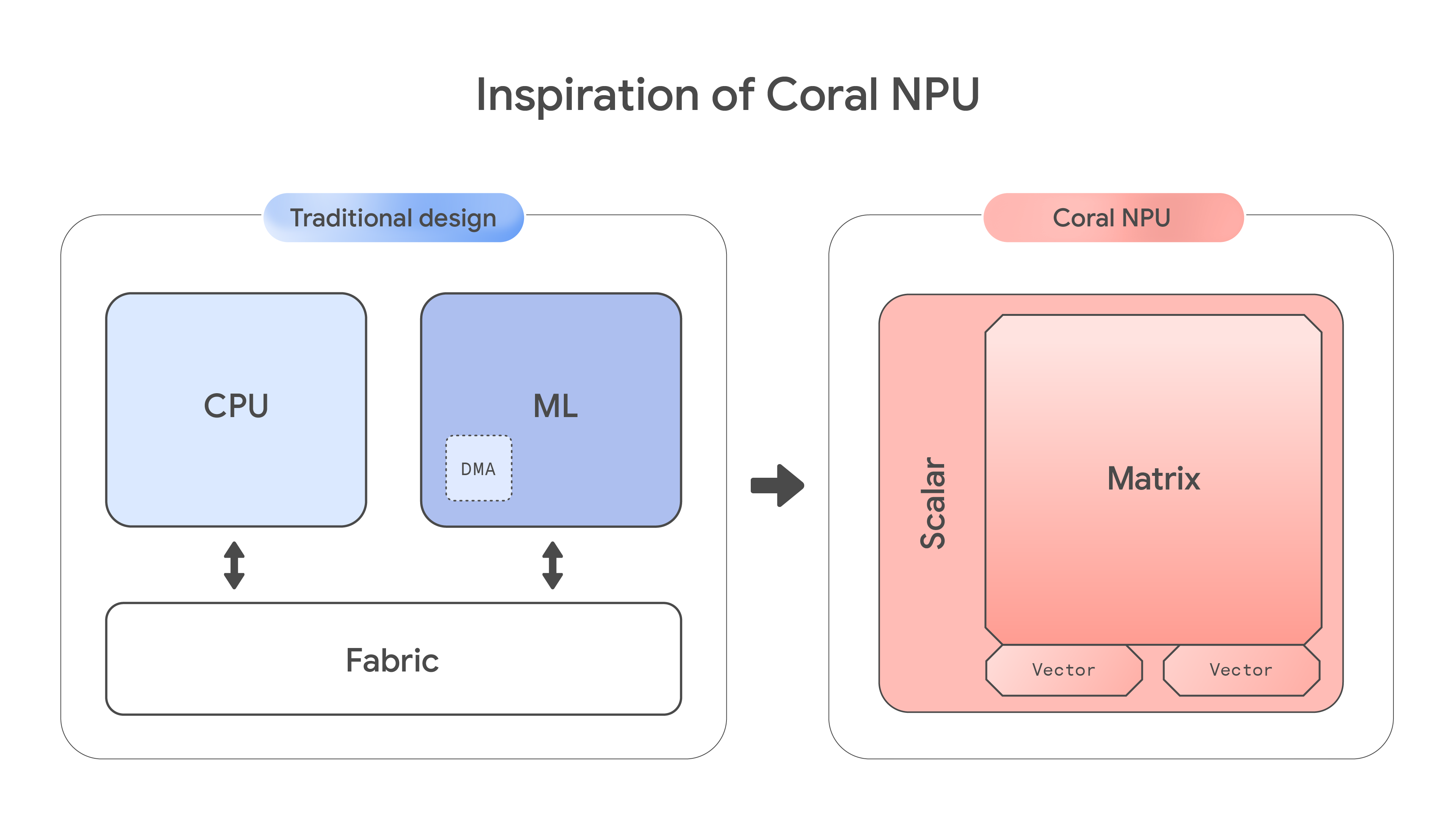

低消費電力エッジデバイス向けに構築しているデベロッパーは、汎用 CPU と専用アクセラレータのどちらかを選択するという根本的なトレードオフに直面します。汎用 CPU は、高い柔軟性と広範なソフトウェア サポートを提供しますが、要求の厳しい ML ワークロードに対応するドメイン固有のアーキテクチャが不足しているため、パフォーマンスと電力効率が低下します。一方、専用アクセラレータは、高い ML 効率を提供するものの、柔軟性に欠け、プログラミングが困難であり、一般的なタスクには適していません。

このハードウェアの問題は、非常に断片化されたソフトウェア エコシステムによってさらに深刻化しています。CPU と ML ブロックのプログラミング モデルがまったく異なるため、デベロッパーは独自のコンパイラと複雑なコマンド バッファの使用を余儀なくされることがよくあります。これにより、習得に非常に時間がかかることになり、異なるコンピューティング単位数の独自な強みを組み合わせることが困難になります。その結果、業界には、複数の ML 開発フレームワークを簡単かつ効果的にサポートできる、成熟した低消費電力アーキテクチャが不足しています。

Coral NPU アーキテクチャは、従来のチップ設計を逆転させることで、この問題に直接対処します。スカラー コンピューティングよりも ML マトリックスエンジンを優先することで、シリコンから AI 向けにアーキテクチャを最適化し、より効率的なデバイス上の推論のために特化したプラットフォームを構築します。

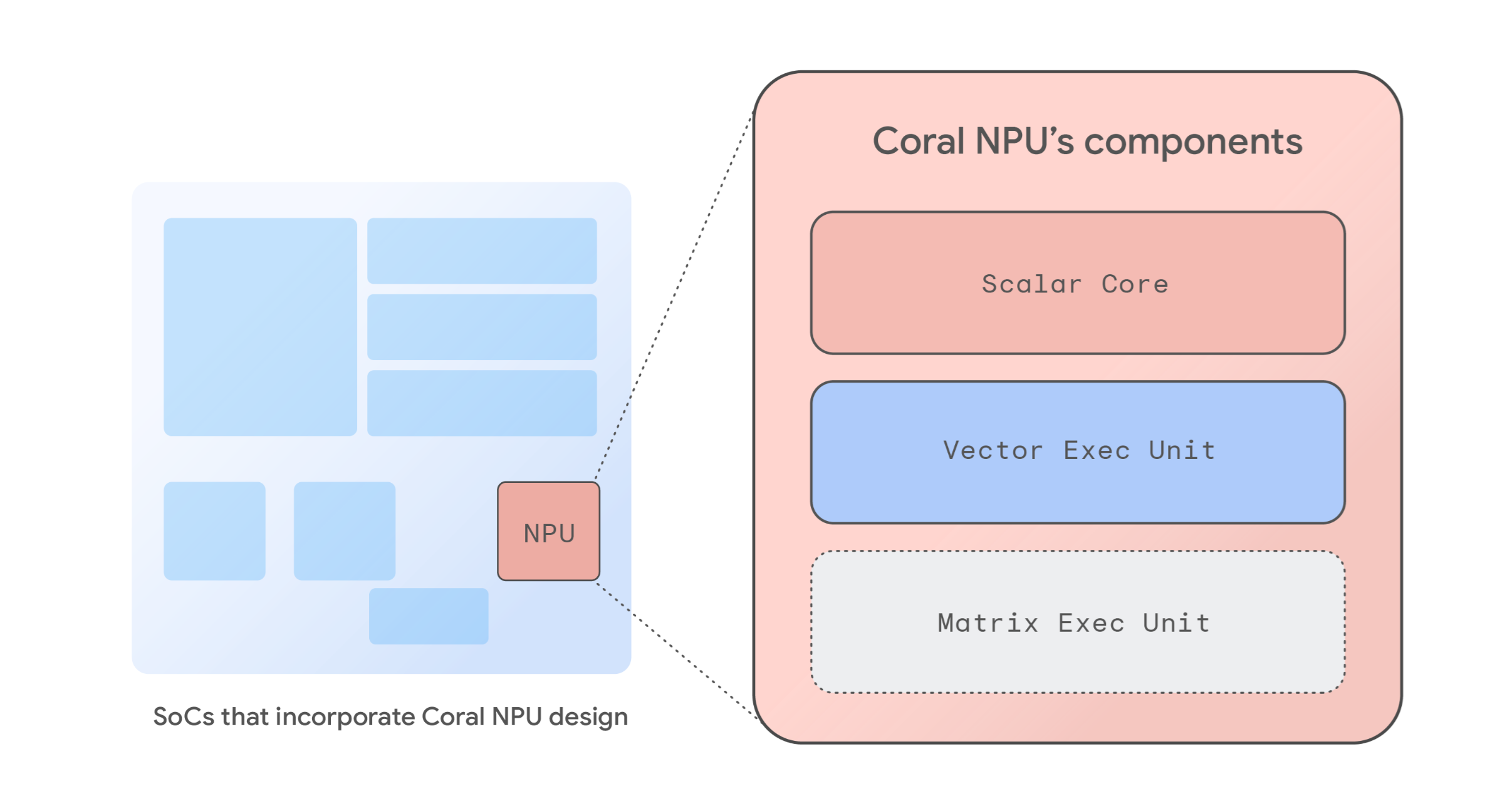

Coral NPU は、完全なリファレンス ニューラル プロセッシング ユニット(NPU)アーキテクチャとして、次世代のエネルギー効率の高い ML 最適化システム オン チップ(SoC)の構成要素を提供します。このアーキテクチャは、RISC - VISA 準拠のアーキテクチャ IP ブロックに基づいており、消費電力を最小限に抑えるように設計されているため、常時接続の環境センシングに最適です。基本設計は、わずか数ミリワットの消費電力で 512 GOPS(1 秒間に 10 億回の演算を行うことを示す単位)のパフォーマンスを実現し、エッジデバイス、ヒアラブル、AR メガネ、およびスマートウォッチ向けの強力なオンデバイス AI を可能にします。

RISC - V に基づくオープンで拡張可能なアーキテクチャにより、SoC 設計者は基本設計を変更したり、事前構成された NPU として使用したりできます。Coral NPU アーキテクチャには、次のコンポーネントが含まれています。

Coral NPU アーキテクチャは、IREE や TFLM などの最新のコンパイラとシームレスに統合できる、シンプルで C プログラマブルなターゲットです。これにより、TensorFlow、JAX、PyTorch などの ML フレームワークを簡単にサポートできます。

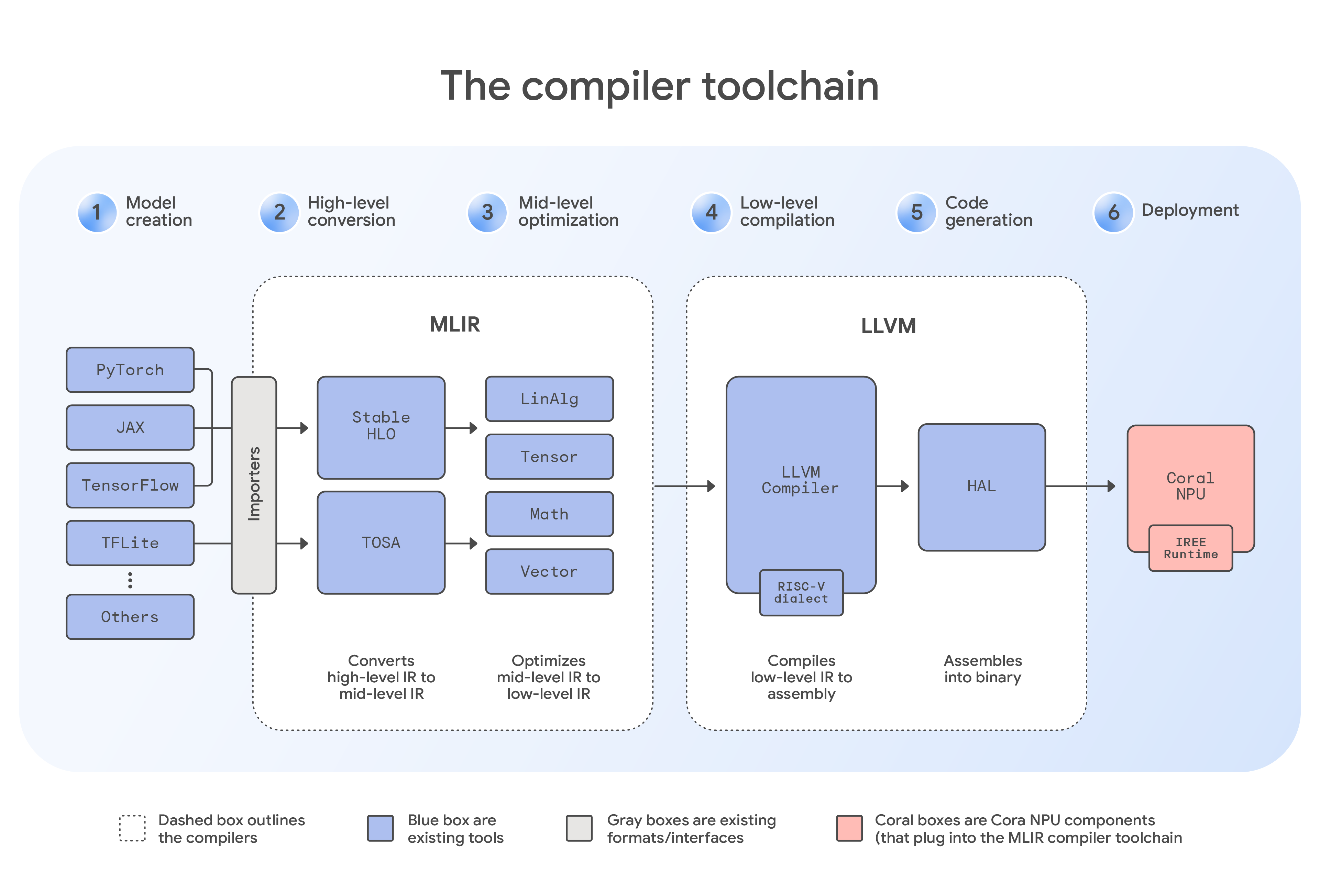

Coral NPU には、TensorFlow 用の TFLM コンパイラなどの特殊なソリューションに加えて、汎用 MLIR コンパイラ、C コンパイラ、カスタム カーネル、シミュレータを含む包括的なソフトウェア ツールチェーンが組み込まれています。これにより、デベロッパーに柔軟な pathway が提供されます。たとえば、JAX のようなフレームワークからのモデルは、まず StableHLO ダイアレクトを使用して MLIR 形式にインポートされます。次に、この中間ファイルが IREE コンパイラに送られ、ハードウェア固有のプラグインが適用されて Coral NPU のアーキテクチャが認識されます。そこから、コンパイラはプログレッシブ ローイングを実行します。これは、一連のダイアレクトを通じてコードが体系的に変換され、マシンのネイティブ言語に近づくという重要な最適化ステップです。最適化後、ツールチェーンは、エッジデバイス上で効率的に実行するための最終的なコンパクトなバイナリ ファイルを生成します。この業界標準のデベロッパー ツールスイートは、ML モデルのプログラミングを簡素化し、さまざまなハードウェア ターゲットにわたって一貫したエクスペリエンスを可能にします。

Coral NPU の共同設計プロセスは、2 つの主要分野に焦点を当てています。まず、このアーキテクチャは、今日のオンデバイスビジョンおよびオーディオ アプリケーションで使用されている主要なエンコードベースのアーキテクチャを効率的に高速化します。次に、Gemma チームと緊密に連携して、小型変圧器モデル向けに Coral NPU を最適化し、アクセラレータ アーキテクチャがエッジで次世代の生成 AI を確実にサポートできるようにしています。

この 2 つの焦点により、Coral NPU は、ウェアラブルに LLM を搭載するために設計された、オープンで標準ベースの低消費電力 NPU として初の製品となる見込みです。デベロッパーにとっては、最小限の電力で最大限のパフォーマンスで現行および将来のモデルの両方をデプロイするための単一の検証済みパスが提供されることになります。

Coral NPU は、特に環境センシングシステムに焦点を当てた、超低消費電力の常時稼働のエッジ AI アプリケーションを可能にするように設計されています。その主な目標は、ウェアラブル、スマートフォン、モノのインターネット(IoT)デバイスで一日中 AI 体験を提供し、バッテリー使用量を最小限に抑えることです。

潜在的なユースケースには、次のようなものがあります。

Coral NPU のコア原則は、ハードウェアによるセキュリティ強化を通じてユーザーの信頼を構築することです。当社のアーキテクチャは、きめ細かいメモリレベルの安全性とスケーラブルなソフトウェア区分化を提供する CHERI のような新興テクノロジーをサポートするように設計されています。このアプローチにより、機密性の高い AI モデルと個人データをハードウェアによるサンドボックスに隔離し、メモリベースの攻撃を軽減できるようにしたいと考えています。

オープン ハードウェア プロジェクトの成功には、強力なパートナーシップが不可欠です。そのため、当社の最初の戦略的シリコン パートナーであり、IoT 向け組み込みコンピューティング、ワイヤレス接続、マルチモーダル センシングのリーダーである Synaptics 社と協業しています。本日、Tech Day において Synaptics 社は AI ネイティブ IoT プロセッサの新製品 Astra™ SL 2610 ラインを発表しました。この製品ラインには、Coral NPU アーキテクチャの業界初の本番実装である Torq™ NPU サブシステムが搭載されています。NPU はトランスフォーマー対応で、動的演算子をサポートしているため、デベロッパーはコンシューマーおよび産業用 IoT 向けの将来を見据えたエッジ AI システムを構築できます。

このパートナーシップは、統一されたデベロッパー エクスペリエンスへのコミットメントを裏付けるものです。Synaptics Torq™ Edge AI プラットフォームは、IREE と MLIR をベースとしたオープンソース コンパイラとランタイム上に構築されています。このコラボレーションは、インテリジェントでコンテキストに対応したデバイスのための共有されたオープン スタンダードを構築するための重要な一歩です。

Coral NPU では、パーソナル AI の未来を支える基礎レイヤを構築しています。私たちの目標は、業界全体で活用できる、オープンソースかつ安全な共通プラットフォームを提供することで、活気に満ちたエコシステムを育むことです。これにより、デベロッパーとシリコン ベンダーは、今日の断片化された環境を乗り越え、エッジ コンピューティングの共有標準で協力し、より迅速なイノベーションを可能にします。Coral NPU の詳細をご覧になり、今すぐ構築を始めましょう。

この取り組みの中心的な貢献者とリーダーシップ チーム、特に Billy Rutledge、Ben Laurie、Derek Chow、Michael Hoang、Naveen Dodda、Murali Vijayaraghavan、Gregory Kielian、Matthew Wilson、Bill Luan、Divya Pandya、Preeti Singh、Akib Uddin、Stefan Hall、Alex Van Damme、David Gao、Lun Dong、Julian Mullings - Black、Roman Lewkow、Shaked Flur、Yenkai Wang、Reid Tatge、Tim Harvey、Tor Jeremiassen、Isha Mishra、Kai Yick、Cindy Liu、Bangfei Pan、Ian Field、Srikanth Muroor、Jay Yagnik、Avinatan Hassidim、Yossi Matias に感謝の意を表します。