本日、最先端のロボット身体性推論モデル Gemini Robotics-ER 1.5 をすべてのデベロッパーに提供開始します。Gemini Robotics モデル初の一般公開で、ロボットの高度な推論モデルとして機能します。

今回のモデルは視覚・空間理解、タスク計画、進捗推定など、ロボット工学に欠かせない機能に特化しています。さらに Google Search などのツールをネイティブで呼び出して情報を検索できるほか、視覚・言語モデル(VLA)やその他サードパーティのユーザー定義関数を呼び出してタスクを実行することが可能です。

Google AI Studio と Gemini API で、プレビュー版の Gemini Robotics - ER 1.5 を使った開発を今すぐ開始いただけます。

このモデルは、ロボットでの難題として知られるタスク向けに設計されています。たとえば、ロボットに「ここにある物体をコンポスト、リサイクル、ゴミ箱に正しく分別して」と指示したとしましょう。ロボットがこのタスクを完了するには、まずインターネットで現地のリサイクル規則を調べ、目の前にある物体を認識し、現地のルールに基づいて分別する方法を理解して、それぞれを分別する一連の動作を完了する必要があります。このような日常タスクの大半はコンテキスト情報と複数のステップで完了します。

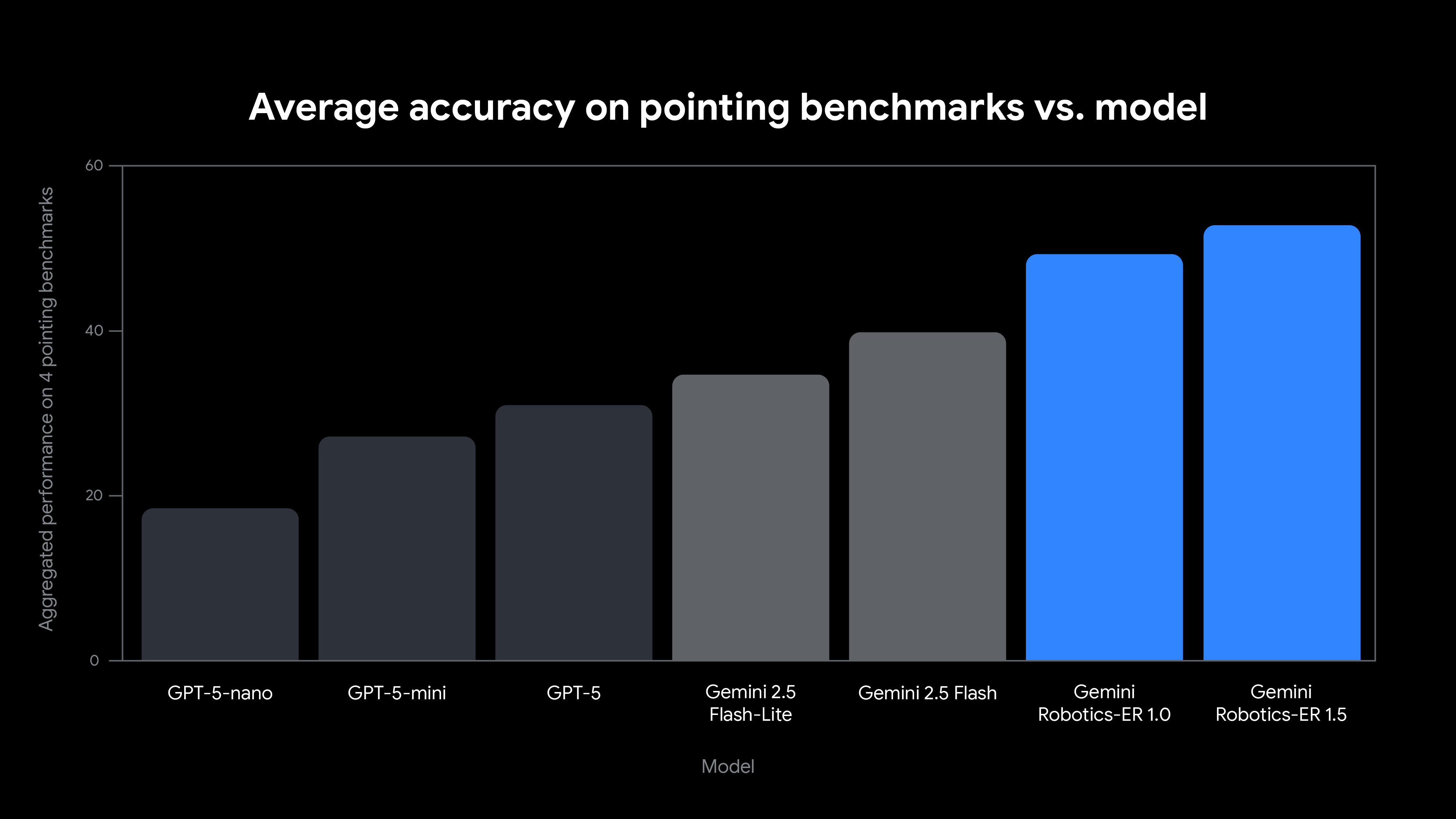

こうした身体性推論に初めて最適化されたモデルが Gemini Robotics-ER 1.5 です。Trusted Tester プログラムの実際のユースケースに触発され、学術研究と社内のベンチマーク両方で最高水準のパフォーマンスを達成しています。

Gemini Robotics - ER 1.5 は、ロボット アプリケーションの用途に合わせて調整されており、次のような新しい機能が導入されています。

Gemini Robotics-ER 1.5 はロボットの高水準なブレーンとみなすことができます。自然言語の複雑なコマンドを理解し、長期的なタスクを推論して、高度な動作をオーケストレーションします。つまり、単なる認識にとどまらず、シーンに何があるのか、それについて何をすべきかを理解します。

Gemini Robotics-ER 1.5 は「テーブルをきれいにして」といった複雑な要求を計画に落とし込んで、ロボットのハードウェア API、物体をつかむ特殊モデル、モーター制御のための視覚・言語・行動(VLA)モデルなど、そのジョブに適したツールを呼び出します。

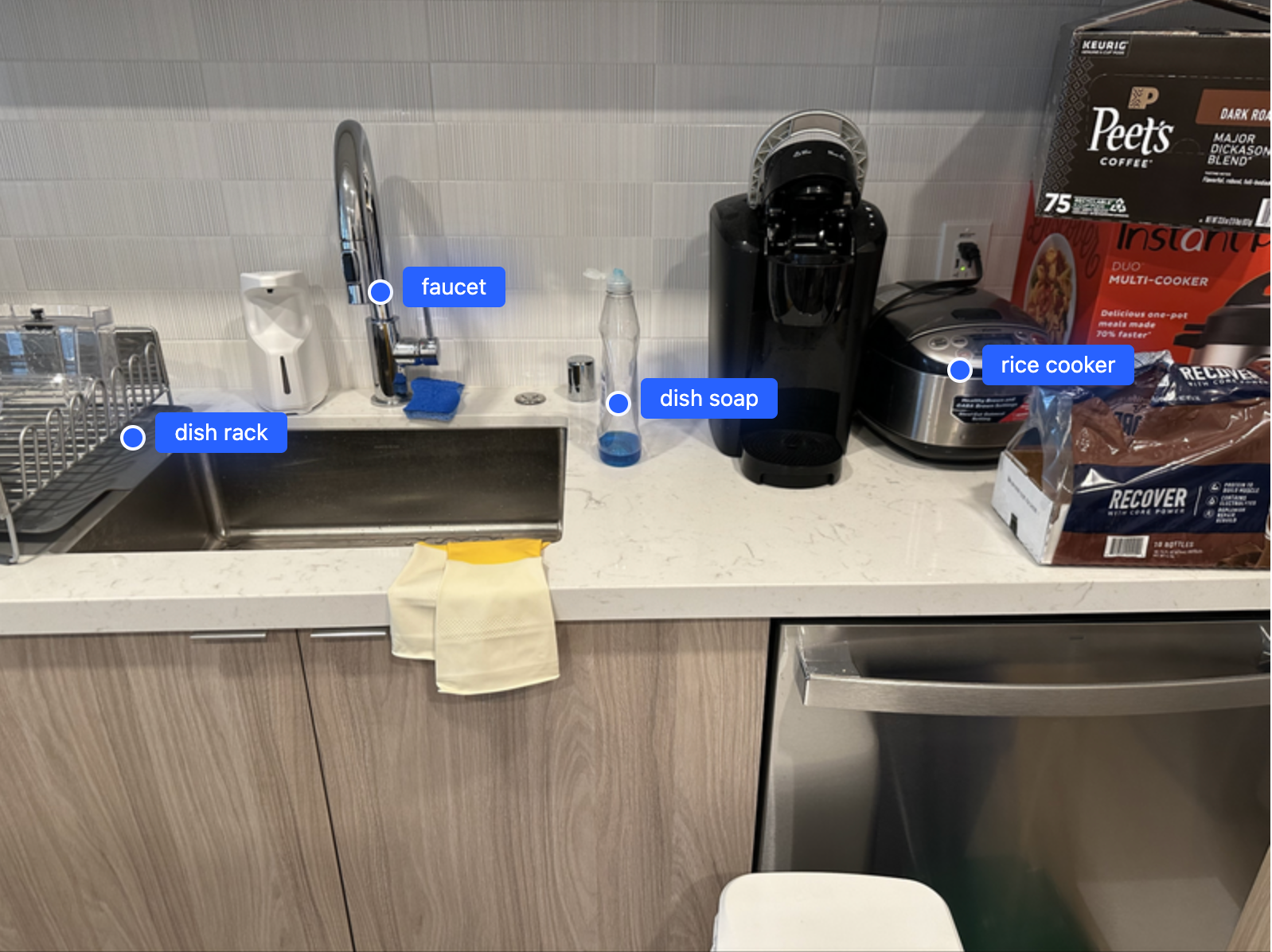

ロボットが周囲の物理世界を操作できるようにするには、存在する場所の環境を認識、理解できる必要があります。Gemini Robotics - ER 1.5 は、高品質の空間結果を生成するよう微調整されており、モデルは物体の正確な 2D ポイントを生成できます。Gemini GenAI SDK for Python を使用して、独自のアプリケーションでこのモデルを使い始めるのに役立つ例をいくつかご紹介します。

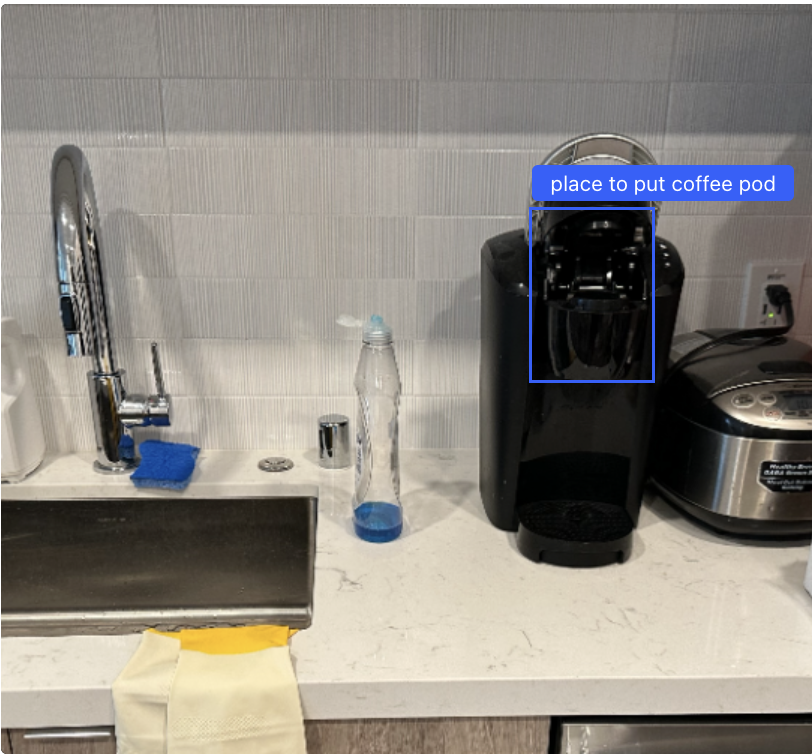

キッチンシーンの画像を与えると、Gemini Robotics-ER 1.5 はすべての物体(または物体の一部)の位置を提供します。この情報をロボットの 3D センサーと組み合わせて空間での物体の正確な位置を特定し、計画ライブラリで正確な動作経過を生成できるようにします。

プロンプト:

Point to the following items in the image: dish soap, dish rack, faucet, rice cooker, unicorn. The points are in [y, x] format normalized to 0-1000. Only include objects that are actually present in the image."要求されたアイテムで、画像に表示されているものだけを含めるようモデルに指示した点に注目してください。これにより、要求されたものの存在しないユニコーンに対してのポイントを含めるようなハルシネーションを防ぎ、モデルで表示可能な現実が常に基準となります。この手法は動画ストリームの物体の状態出力にも当てはめることができます。フレーム内で表示され、開いている、あるいは閉じているなど、特定の状態にある物体のみを強調表示します。以下は、空間理解と状態推定を組み合わせたクエリで「緑色のマーカー、茶色のトレイ、緑色のノートブック、ノートパソコン(開いた状態)、ノートパソコン(閉じた状態)、メガネケース(開いた状態)、メガネケース(閉じた状態)」を示すようモデルに指示した動画です。

オブジェクトを見つけることは不可欠ですが、真の時空推論には、オブジェクトとアクションが時間経過とともに展開するときの関係を理解することが含まれます。Gemini Robotics - ER 1.5 はこの点が優れており、物理世界での原因と影響を理解するために動画を処理します。たとえば、次の動画では、一対のロボットアームが緑色のマーカーを木製のトレイに移動させ、次に青色と赤色のペンを円筒形の容器に移動させます。シーケンスを確認し、どのタスクがどのような順序で実行されたか、2 つのタイムスタンプの間にどのタスクが発生したかをモデルに指示すると、正しい回答が得られます。これは、シーン内にある物体を認識するだけでなく、シーン内での発生事象を推論する能力を示しています。

プロンプト:

Describe in detail each step of finishing the task. Breaking it down by timestamp, output in json format with keys "start_timestamp", "end_timestamp" and "description".応答:

[

{

"start_timestamp": "00:02",

"end_timestamp": "00:13",

"description": "The left robotic arm picks up the green marker from the table and places it into the wooden tray."

},

{

"start_timestamp": "00:15",

"end_timestamp": "00:22",

"description": "The left robotic arm picks up the blue pen from the table and places it into the black mesh pen cup."

},

{

"start_timestamp": "00:23",

"end_timestamp": "00:28",

"description": "The right robotic arm picks up the red pen from the table and places it into the black mesh pen cup, completing the task of organizing the writing utensils."

}

]>zoom into second 15 to 22 and provide a per-second breakdown of what is happening in the same format(15~22 秒をクローズアップし、何が起こっているかを秒単位で同じ形式で説明して)

[

{

"start_timestamp": "00:15",

"end_timestamp": "00:16",

"description": "The left robotic arm begins moving towards the blue pen located on the table to the left of the pen cup."

},

... (removed for brevity, please take a look at the video below)

{

"start_timestamp": "00:21",

"end_timestamp": "00:22",

"description": "The arm lowers the pen into the cup and releases it, placing it upright inside the container."

}

]出力は時間的に正確であり、元の動画にオーバーレイするとモデルがロボットの動きを正確に理解していることがわかります。

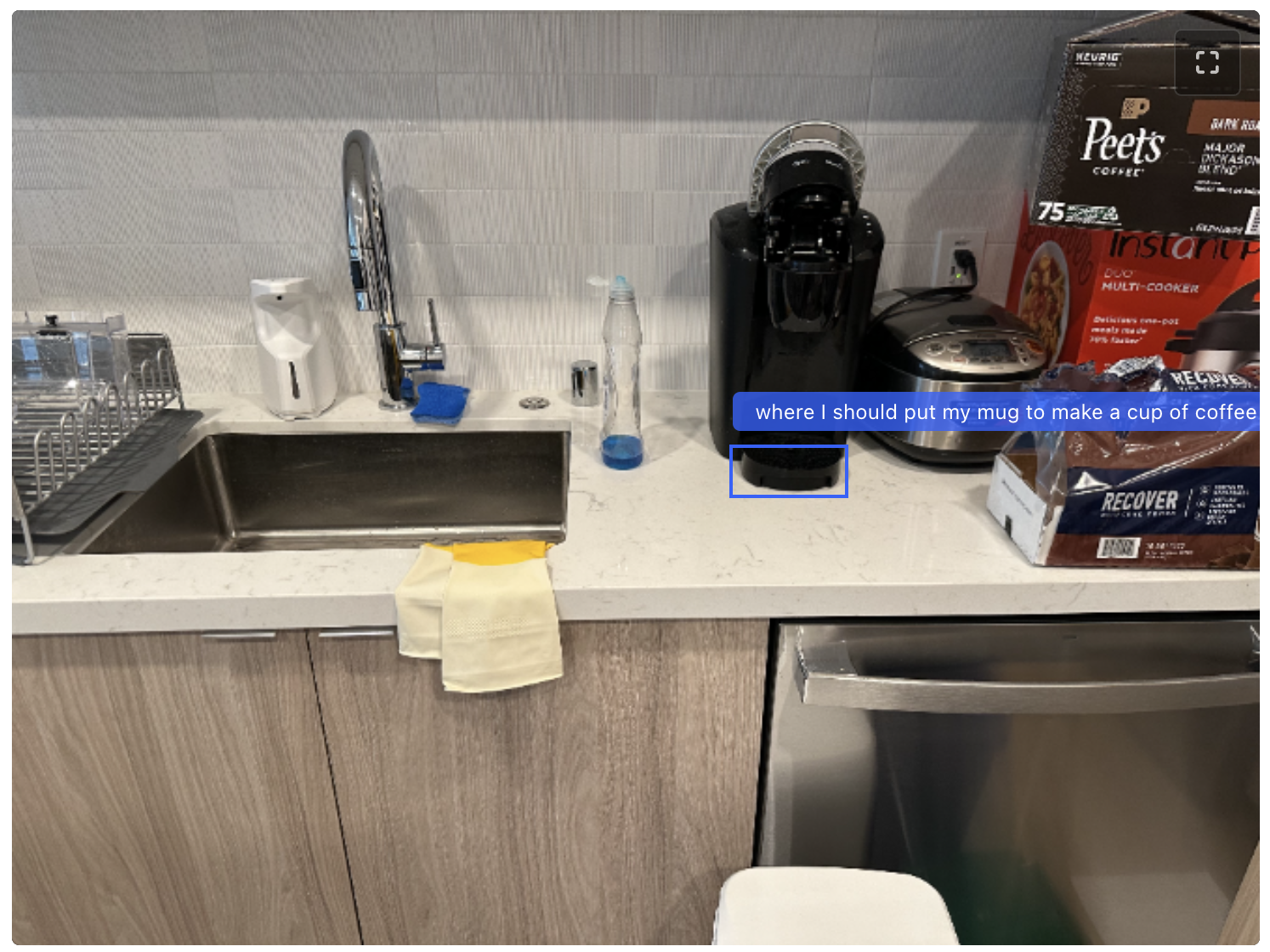

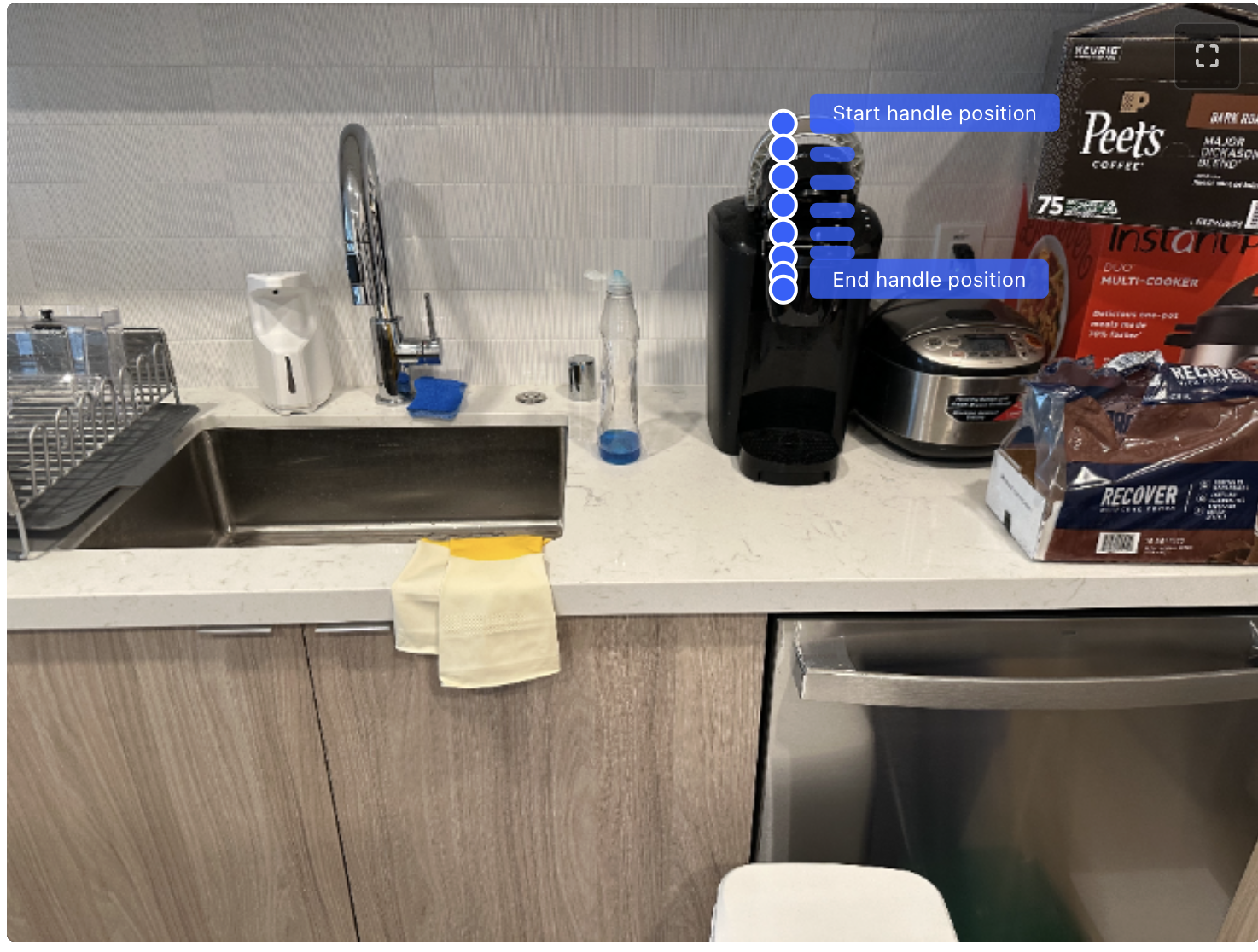

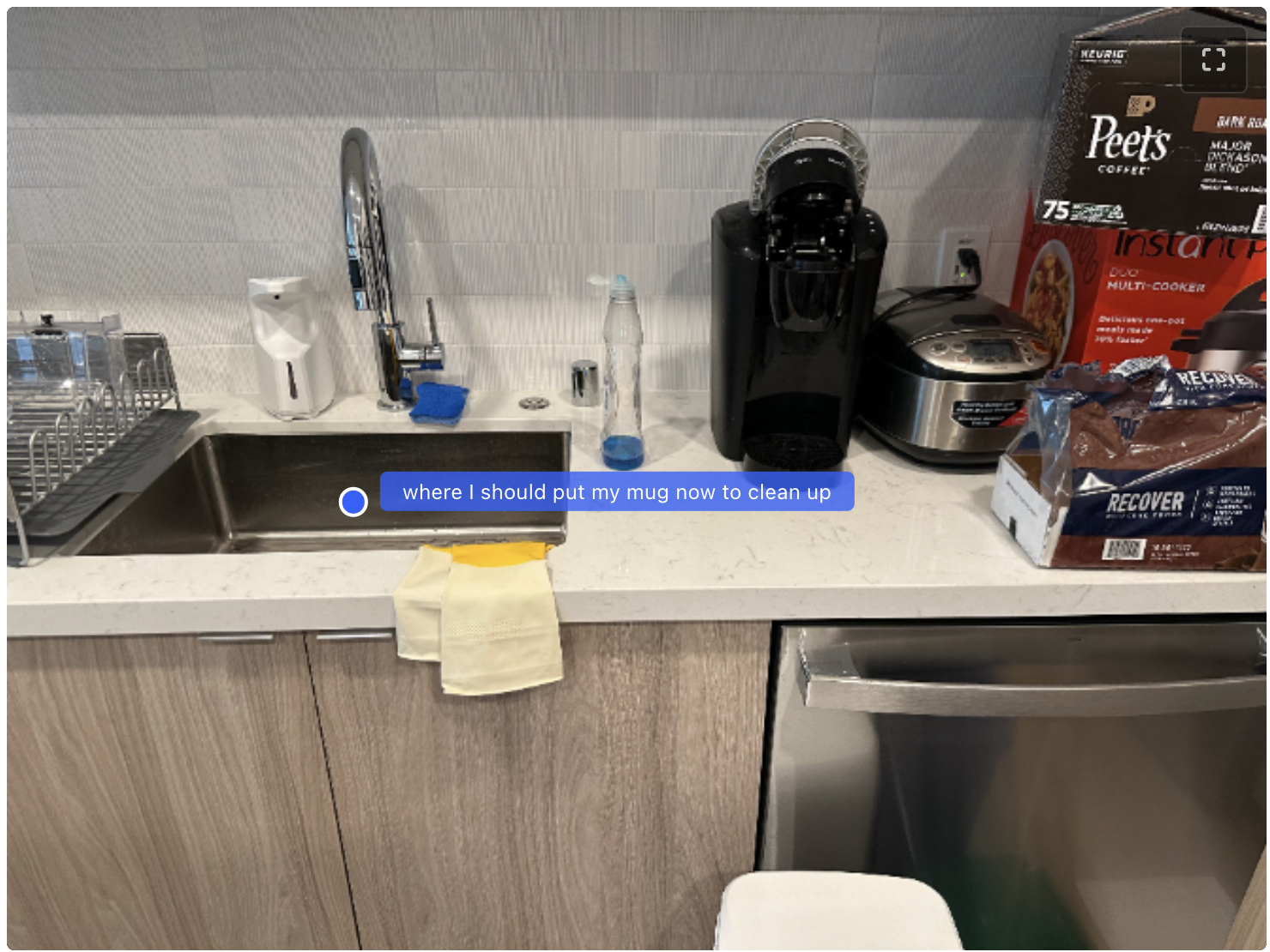

思考が有効になっている場合、モデルは複雑なポインティングと境界ボックスのクエリについて推論できます。ここでは、コーヒー作りの例で使用するステップバイステップのデモンストレーションをご紹介します。人間やロボットがタスクを完了するために必要な「方法」と「場所」を理解していることを示しています。

プロンプト:

Identify where I should put my mug to make a cup of coffee. Return a list of JSON objects in the format: `[{"box_2d": [y_min, x_min, y_max, x_min], "label": <label>}]`, where the coordinates are normalized between 0-1000.応答:

Where should I put the coffee pod?応答:

Now, I need to close the coffee maker. Plot a trajectory of 8 points that indicates how the handle of the lid should move to close it. Start from the handle. Points are [Y,X] in normalized coordinates [0 - 1000]. Please output all points, including the trajectory points in the format. [{"point": [Y, X], "label": }, {"point": [Y, X], "label": }, ...].応答:

I finished my coffee. Where should I put my mug now to clean up? Return a list of JSON objects in the format: [{"point": [y, x], "label": <label>}], where the coordinates are normalized between 0-1000.

ここでは、「空間的に接地された」計画を生成するために、計画と空間的接地を組み合わせた別の例を示します。簡単なプロンプト「ゴミ箱にゴミを分別する方法を説明してください。参照する各オブジェクトをポイントします。各ポイントは [{"point": [y, x], "label": }]、座標は 0~1000 に正規化された形式にしてください」を使って導きます。回答にはインターリーブされたテキストとポイントが含まれており、レンダリングすることでこのアニメーションを作成できます。

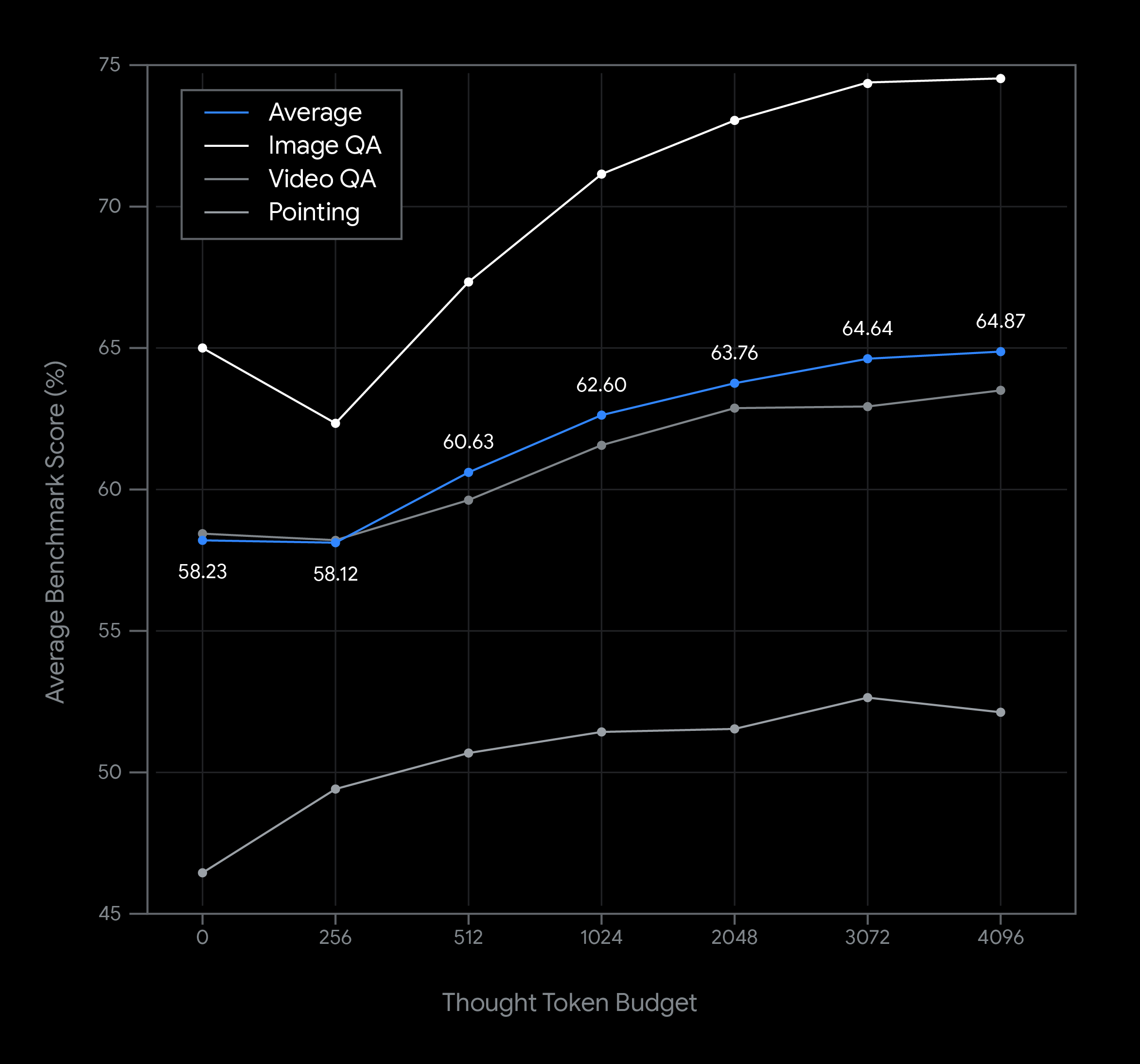

このグラフは、Gemini Robotics - ER 1.5 モデル使用時における思考予算の一連の変化の例と、レイテンシとパフォーマンスに対する影響を示しています。モデルのパフォーマンスは、思考トークンの予算が増加するにつれて向上します。物体検出のような単純な空間理解タスクでは非常に少ない思考予算でもパフォーマンスが高いのに対し、さらに複雑な推論は予算が大きい方がメリットがあります。これにより、デベロッパーは低レイテンシの応答の必要性と、より困難なタスクでの高精度な結果のバランスを取ることができます。

Gemini Robotics-ER 1.5 では思考がデフォルトで有効になっており、リクエストに thinking_config オプションを追加することで思考予算を設定したり、思考を無効にしたりもできます。Gemini の思考予算の詳細については、こちらをご覧ください。

Google はロボティクス アプリケーションのための責任ある基盤づくりに取り組んでいます。Gemini Robotics-ER 1.5 は安全性を大幅に改善しており、次の両方のフィルタを強化しました。

ただし、これらのモデルレベルでの安全保護策は、物理システムで要求される厳格な安全設計に代わるものではありません。Google は安全性に対して複数の保護層が連携して機能する「スイスチーズ アプローチ」を提唱しています。デベロッパーは、緊急停止、衝突回避、および徹底的なリスク評価を含む、ロボット工学の安全標準ベスト プラクティスを実装する責任があります。

Gemini Robotics - ER 1.5 は本日よりプレビュー版で利用可能になりました。ロボットの推論エンジンを開発するために必要な知覚・計画機能を提供します。

このモデルは、さらに幅広い Gemini Robotics システムの基本的な推論コンポーネントです。エンドツーエンドのアクション モデル(VLA)やクロスエンボディメント学習など、ロボット工学の今後のビジョンを支える科学を理解するには、リサーチブログと技術レポート全文をお読みください。