Llama 4 モデルをデプロイして管理するには、複雑なインフラストラクチャのセットアップ、GPU の可用性管理、スケーラビリティの確保、継続的な運用オーバーヘッドの処理など、複数の手順を踏む必要があります。こういった課題に対処し、アプリケーション開発だけに集中できるとしたらどうでしょう。Vertex AI ならそれが可能です。

Meta のオープン大規模言語モデルの最新世代である Llama 4 を、Vertex AI のフルマネージド API エンドポイントとして一般提供(GA)することをお知らせします。Llama 4 と合わせて、Vertex AI の Llama 3.3 70B マネージド APIも一般提供します。

マルチモーダル能力と非常に効率的な Mixture-of-Expert(MoE)アーキテクチャを搭載した Llama 4 は、これまでの Llama モデルを超える新たなパフォーマンス ピークを実現しています。Llama 4 Scout は、これまでのすべての世代の Llama モデルよりも強力であることに加えて、マルチモーダル タスクの効率が大幅にアップしており、単一 GPU 環境で実行できるように最適化されています。Llama 4 Maverick は、現在 Meta が提供する最もインテリジェントなモデル オプションで、推論、複雑な画像理解、高度な生成タスク向けに設計されています。

Llama 4 をフルマネージド API エンドポイントとすることで、Vertex AI の簡単さ、スケーラビリティ、信頼性を土台として Llama 4 の高度な推論、コーディング、命令遂行能力を活用できるため、これまで以上に洗練されたインパクトのある AI 搭載アプリケーションを開発することができます。

この投稿では、Llama 4 を Model-as-a-Service(MaaS)として利用する方法を説明します。また、主なメリットや簡単に利用できる点を紹介しつつ、費用についての考慮事項にも触れます。

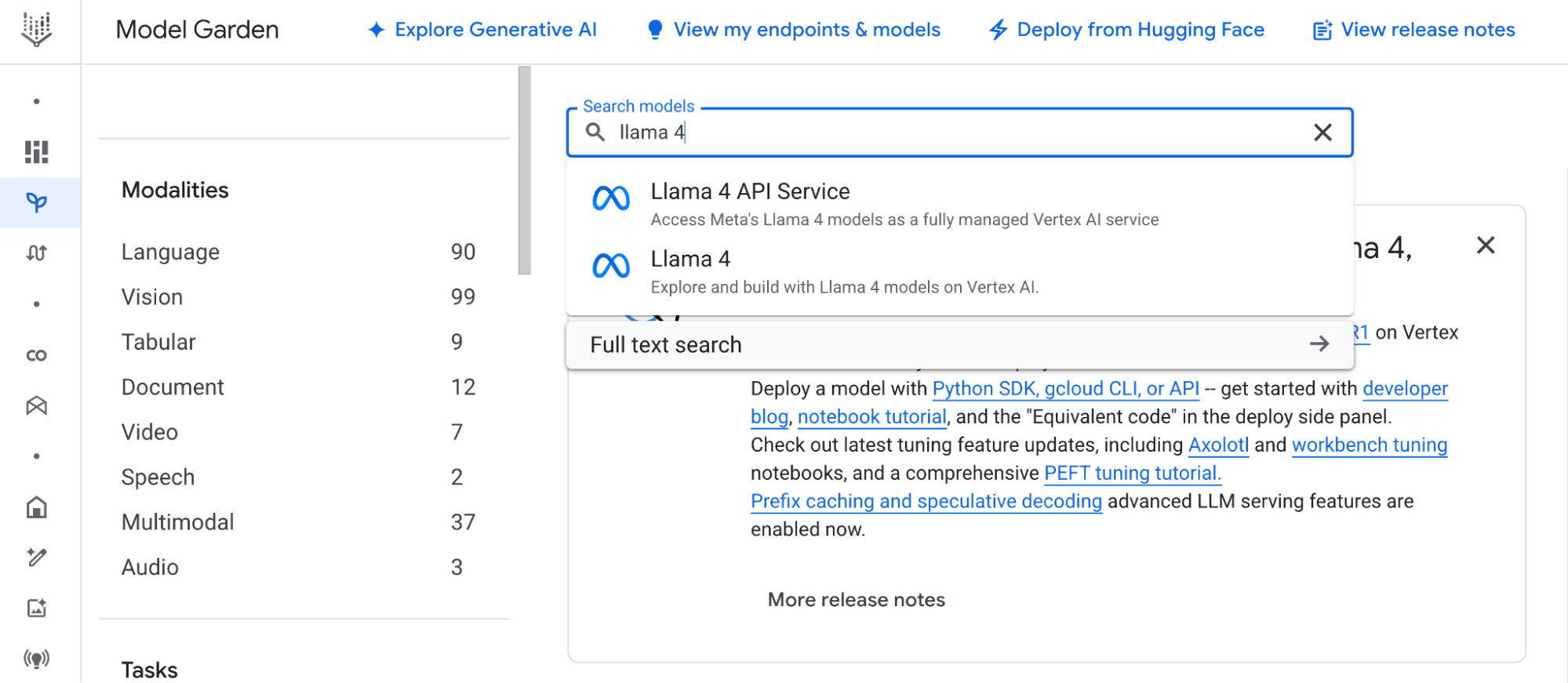

セントラル ハブである Vertex AI Model Garden を使うと、マネージド API から基盤モデルを探し、Google Cloud にデプロイできます。Google の専用モデル(Gemini など)、オープンソース モデル、サードパーティ モデルを厳選して提供しており、すべてシンプルなインターフェースからアクセスできます。Llama 4(GA)をマネージド サービスとして追加することで、選択肢の幅が広がり、柔軟性が向上しています。

Vertex AI で Model-as-a-Service(MaaS)として Llama 4 を使うと、次のようなメリットが得られます。

1: インフラ管理不要: 基盤となるインフラストラクチャ、GPU のプロビジョニング、ソフトウェアの依存関係、パッチ適用、メンテナンスは、Google Cloud がすべて管理してくれます。皆さんはシンプルな API エンドポイントとインタラクションするだけです。

2: パフォーマンス保証: モデルを利用できるだけの処理能力が割り当てられるので、高可用性が保証されます。

3: エンタープライズクラスのセキュリティとコンプライアンス: Google Cloud の堅牢なセキュリティ、データ暗号化、アクセス制御、コンプライアンス認定を活用できます。

Vertex AI で Llama 4 MaaS を使ってみたい方は、Vertex AI Model Garden で Llama 4 モデルカードを開き、Llama コミュニティ ライセンス契約に同意してください。この手順を完了しないと、API を呼び出すことはできません。

Model Garden で Llama コミュニティ ライセンス契約に同意したら、Vertex AI Model Garden で使いたい Llama 4 MaaS モデルを見つけます(「Llama 4 17B Instruct MaaS」など)。一意のモデル ID(meta/llama-4-scout-17b-16e-instruction-maas など)をメモしておいてください。API を呼び出すときに必要になります。

すると、ChatCompletion API を使って Llama 4 MaaS エンドポイントを直接呼び出せるようになります。MaaS では、個別に「デプロイ」を行う必要はありません。エンドポイントのプロビジョニングは、Google Cloud が行ってくれます。以下は、Python の ChatCompletion API から Llama 4 Scout を使う例です。

import openai

from google.auth import default, transport

import os

# --- Configuration ---

PROJECT_ID = "<YOUR_PROJECT_ID>"

LOCATION = "us-east5"

MODEL_ID = "meta/llama-4-scout-17b-16e-instruct-maas"

# Obtain Application Default Credentials (ADC) token

credentials, _ = default()

auth_request = transport.requests.Request()

credentials.refresh(auth_request)

gcp_token = credentials.token

# Construct the Vertex AI MaaS endpoint URL for OpenAI library

vertex_ai_endpoint_url = (

f"https://{LOCATION}-aiplatform.googleapis.com/v1beta1/"

f"projects/{PROJECT_ID}/locations/{LOCATION}/endpoints/openapi"

)

# Initialize the client to use ChatCompletion API pointing to Vertex AI MaaS

client = openai.OpenAI(

base_url=vertex_ai_endpoint_url,

api_key=gcp_token, # Use the GCP token as the API key

)

# Example: Multimodal request (text + image from Cloud Storage)

prompt_text = "Describe this landmark and its significance."

image_gcs_uri = "gs://cloud-samples-data/vision/landmark/eiffel_tower.jpg"

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": image_gcs_uri},

},

{"type": "text", "text": prompt_text},

],

}

]

# Optional parameters (refer to model card for specifics)

max_tokens_to_generate = 1024

request_temperature = 0.7

request_top_p = 1.0

# Call the ChatCompletion API

response = client.chat.completions.create(

model=MODEL_ID, # Specify the Llama 4 MaaS model ID

messages=messages,

max_tokens=max_tokens_to_generate,

temperature=request_temperature,

top_p=request_top_p,

# stream=False # Set to True for streaming responses

)

generated_text = response.choices[0].message.content

print(generated_text)

# The image contains...重要: 必ず Vertex AI Model Garden の Llama 4 モデルカードを確認してください。以下の重要な情報が含まれています。

Vertex AI で Llama 4 を Model-as-a-Service として利用する場合、従量課金と使用量割り当てを組み合わせた予測可能なモデルが適用されます。Vertex AI で Llama 4 MaaS を利用する際に、アプリケーションをスケーリングして費用を効果的に管理するには、料金構造とサービス割り当ての両方を理解する必要があります。

料金は、ご自身が行った予測リクエストに対してのみお支払いいただきます。基盤となるインフラストラクチャ、スケーリング、管理の費用は、API の利用料金に含まれています。詳しくは、Vertex AI の料金ページを参照してください。

サービスの安定性を確保し、使用量を公平に配分するため、Vertex AI で Llama 4 を Model-as-a-Service として利用する際には、割り当てが適用されます。具体的には、プロジェクトで特定のモデルのエンドポイントに対して行うことができる 1 分あたりのリクエスト数(RPM)などが制限されます。詳しくは、割り当てのドキュメントを参照してください。

Llama 4 が Vertex AI の Model-as-a-Service として一般提供されたことで、とりわけ先進的なオープン LLM を、必要なインフラストラクチャの管理なしで利用できるようになりました。

Vertex AI の Llama 4 で皆さんがどのようなアプリケーションを開発するのか楽しみです。Google Cloud コミュニティ フォーラムにご意見やご感想をお寄せください。