Google AI Studio で API キーを 取得し、Gemini API クックブックを使ってみよう

デベロッパーが Google AI Studio で次世代の Gemini 1.5 Pro モデルを試用できるようにしたのは、2 か月ほど前のことでした。私たちは、画期的な 100 万コンテキスト ウィンドウを使ってコミュニティがデバッグ、作成、学習したことを見て驚きました。

本日、Gemini 1.5 Pro を 180 か国以上で利用可能にします。Gemini API を使って公開プレビュー版として利用でき、初めてのネイティブ オーディオ(スピーチ)理解機能と、ファイルを簡単に処理できる新しいファイル API が含まれています。また、システム指示や JSON モードなどの新機能をリリースし、デベロッパーがモデルの出力をこれまで以上に細かく制御できるようにしています。最後に、同等のモデルを上回る次世代のテキスト埋め込みモデルをリリースします。Google AI Studio に移動して、API キーを作成またはアクセスし、開発を始めましょう。

Gemini 1.5 Pro の入力モダリティを拡張し、Gemini API と Google AI Studio の両方で、オーディオ(スピーチ)を理解できるようにします。さらに、Gemini 1.5 Pro は、Google AI Studio にアップロードしたビデオの画像(フレーム)と音声(スピーチ)の両方で推論を行うことができるようになりました。これをサポートする API は、近日中に追加する予定です。

本日、デベロッパーから特に多く寄せられているリクエストに対応します。

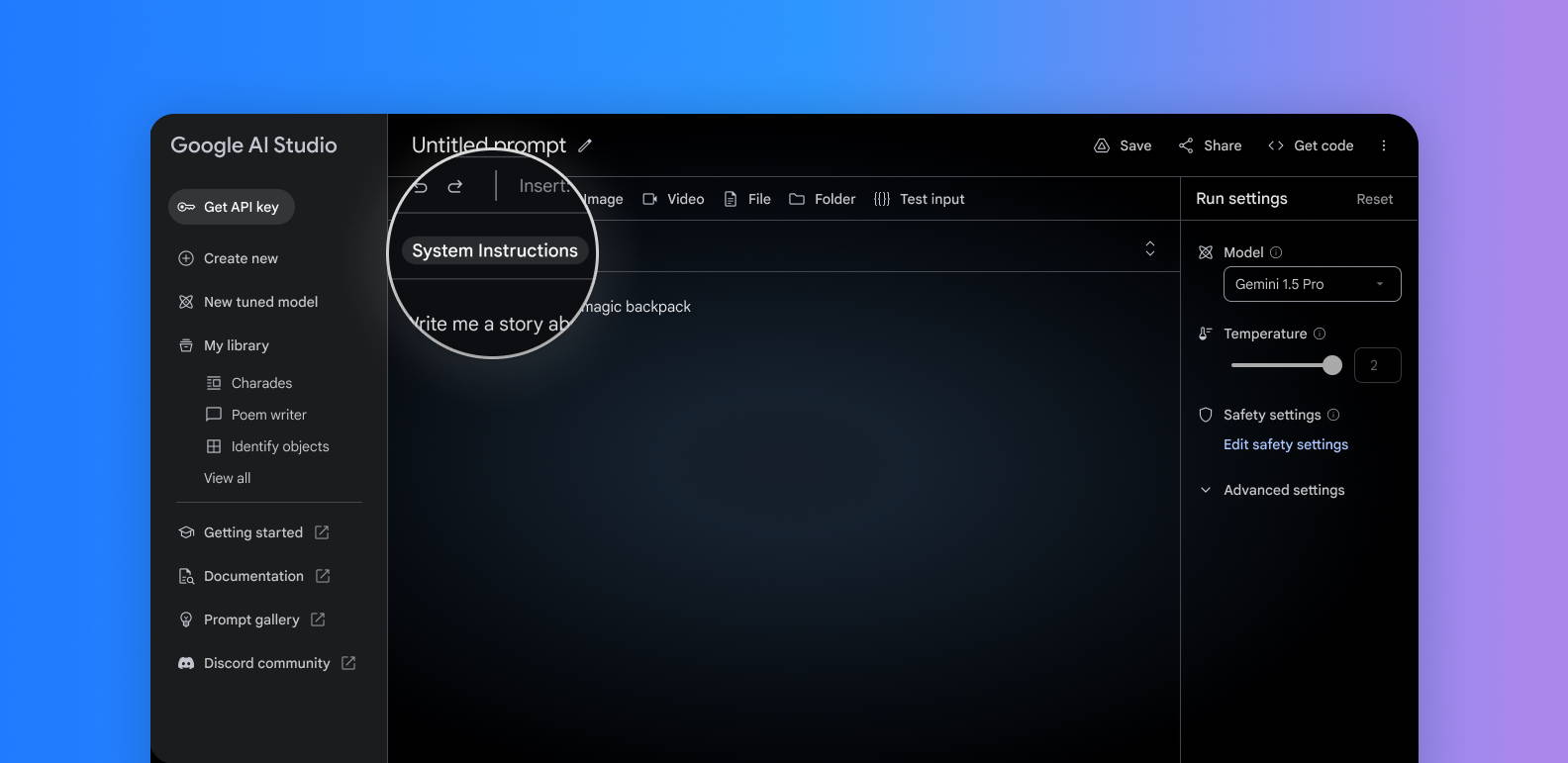

1. システム指示: Google AI Studio と Gemini API で利用できるシステム指示で、モデルの応答を制御します。役割、形式、目標、ルールを定義して、特定のユースケース向けにモデルの動作を制御できます。

2. JSON モード: JSON オブジェクトのみを出力するようにモデルに指示します。このモードでは、テキストや画像から構造化データを抽出できます。cURL で利用でき、まもなく Python SDK もサポートされます。

3. 関数呼び出しの改善: モデルの出力を制限するモードを選択できるようになり、信頼性が向上しました。テキスト、関数呼び出し、または関数自体を選択します。

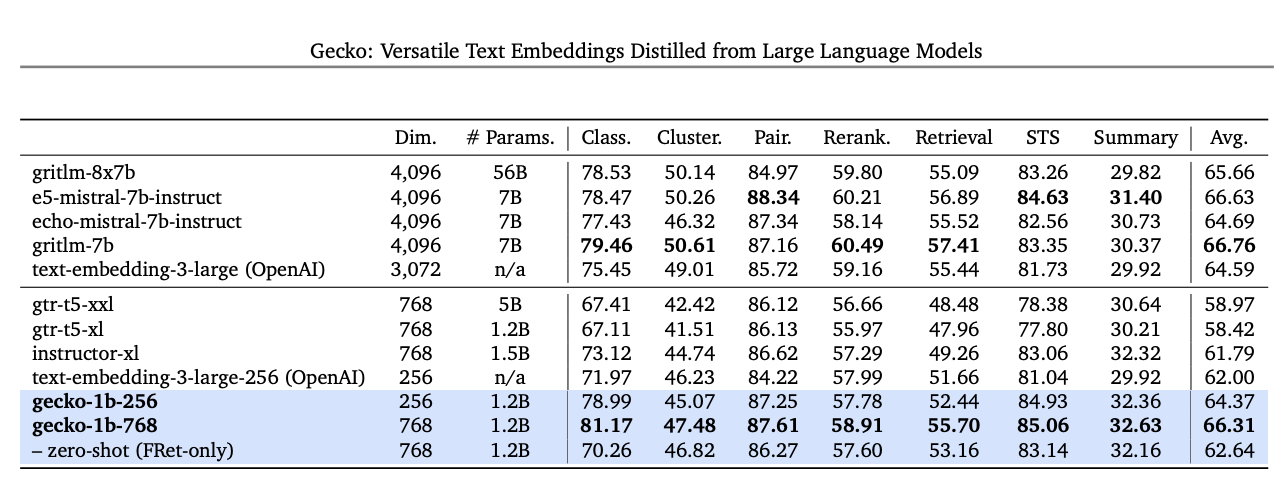

本日より、デベロッパーが Gemini API から次世代のテキスト埋め込みモデルにアクセスできるようになります。新しいモデルである text-embedding-004(Vertex AI では text-embedding-preview-0409)は、優れた検索機能を実現し、MTEB ベンチマークにおいて、同程度のディメンションの既存モデルを上回ります。

ここで紹介したのは、今後数週間のうちに Gemini API と Google AI Studio に追加される多くの改善の始まりに過ぎません。私たちは、Google AI Studio と Gemini API が、Gemini を使った最も簡単な開発方法となるように、努力を続けています。さっそく Google AI Studio で Gemini 1.5 Pro を使ってみてください。新しい Gemini API クックブックでコード例とクイックスタートを確認したり、Discord のコミュニティ チャンネルに参加したりすることもできます。