At Google Cloud Summit London, we shared how Google Cloud is transforming development with AI and unlocking your ability to build the next generation of agentic applications. As part of this, we're excited to announce significant advancements in Firebase Studio, our cloud-based AI workspace where you can create full-stack AI applications, whether you want to use multimodal prompts to generate code or write code directly. These updates–versatile Agent modes, foundational support for the Model Context Protocol (MCP), and Gemini CLI integration–are designed to redefine AI-assisted development and integrate powerful AI capabilities directly into your workflow.

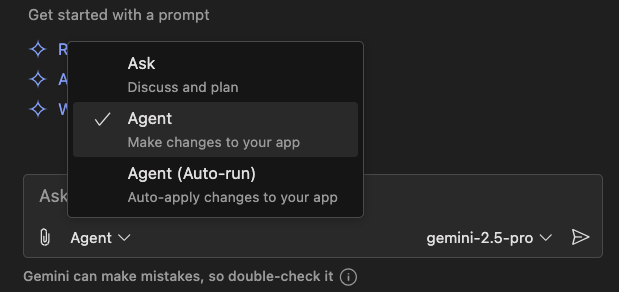

Three distinct modes are available now in Firebase Studio for interacting with Gemini, including a new autonomous Agent mode–whether you want to have a conversation, delegate tasks with step-by-step control or let Gemini work independently on your behalf. You can seamlessly toggle between modes to accelerate development tasks thanks to the deep code understanding and powerful reasoning capabilities of Gemini 2.5.

This mode can be used for discussion and planning with Gemini, and is ideal for brainstorming, planning code, and discussing complex problems collaboratively. The ”Ask” mode is purely conversational – no changes will be made to your files.

In this mode, Gemini can propose changes to your app, but you are always in the loop. You must approve any proposed changes in “Agent“ mode before any files are modified. This gives you complete oversight and allows you to easily code review changes before they are integrated into your project.

When you use ”Agent (Auto-run)” mode, Gemini can autonomously reason and generate entire apps or add features to existing apps. For example, it can code changes across multiple files, write tests, fix errors, and refactor components, all from a single prompt. For security, it will always require your permission before deleting files, running terminal commands or using external tools.

The Agent modes can leverage personalized guidance from a variety of project-level rule files to ensure Gemini adheres to your specific design patterns and preferences. It automatically detects and loads instructions from files like .idx/airules.md, GEMINI.md or .cursorrules at the project root providing a cohesive and highly customizable experience.

Alongside these new Agent modes, we're previewing foundational support for the Model Context Protocol (MCP) in Firebase Studio. Now you can add MCP servers to your workspace, extending and personalizing your workflows with Gemini in Firebase. For example, you can use the Firebase MCP server to explore your data in Cloud Firestore using natural language while you are building or debugging your application, or use Context7 to get library specific context for Gemini (i.e. try building app with MediaPipe’s on-device ML). We want to gather your feedback as we further integrate the functionality.

We recently launched Gemini CLI, offering you a powerful, free-to-use tool for a wide range of tasks beyond just code, including content generation and research. It is available with generous usage tiers, advanced AI features, integration with Google Search for real-time context, and an open-source architecture for customization and contributions. And we’re excited to share that now Gemini CLI is directly integrated in Firebase Studio.

If you spend a significant amount of time in the terminal on tasks like code generation, debugging, executing commands, or managing project files, Gemini CLI provides a seamless, AI-powered experience without the need to switch contexts to a separate chat window.

These new updates build on that momentum, extending powerful AI features deeper into Firebase Studio.

We’re already seeing so many of you leverage Firebase Studio's AI capabilities to streamline your workflows and speed up your time to release - from creating a procurement platform for the hydrogen economy or empowering people with a personalized fashion stylist to helping Pokémon enthusiasts manage card collections with AI-powered card scanning and identification and bringing architecture to life with striking visualization and human-centered analysis.

We’re committed to continuing to ship new features and updates to help you ship professional-quality apps, quickly and easily. Check out these new capabilities in Firebase Studio and share what you build on X and LinkedIn with #FirebaseStudio!