LiteRT(Lite Runtime의 약자)는 TensorFlow Lite(TFLite)의 새로운 이름입니다. 이름은 새롭지만 여전히 온디바이스 AI를 위한 신뢰할 수 있는 고성능 런타임이며 이제 비전이 확장되었습니다.

2017년 첫선을 보인 이후로, 개발자들은 TFLite를 사용해 2.7B 기기에서 실행되는 10만 개 이상의 앱에 ML 기반 경험을 제공할 수 있었습니다. 최근 TFLite는 TensorFlow라는 근원을 넘어 PyTorch, JAX, Keras에서 작성된 모델을 동일한 수준의 최고 성능으로 지원할 정도로 성장했습니다. LiteRT라는 이름은 미래를 위한 멀티 프레임워크 비전을 담고 있습니다. 바로, 개발자가 널리 사용되는 모든 프레임워크에서 시작해서 탁월한 성능으로 온디바이스에서 모델을 실행할 수 있도록 하는 것입니다.

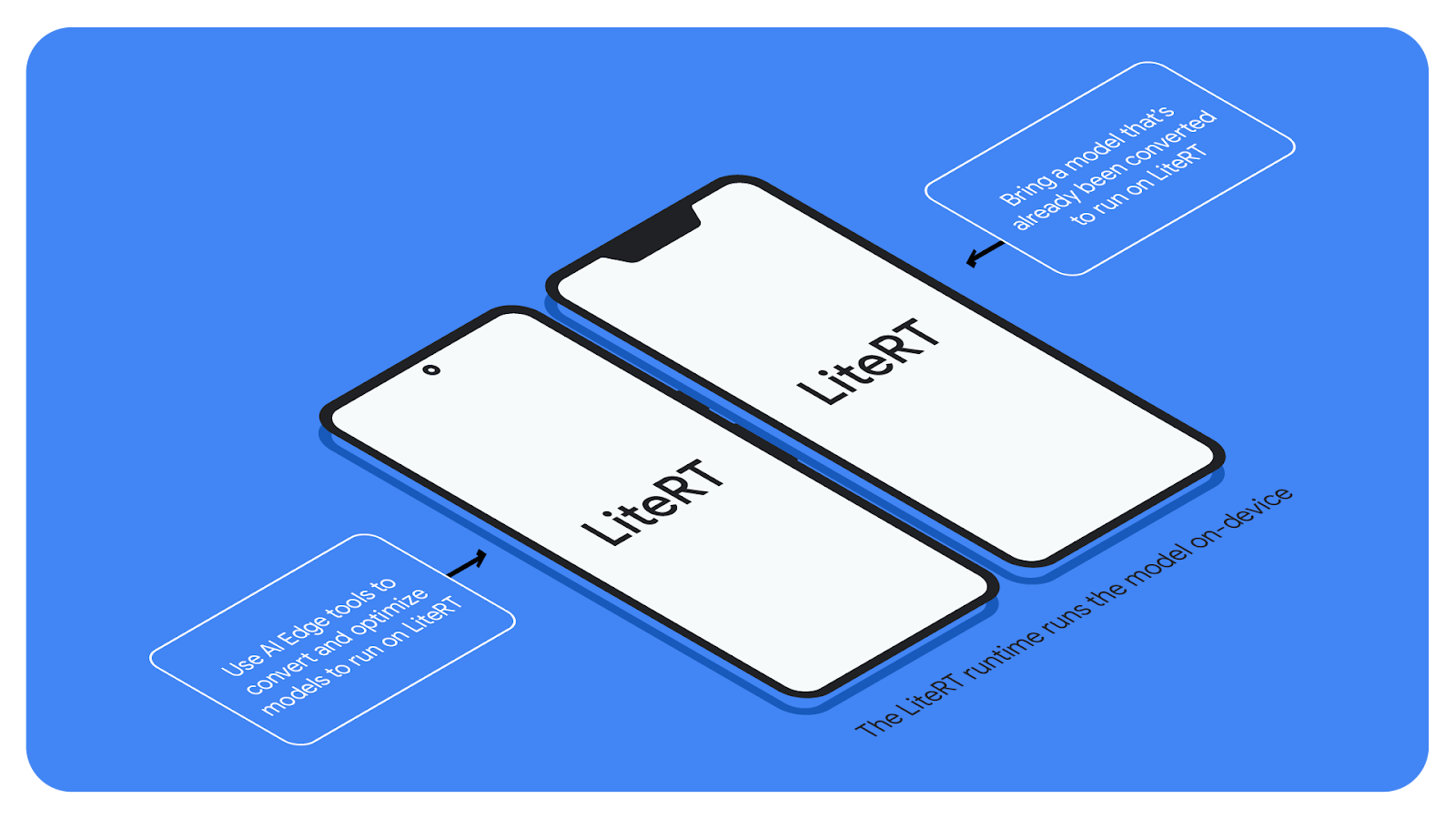

Google AI Edge 도구 모음에 속한 LiteRT는 Android, iOS 및 임베디드 기기에 ML 및 AI 모델을 원활하게 배포할 수 있게 해주는 런타임입니다. AI Edge의 강력한 모델 변환 및 최적화 도구를 사용하면 온디바이스 개발을 위한 오픈소스 및 사용자 설정 모델을 모두 준비할 수 있습니다.

이 변경 사항은 점진적으로 적용됩니다. 오늘부터 개발자 문서에 반영되는 LiteRT라는 이름이 ai.google.dev/edge/litert와 AI Edge 웹사이트의 다른 참조 문서에도 차차 적용될 예정입니다. 이제 tensorflow.org/lite의 문서가 ai.google.dev/edge/litert의 해당 페이지로 리디렉션됩니다.

주요 TensorFlow 브랜드는 영향을 받지 않으며, 이미 TensorFlow Lite를 사용 중인 앱도 영향을 받지 않습니다.

이번 변경 사항이 미치는 영향을 최소화하고 개발자가 변경해야 할 코드를 가능한 한 적게 만드는 것이 저희의 목표입니다.

현재 패키지를 통해 TensorFlow Lite를 사용하는 경우 Maven, PyPi, Cocoapods의 새로운 LiteRT를 사용하려면 종속성을 업데이트해야 합니다.

현재 Google Play 서비스를 통해 TensorFlow Lite를 사용하는 경우 현재로서는 아무것도 변경할 필요가 없습니다.

현재 소스에서 TensorFlow Lite를 빌드하는 경우 올해 하반기에 코드가 새로운 LiteRT 저장소로 완전히 이동될 때까지 TensorFlow 저장소에서 계속 빌드하세요.

1. 새로운 이름 LiteRT 이외에 변경되는 사항은 무엇인가요?

현재로서 유일한 변경 사항은 LiteRT이라는 새로운 이름뿐입니다. 프로덕션 앱은 영향을 받지 않습니다. 새로운 이름과 새로운 비전과 함께, 앞으로 LiteRT에 적용될 더 많은 업데이트 사항을 확인하고 플랫폼 전반에 걸친 GPU 및 NPU 가속으로 기존 ML 모델, LLM, 확산 모델의 배포 방법을 개선하세요.

2. TensorFlow Lite 지원 라이브러리(TensorFlow Lite Tasks 포함)는 어떻게 되나요?

현재 TensorFlow Lite 지원 라이브러리와 TensorFlow Lite Tasks는 /tensorflow 저장소에 그대로 남아 있습니다. 향후 개발 작업에는 MediaPipe Tasks를 사용하는 것이 좋습니다.

3. TensorFlow Lite Model Maker는 어떻게 되나요?

https://pypi.org/project/tflite-model-maker/를 통해 TFLite Model Maker에 계속 액세스할 수 있습니다.

4. 코드를 제공하려면 어떻게 해야 하나요?

지금은 기존 TensorFlow Lite 저장소에 코드를 제공해 주세요. LiteRT 저장소에 코드를 제공할 준비가 되면 별도로 공지해 드리겠습니다.

5. .tflite 파일 확장자와 파일 형식은 어떻게 되나요?

.tflite 파일 확장자 또는 형식은 변경되지 않습니다. 변환 도구는 .tflite 플랫버퍼 파일을 계속 출력하며 .tflite 파일은 LiteRT에서 읽을 수 있습니다.

6. 모델을 .tflite 형식으로 변환하려면 어떻게 해야 하나요?

Tensorflow, Keras, Jax의 경우 동일한 흐름을 계속 사용할 수 있습니다. PyTorch 지원의 경우 ai-edge-torch를 확인해 보세요.

7. 클래스와 메서드에 변경 사항이 있나요?

없습니다. 패키지 이름을 제외하고 지금은 작성한 코드를 변경하지 않아도 됩니다.

8. TensorFlow.js에 변경될 사항이 있나요?

아니요. TensorFlow.js는 Tensorflow 코드베이스의 일부로 계속 독립적으로 작동합니다.

9. 내 프로덕션 앱은 TensorFlow Lite를 사용하는데, 혹시 영향을 받게 되나요?

TensorFlow Lite를 이미 배포한 앱은 영향을 받지 않습니다. 여기에는 Google Play 서비스를 통해 TensorFlow Lite에 액세스하는 앱이 포함됩니다. (TFLite는 빌드 시간에 앱으로 컴파일되므로 일단 배포되면 앱에 종속성이 없습니다.)

10. 'LiteRT'를 사용해야 하는 이유

'LiteRT'(Lite Runtime의 약어)는 선구적인 '라이트' 온디바이스 런타임인 TensorFlow Lite의 유산과 오늘날의 번영을 지원하려는 Google의 노력을 반영합니다. 다중 프레임워크 생태계.

11. TensorFlow Lite는 여전히 활발하게 개발 중인가요?

네. 하지만 LiteRT라는 이름으로 개발 중입니다. 런타임(지금은 LiteRT라고 함)과 변환 및 최적화 도구를 통해 계속 활발하게 개발될 것입니다. 최신 버전의 런타임을 사용하려면 LiteRT를 사용하세요.

12. LiteRT의 실제 사용 사례는 어디에서 볼 수 있을까요?

공식 LiteRT 샘플 저장소에서 Python, Android, iOS에 대한 예를 확인할 수 있습니다.

온디바이스 ML의 미래가 무척 기대됩니다. 저희는 LiteRT를 다양한 모델에서 가장 사용하기 쉽고 성능이 가장 뛰어난 런타임으로 만들겠다는 비전을 위해 최선을 다하고 있습니다.