Gemini Embedding 텍스트 모델은 정식 버전 출시 이후 고급 AI 애플리케이션을 제작하는 데 곧바로 활용되었습니다. 많은 개발자가 기존의 분류, 시맨틱 검색, 검색 증강 생성(RAG)과 같은 사용 사례를 넘어 '컨텍스트 엔지니어링'이라고 불리는 기술을 통해 AI 에이전트에 완전한 운영 컨텍스트를 제공하고 있습니다. 여기서 임베딩은 문서, 대화 기록, 도구 정의와 같이 중요한 정보를 효율적으로 식별하여 모델의 작업 기억에 직접 통합하는 중요한 역할을 담당합니다.

다음 예시들에서는 다양한 업계의 조직에서 Gemini Embedding 모델을 정교한 시스템에 어떻게 활용하고 있는지 확인할 수 있습니다.

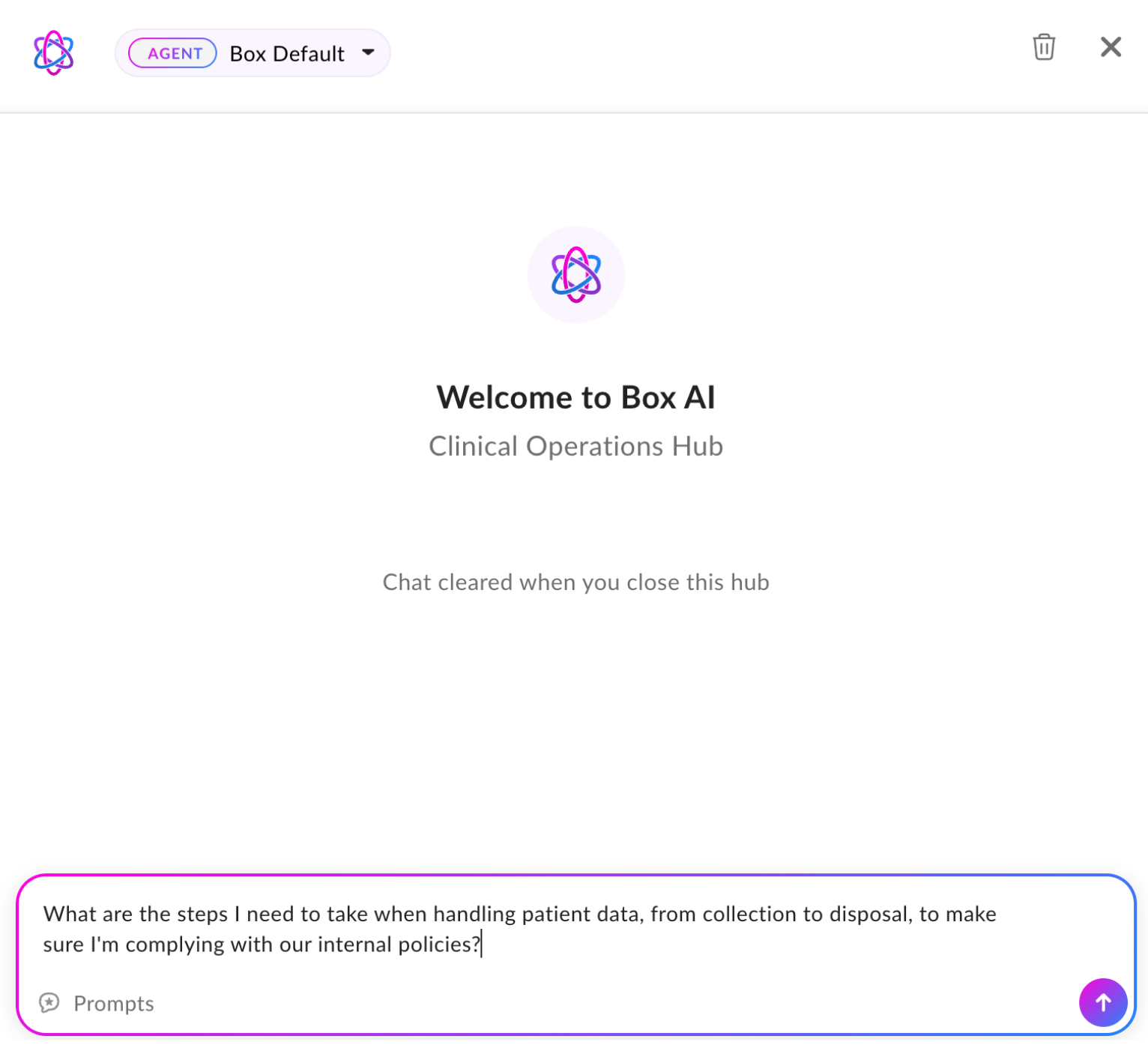

지능형 콘텐츠 관리 플랫폼 Box는 Gemini Embedding을 통합하여 질문에 답하고 복잡한 문서에서 인사이트를 도출하는 등의 핵심적인 기능을 지원합니다. 평가 결과, gemini-embedding-001은 81%가 넘는 정답률을 기록하여 타 임베딩 모델 대비 3.6% 높은 재현율을 달성했습니다. 이처럼 향상된 성능과 더불어, 글로벌 사용자에게 유용한 다국어 지원 기능이 내장된 덕분에 Box AI는 다양한 언어와 지역에 걸친 콘텐츠에서 인사이트를 확보할 수 있습니다.

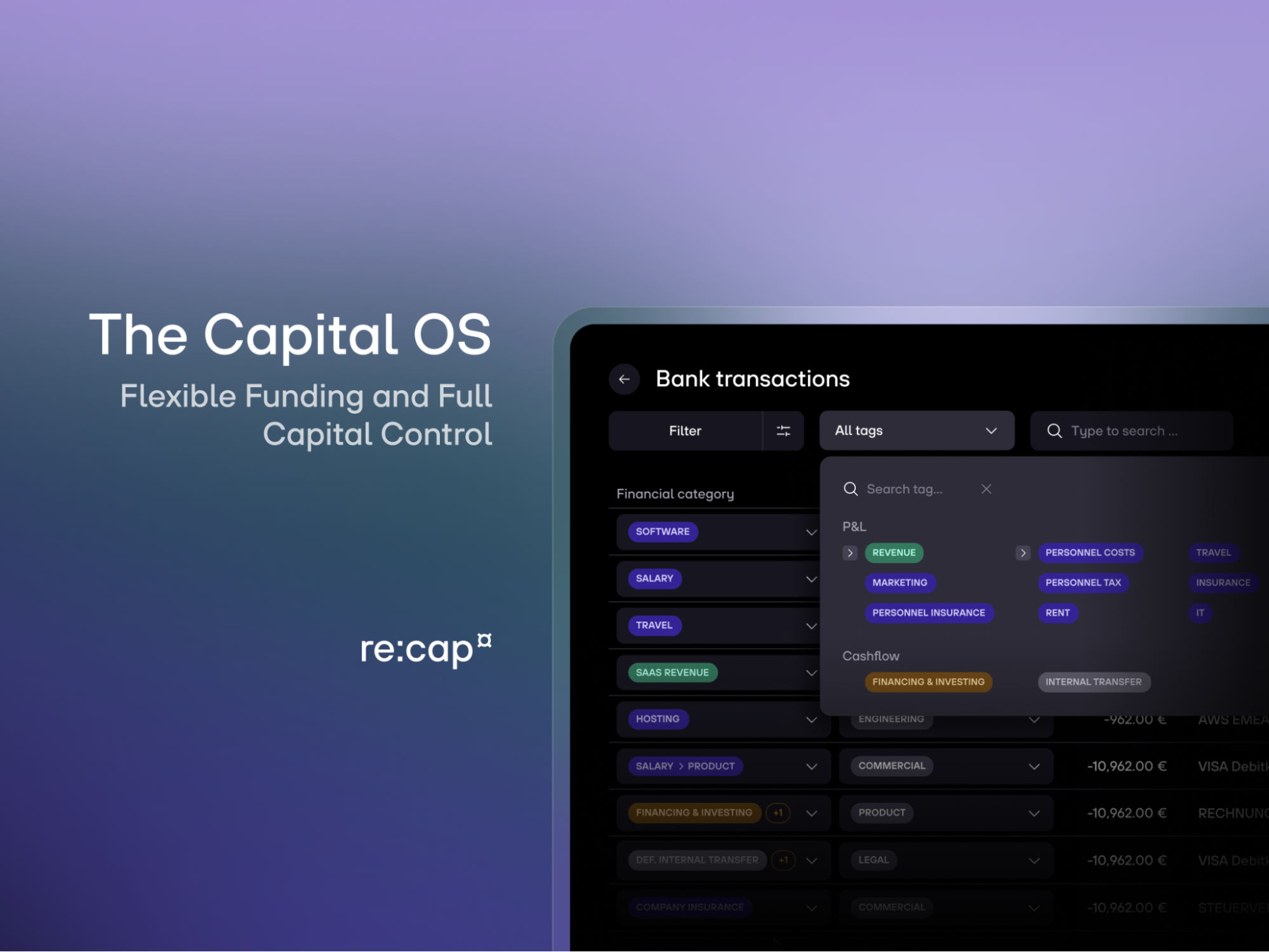

재무 기술 회사 re:cap에서는 임베딩을 사용해 대량의 B2B 은행 거래를 분류합니다. 21,500개의 거래 기록으로 이루어진 데이터 세트로 이전 Google 모델(text-embedding-004 및 text-embedding-005)과 비교하여 gemini-embedding-001의 성능을 측정한 결과, F1 점수가 이전 모델 대비 각각 1.9% 및 1.45% 상승했습니다. 모델의 정밀도와 재현율을 균형 있게 측정하는 F1 점수는 분류 작업에 중요한 지표입니다. 이러한 지표를 통해 Gemini Embedding과 같은 유능한 모델이 성능을 직접적으로 향상시켜 고객에게 한층 정확한 유동성 인사이트를 제공하는 데 효과적이라는 것을 확인할 수 있습니다.

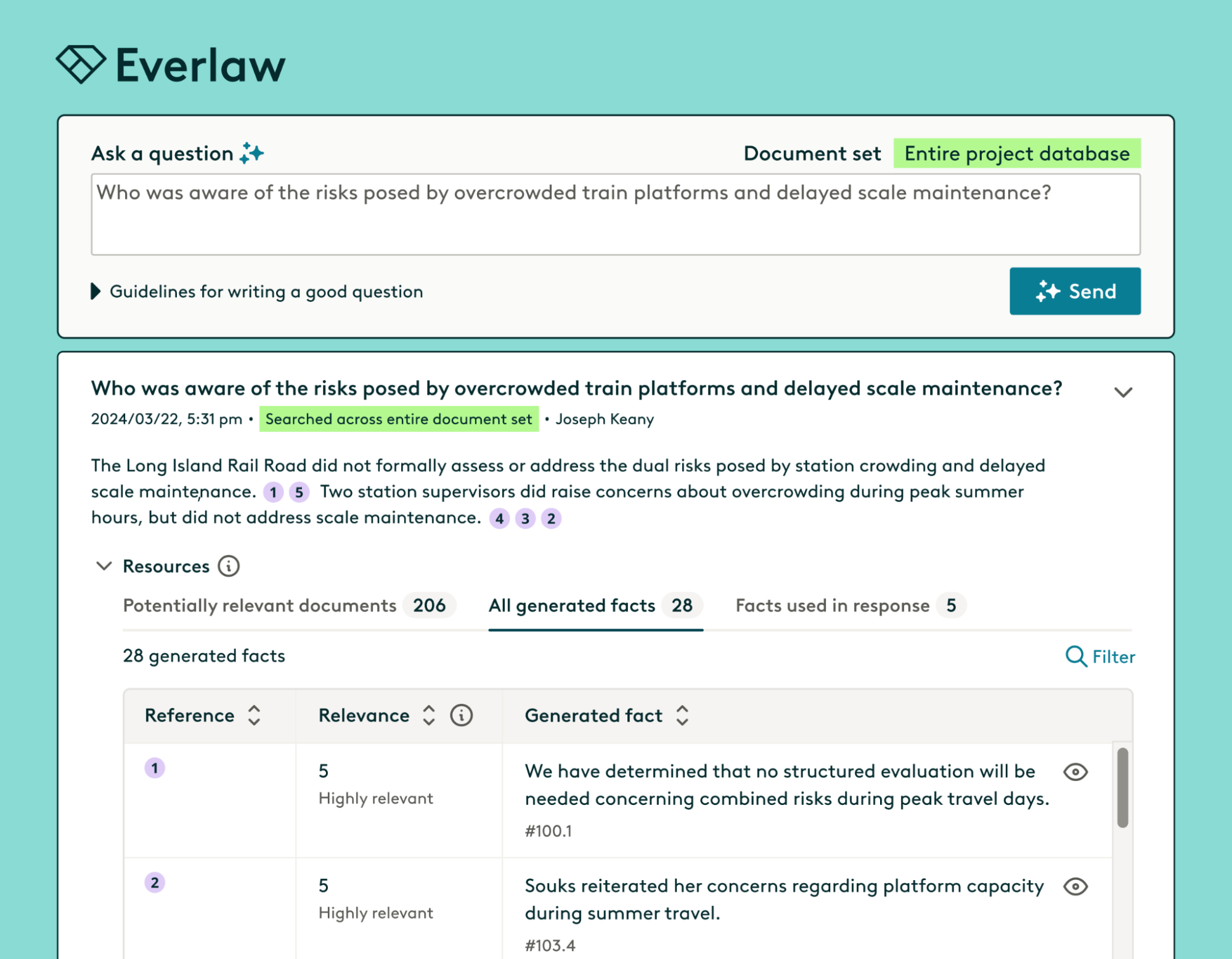

법조인이 대량의 증거 자료를 분석할 수 있도록 검증 가능한 RAG를 제공하는 플랫폼 Everlaw는 수백만 개의 전문적인 텍스트에 걸쳐 정확하게 시맨틱 매칭을 수행해야 합니다. 이에 Everlaw가 실시한 내부 비교에서 gemini-embedding-001이 법조계에 특화된 복잡한 법률 용어로 가득한 140만 건의 문서로부터 관련성 있는 답변을 도출하는 작업에서 87%의 정확성을 기록하여 Voyage(84%)와 OpenAI (73%) 모델을 제치고 가장 뛰어난 성능을 발휘하는 것으로 나타났습니다. 그뿐 아니라 Everlaw는 Gemini Embedding의 Matryoshka 속성을 활용해 간결한 표현을 사용하여 더 적은 차원에 중요 정보를 나타낼 수 있었습니다. 이에 따라 성능의 손실은 최소화되고, 저장용량을 위한 비용은 감소하며, 검색 및 탐색 효율은 증가했습니다.

오픈소스 AI 코딩 어시스턴트 Roo Code는 자사 코드베이스 인덱싱과 시맨틱 검색에 Gemini Embedding 모델을 사용합니다. Roo Code를 사용하는 개발자에게는 단순히 구문을 이해하는 것뿐 아니라 사용자의 의도를 이해하는 검색 기능이 필요하며 실제 팀원처럼 여러 파일을 넘나들며 상호 작용할 수 있는 어시스턴트가 필요합니다. Roo Code는 논리적인 코드 분할을 위해 gemini-embedding-001과 Tree-sitter를 결합함으로써 쿼리가 부정확한 경우에도 관련성 높은 결과를 생성할 수 있습니다. 초기 테스트 이후, Gemini Embedding 덕분에 LLM 기반 코드 검색이 보다 유연하고 정확해졌으며, 개발자 워크플로와도 비교적 일치하는 등 성능이 크게 향상되었습니다.

Mindlid의 AI 건강 도우미는 gemini-embedding-001을 사용하여 대화 기록을 이해하고, 실시간으로 사용자에게 맞춰 맥락을 고려한 의미 있는 인사이트를 제공합니다. 이들은 일관되게 1초 미만의 지연 시간(중앙값: 420ms)을 달성한 것은 물론, OpenAI의 text-embedding-3-small보다 4% 높은 82%의 top-3 재현율을 보이는 등 뛰어난 성능을 기록했습니다. 이를 통해 Gemini Embedding이 가장 관련 있는 정보를 제공하여 AI 지원의 관련성과 속도를 높인다는 것을 알 수 있습니다.

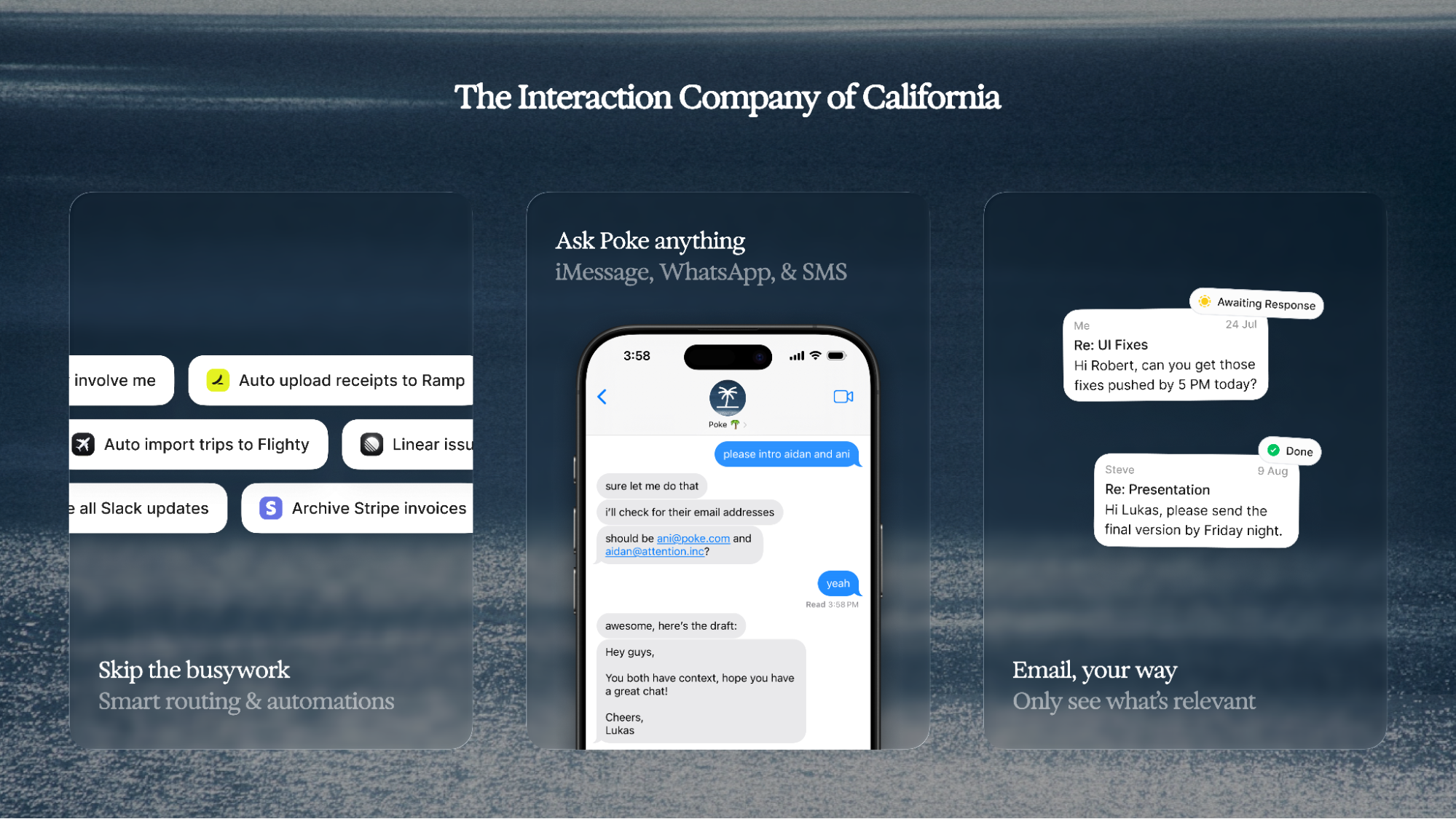

Interaction Co.에서 개발 중인 Poke는 작업을 자동화하고 Gmail에서 정보를 추출하는 등의 기능을 수행하는 AI 이메일 어시스턴트입니다. Poke는 두 가지 주요 기능, 즉 사용자의 '메모리'를 검색하고, 더욱 풍부한 컨텍스트를 위해 관련 있는 이메일을 식별하는 데 Gemini Embedding을 사용합니다. Gemini-embedding-001이 결합된 Poke의 언어 모델은 훨씬 빠르고 정확하게 데이터를 검색할 수 있습니다. Interaction Co.에 따르면 이 모델은 100개의 이메일을 겨우 21.45초 만에 임베딩하여 Voyage-2 대비 작업에 소요되는 시간이 평균 90.4%나 감소하였습니다.

AI 시스템이 점점 더 자동화되는 오늘날, AI에 제공하는 컨텍스트의 품질은 시스템의 효율성을 결정하는 중요한 요소입니다. 그만큼 gemini-embedding-001과 같은 고성능 임베딩 모델은 추론하고, 정보를 검색하고, 사용자를 대신하여 작업을 수행하는 차세대 에이전트를 개발하는 데 핵심적인 역할을 합니다.

임베딩 기술의 활용을 시작하려면 Gemini API 문서를 방문해 보세요.

성능 측정 항목은 각 개발자가 제공한 것입니다. 이러한 항목은 Google에서 독립적으로 검증되지 않았습니다.