빠르게 진화하는 대형 언어 모델(LLM) 환경에서는 주로 디코더 전용 아키텍처가 주목받아 왔습니다. 이러한 모델은 광범위한 생성 작업 전반에서 인상적인 성능을 보여주었지만, T5(The Text-to-Text Transfer Transformer)와 같은 기본 인코더-디코더 아키텍처가 여전히 많은 실제 응용 사례에서 널리 사용되고 있습니다. 인코더-디코더 모델은 높은 추론 효율성, 설계 유연성, 입력 데이터를 이해하기 위한 더욱 풍부한 인코더 표현 덕분에 요약, 번역, QA 등에서 탁월한 성능을 자랑합니다. 그럼에도 불구하고 강력한 인코더-디코더 아키텍처는 상대적으로 주목받지 못했습니다.

오늘은 이 아키텍처를 다시 살펴보고, 미리 학습된 디코더 전용 모델을 '조정'이라는 기법을 통해 인코더-디코더 아키텍처로 변환함으로써 개발된 새로운 인코더-디코더 LLM 컬렉션인 T5Gemma를 소개합니다. T5Gemma는 조정된 Gemma 2 2B 및 9B 모델뿐만 아니라 새로 학습된 T5 크기 모델 세트(Small, Base, Large, XL)를 포함해 Gemma 2 프레임워크를 기반으로 합니다. 사전 학습되고 지시문에 맞춰 튜닝된 T5Gemma 모델을 커뮤니티에 선보임으로써 연구 개발을 위한 새로운 기회를 창출할 수 있게 되어 기쁩니다.

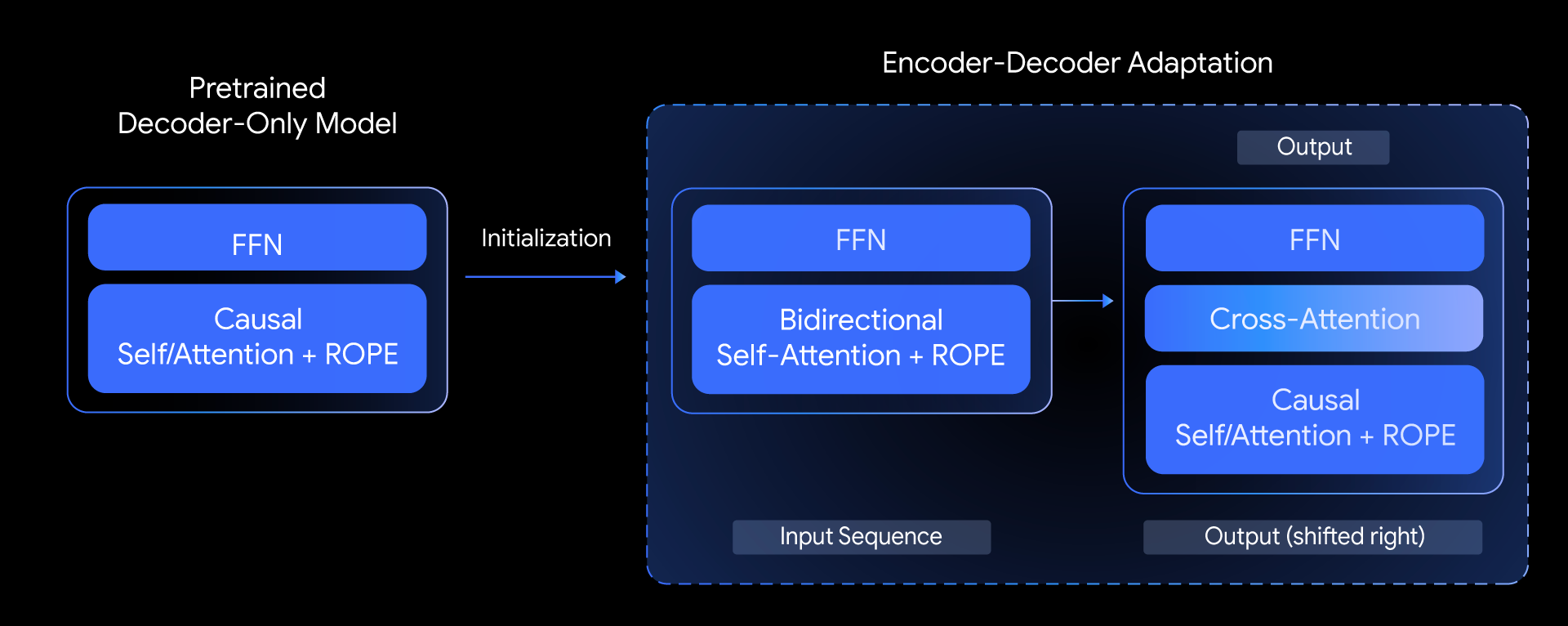

T5Gemma에서 저희는 다음 질문을 던집니다. 사전 학습된 디코더 전용 모델을 기반으로 최상위 계층의 인코더-디코더 모델을 개발할 수 있을까?. 그리고 모델 조정이라는 기법을 탐구함으로써 이 질문에 대한 답을 찾았습니다. 핵심 아이디어는 이미 사전 학습된 디코더 전용 모델의 가중치를 사용하여 인코더-디코더 모델의 매개 변수를 초기화한 다음, UL2 또는 PrefixLM 기반 사전 학습을 통해 추가로 조정하는 것입니다.

이 조정 방법은 매우 유연하여 모델 크기를 창의적으로 조합할 수 있습니다. 예를 들어, 큰 인코더를 작은 디코더(예: 9B 인코더를 2B 디코더와 페어링)와 페어링하여 '불균형' 모델을 생성할 수 있습니다. 이를 통해서, 생성된 출력의 복잡성보다는 입력 데이터에 대한 심층적 이해가 더 중요한 요약 같은 특정 작업에 있어서 품질과 효율성 사이의 절충점을 미세 조정할 수 있습니다.

T5Gemma는 어떻게 작동할까요?

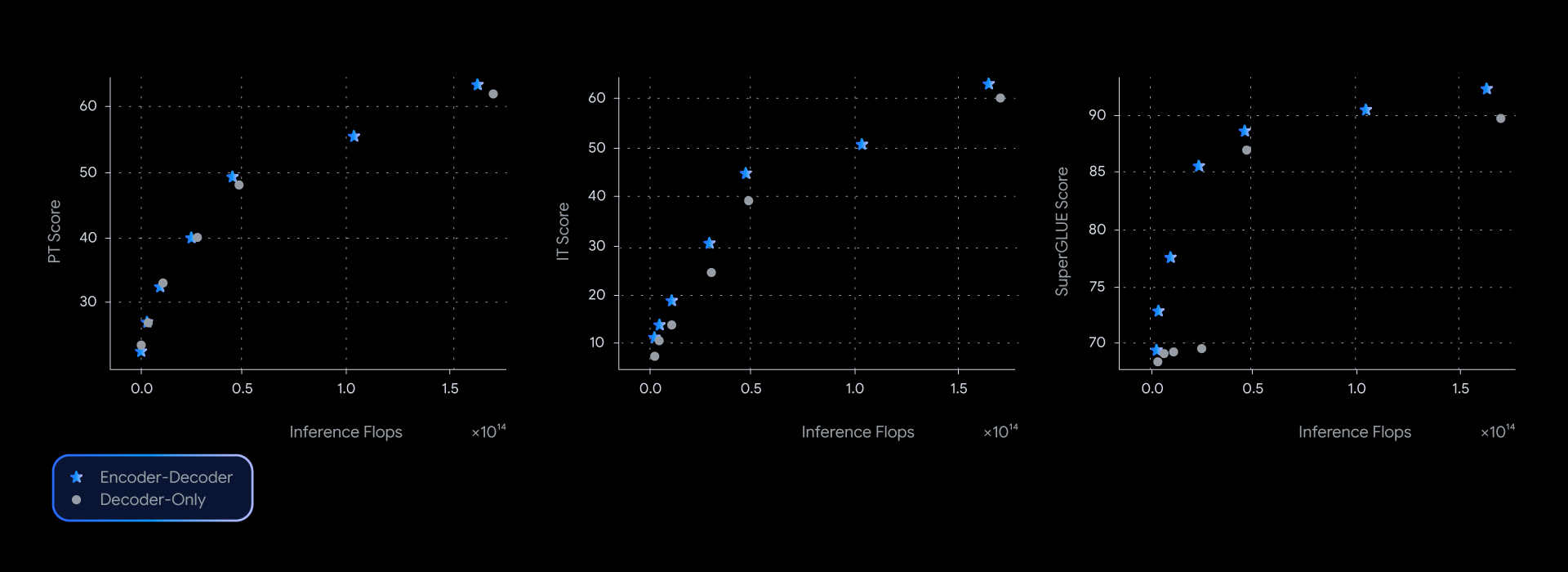

저희가 진행 중인 실험에서 T5Gemma 모델은 디코더 전용 Gemma 모델과 비슷하거나 더 우수한 성능을 보여주었습니다. 학습된 표현의 품질을 측정하는 SuperGLUE와 같은 여러 업계 기준치에서 품질-추론 효율성의 파레토 프런티어를 거의 장악했습니다.

이러한 성능 우위는 단순히 이론에 그치는 것이 아니라 실제 품질과 속도로도 이어집니다. GSM8K(수학 추론)의 실제 지연 시간을 측정할 때 T5Gemma는 명확한 우위를 보였습니다. 예를 들어, T5Gemma 9B-9B는 Gemma 2 9B보다 정확도는 더 높지만 지연 시간은 비슷합니다. 더욱 놀라운 점은 T5Gemma 9B-2B가 2B-2B 모델에 비해 크게 향상된 정확도를 제공하면서도 훨씬 작은 Gemma 2 2B 모델과 지연 시간은 거의 동일하다는 사실입니다. 궁극적으로, 이러한 실험을 통해 인코더-디코더 조정이 품질과 추론 속도의 균형을 맞추는 유연하고 강력한 방법을 제공한다는 사실을 알 수 있습니다.

인코더-디코더 LLM이 디코더 전용 모델과 유사한 성능을 가질 수 있을까요?

가능합니다. T5Gemma는 지시문 조정 전과 후에서 모두 기대되는 성능을 보여줍니다.

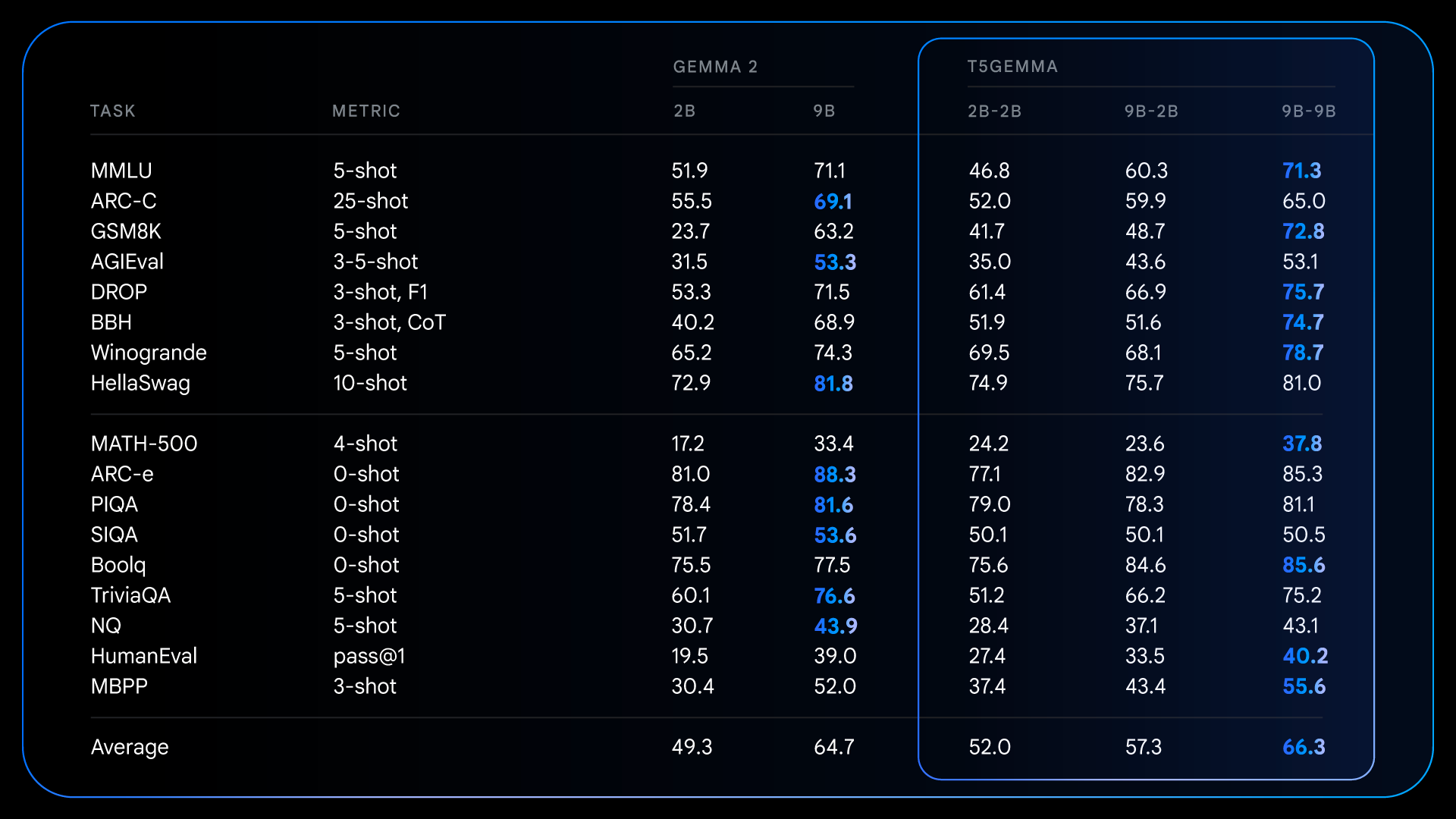

사전 학습 후, T5Gemma는 추론이 필요한 복잡한 작업에서 훌륭한 성과를 달성합니다. 예를 들어, T5Gemma 9B-9B의 점수는 기존 Gemma 2 9B 모델보다 GSM8K(수학 추론)에서는 9점, DROP(독해력)에서는 4점 더 높습니다. 이 패턴은 인코더-디코더 아키텍처가 조정을 통해 초기화될 경우 더 우수하고 성능 좋은 기본 모델을 만들 수 있는 잠재력을 지니고 있음을 보여줍니다.

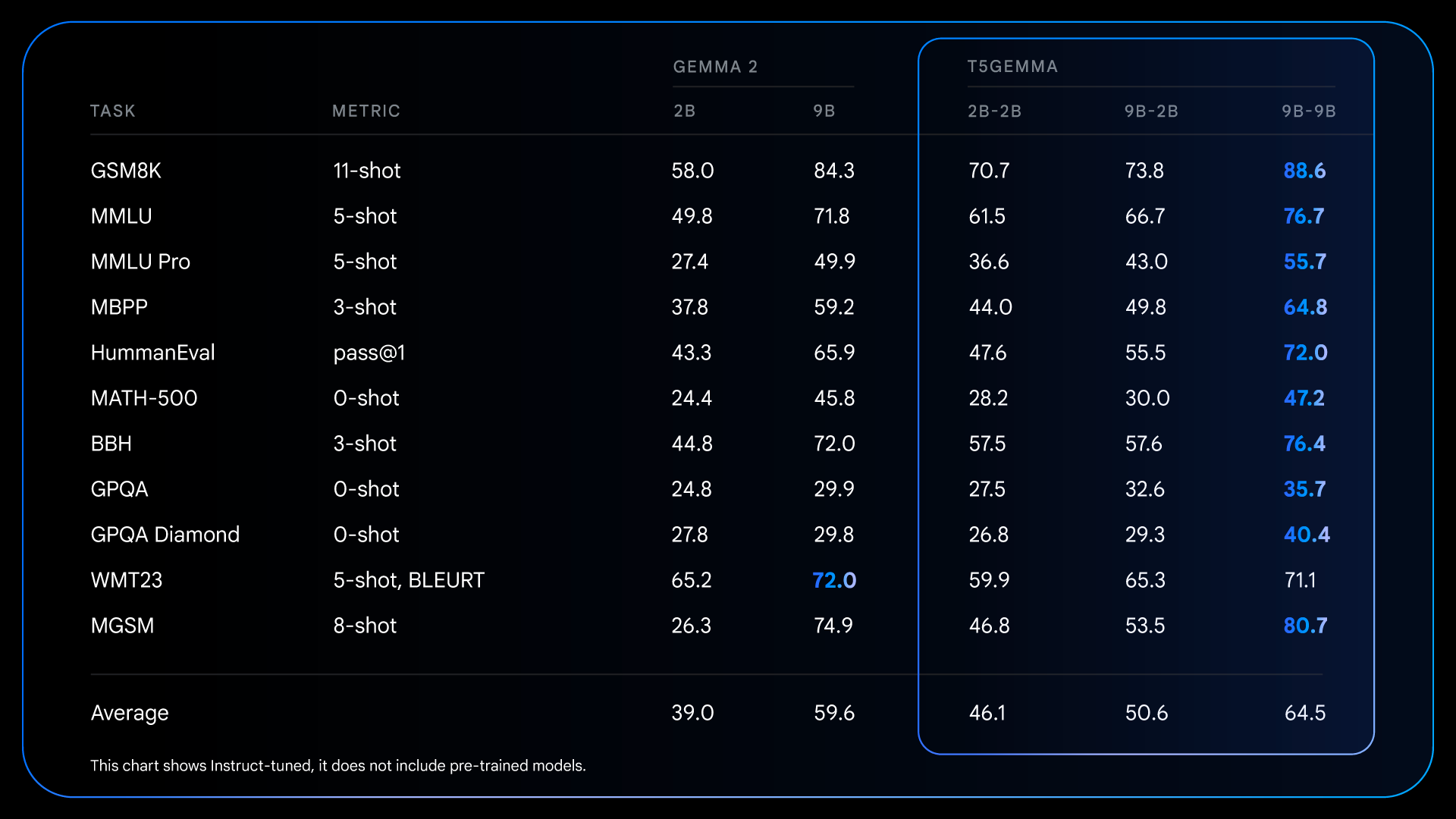

사전 학습을 통한 이러한 기본적인 개선 덕분에 지시문 튜닝 후 더욱 뛰어난 성과를 얻을 수 있는 환경이 마련됩니다. 예를 들어, Gemma 2 IT와 T5Gemma IT를 비교하면 전반적으로 성능 격차가 크게 벌어집니다. T5Gemma 2B-2B IT는 MMLU 점수가 Gemma 2 2B에 비해 거의 12점 높으며 GSM8K 점수는 58.0%에서 70.7%로 향상되었습니다. 조정된 아키텍처는 더 나은 출발점을 제공할 수 있을 뿐만 아니라 지시문 튜닝에 더 효과적으로 반응하여 궁극적으로는 훨씬 더 유능하고 유용한 최종 모델로 이어집니다.

Gemma 2와 같이 사전 학습된 디코더 전용 LLM에서 조정하여 강력한 범용 인코더-디코더 모델을 개발하는 이 새로운 방법을 발표하게 되어 매우 기쁩니다. 추가 연구를 가속화하고 커뮤니티가 이 작업을 바탕으로 더 발전할 수 있도록 T5Gemma 체크포인트 제품군을 출시하게 되었습니다.

여기에는 다음이 포함됩니다.

이러한 체크포인트가 모델 아키텍처, 효율성, 성능을 조사하는 데 유용한 리소스가 되기를 바랍니다.

개발자 여러분이 T5Gemma로 개발한 결과물을 손꼽아 기다립니다. 자세한 내용은 다음 링크를 확인해 보세요.