오늘 저희는 Gemini 2.0을 더 많은 개발자에게 제공하고 프로덕션 단계에서 사용할 수 있도록 하는 흥미로운 업데이트를 발표했습니다. 이제 Google AI Studio를 통해 Gemini API와 Vertex AI에서 다음 모델을 사용할 수 있습니다.

추론 후 답변하는 Flash 변이 버전으로 최근 출시된 Gemini 2.0 Flash Thinking Experimental과 함께, 이러한 새로운 모델 출시를 통해 광범위한 사용 사례와 애플리케이션에서 Gemini 2.0 기능을 사용할 수 있게 되었습니다.

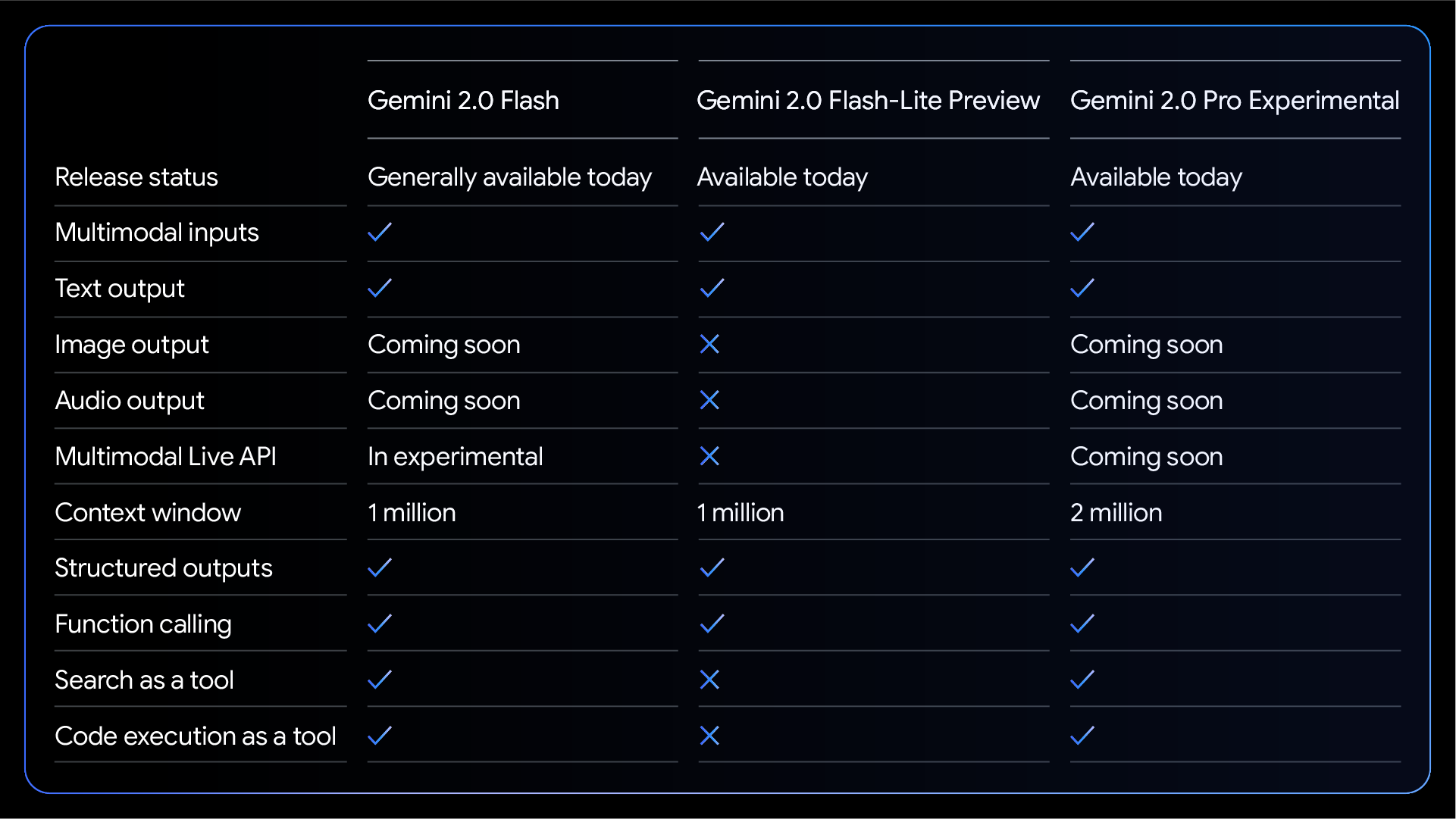

Gemini 2.0 Flash는 네이티브 도구 사용, 백만 개의 토큰 컨텍스트 윈도우, 멀티모달 입력을 포함한 포괄적인 기능을 제공합니다. 이 버전은 현재 텍스트 출력을 지원하는데, 향후 몇 달 내에 Multimodal Live API와 이미지 및 오디오 출력 기능을 정식 버전으로 출시될 계획입니다. Gemini 2.0 Flash-Lite는 대규모 텍스트 출력 사용 사례에 맞춰 비용이 최적화되어 있습니다.

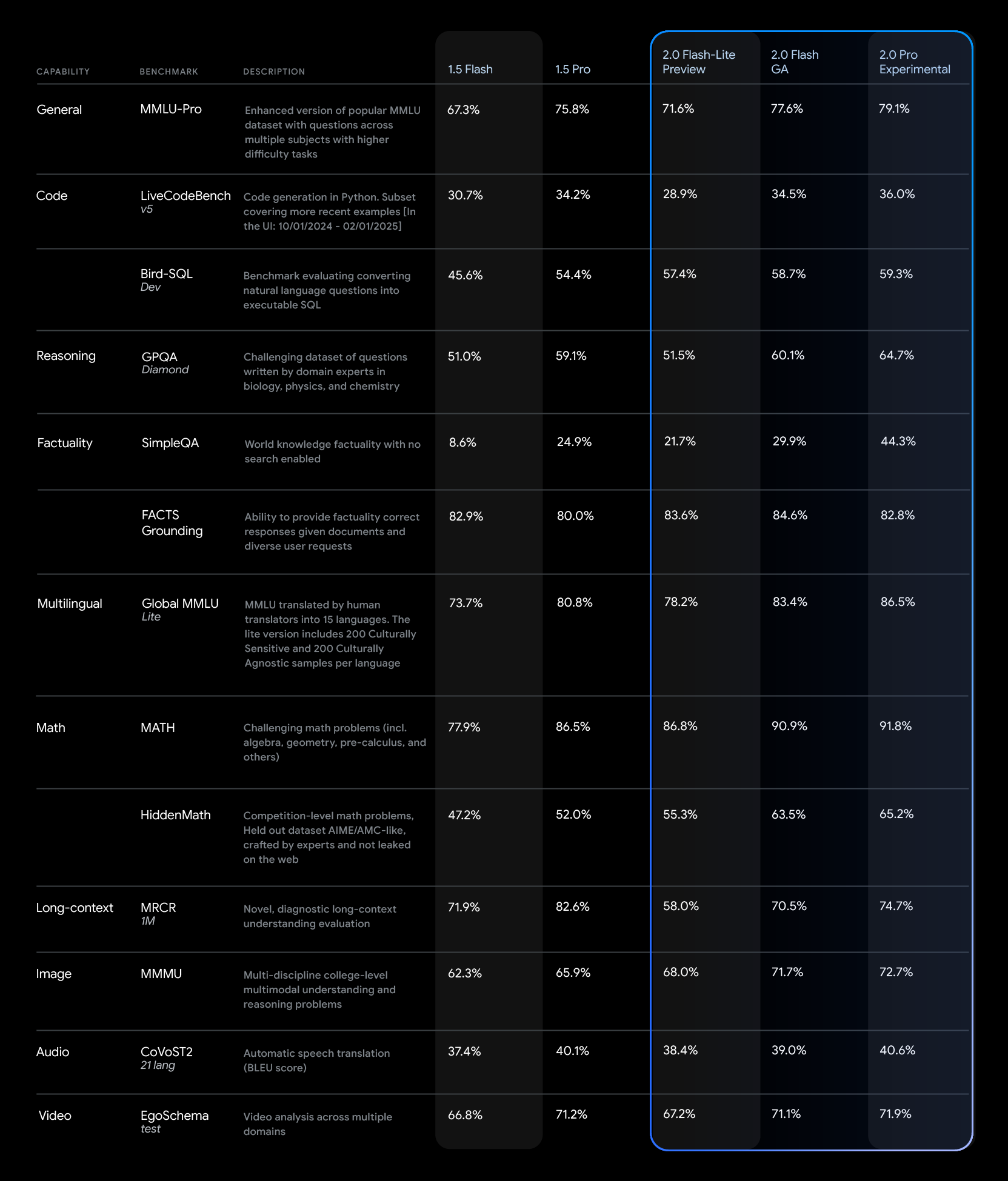

Gemini 2.0 모델은 다양한 업계 기준치에서 Gemini 1.5에 비해 상당히 향상된 성능을 보여줍니다.

이전 모델과 마찬가지로, Gemini 2.0 Flash는 간결한 스타일로 기본 설정되어 있어 사용하기 쉽고 비용도 절감할 수 있습니다. 또한 채팅 중심의 사용 사례에서 더 나은 결과를 생성할 수 있도록 보다 상세한 스타일을 사용하라는 요청을 받을 수도 있습니다.

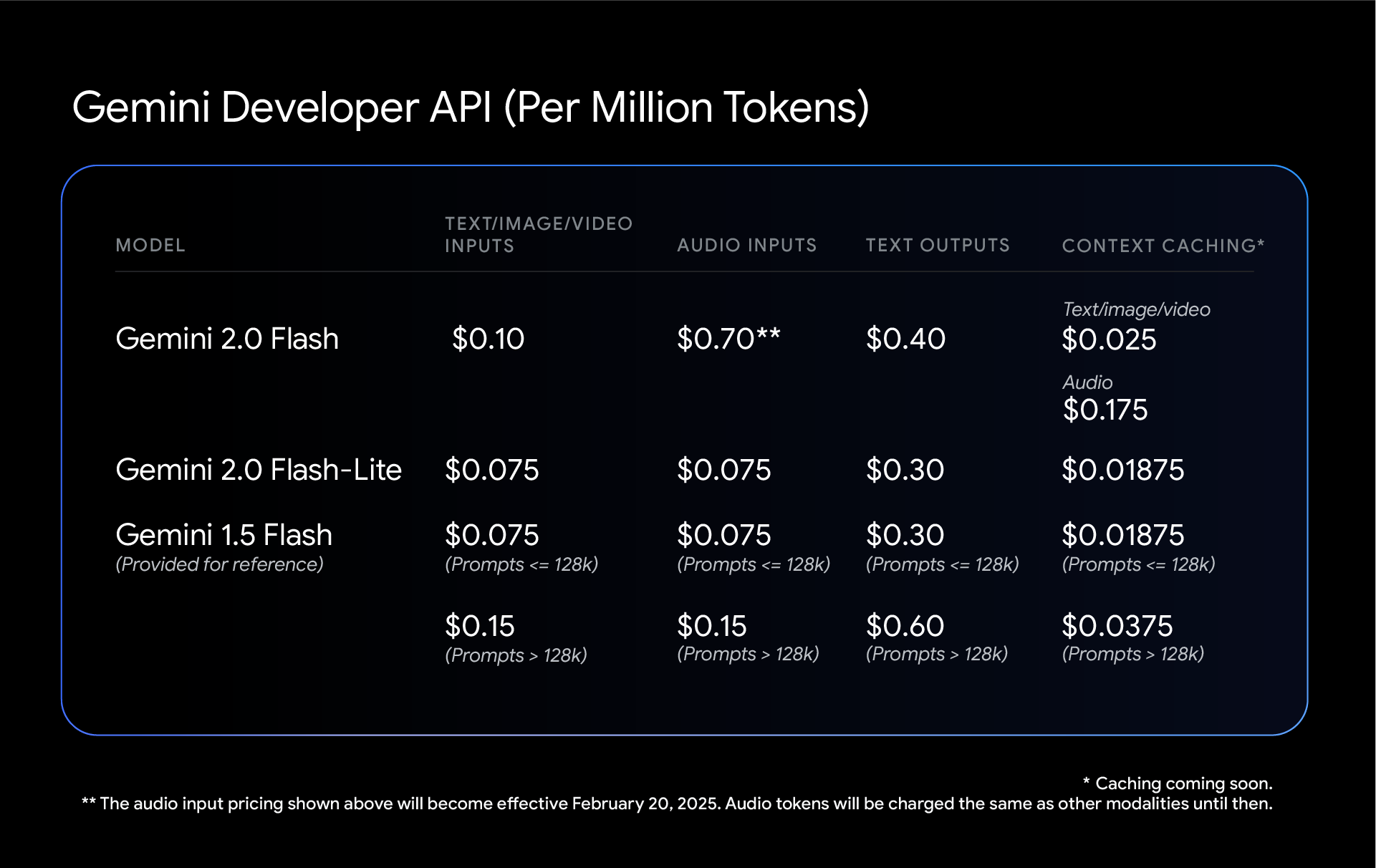

Gemini 2.0 Flash 및 2.0 Flash-Lite로 비용을 지속적으로 절감하고 있습니다. 둘 다 입력 유형 당 단일 가격이 적용되므로 Gemini 1.5 Flash의 짧은 컨텍스트 요청과 긴 컨텍스트 요청 사이에 구분이 없어졌습니다. 즉, 2.0 Flash와 Flash-Lite는 둘 다 성능이 향상되었음에도 혼합 컨텍스트 워크로드를 처리하는 Gemini 1.5 Flash보다 오히려 비용이 적게 들 수 있습니다.

각각의 링크를 따라가서 다양한 모달리티의 토큰 카운팅, Gemini Developer API 요금, Vertex AI 요금에 대해 자세히 알아보세요.

단 4줄의 코드로 최신 Gemini 모델을 사용한 개발 작업에 착수할 수 있으며, 이를 통해 업계 최고의 무료 티어와 속도 한도를 활용해 프로덕션 단계까지 확장할 수 있습니다. 개발자 여러분이 지금까지 일군 진전이 저희에게 큰 영감을 주었습니다. 여러분이 이런 최신 Gemini 모델을 또 어떻게 활용할지 정말 기대됩니다. 즐거운 개발하세요!