多くのユーザーは日常的に生成 AI とやり取りしていますが、その強力な機能を利用可能にしている基盤 API の重要な役割には気づいていません。API は、自動化されたエージェントと人間のユーザー両方が生成 AI モデルを利用できるようにし、生成 AI の力を引き出します。また、社内外で活用される複雑なビジネス プロセスは、エージェント型ワークフローで複数の API を接続することにより構築されます。

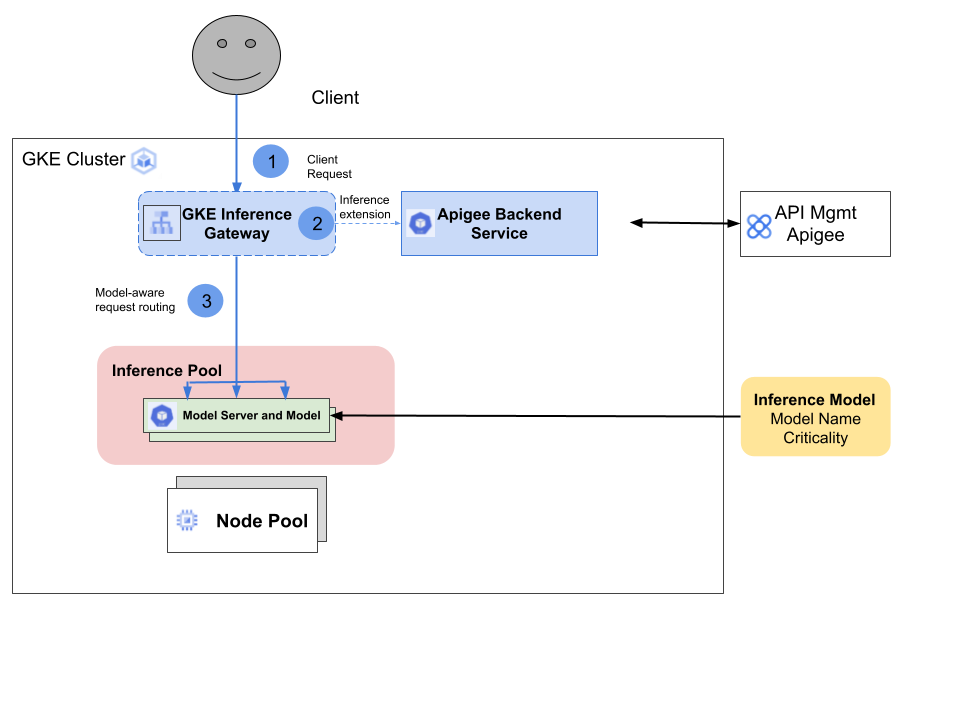

Google Kubernetes Engine(GKE)Inference Gateway は、GKE Gateway の拡張機能で、生成人工知能(AI)のワークロード サービングのために最適化されたルーティングとロード バランシングを提供します。また GKE Inference Gateway は、AI 推論ワークロードのデプロイ、管理、オブザーバビリティを簡素化します。提供している機能は次のとおりです。

重要度: GKE Inference Gateway では、AI モデルのサービングの重要度を指定し、レイテンシの影響を受けやすいリクエストを、レイテンシの影響を受けにくいバッチ推論ジョブよりも優先させることができます。GKE Inference Gateway を利用している企業のお客様の多くが、自社のエージェント / AI ワークロードのセキュリティ確保と最適化を望んでいます。エージェント API の商用化戦略の一環として、エージェント型 API を公開して収益化すると同時に、Apigee が提供する高品質な API ガバナンス機能にもアクセスしたいと考えています。

GKE Inference Gateway は、GCPTrafficExtension リソースを導入し、GKE Gateway がサービス拡張機能(または ext-proc)メカニズムを通じて、ポリシー決定ポイント(PDP)に「横方向」の呼び出しを行えるようにすることで、この課題を解決します。

Apigee Operator for Kubernetes は、このサービス拡張機能メカニズムを活用して、GKE Inference Gateway を経由する API トラフィックに Apigee ポリシーを適用します。このシームレスな統合により、GKE Inference Gateway のユーザーは、Apigee の API ガバナンスの利点を享受できます。

GKE Inference Gateway と Apigee Operator for Kubernetes は、以下の手順を通じて連携します。

Apigee は、Google Cloud、その他のパブリック クラウド、オンプレミスのインフラストラクチャにおいて、従来のトランザクション API と大規模言語モデル(LLM)に包括的な API 管理レイヤを提供します。このプラットフォームは、強力なポリシー エンジン、完全な API ライフサイクル管理、AI / ML を活用した高度な分析を備えています。Apigee は Gartner Magic Quadrant において API 管理のリーダーとして認められており、複雑な API ニーズを持つ大規模企業にサービスを提供しています。

この新しい GKE Inference Gateway との統合により、GKE ユーザーは、Apigee の全機能を活用し、API を通じて AI ワークロードの管理、ガバナンス、収益化を行えるようになります。これには、API プロデューサーが API を API プロダクトとしてパッケージ化し、セルフサービスのデベロッパー ポータルを通じて、デベロッパーに提供できる機能も含まれます。ユーザーは、API セキュリティや詳細な API 分析など、Apigee の付加価値サービスへのアクセスも可能になります。

この統合により、GKE ユーザーは以下を対象とした Apigee ポリシーにアクセスできるようになります。

この統合で使用される Apigee Operator for Kubernetes は、管理者テンプレート ルールもサポートしており、組織管理者が組織全体にポリシールールを適用できるようにします。たとえば、組織管理者は特定のポリシーをすべての API に適用することを必須としたり、組織の API で使用できないポリシーの一覧を指定したりできます。

今後、以下を対象とする Apigee AI ポリシーのサポートが予定されています。

GKE Inference Gateway を通じて、Apigee の最高水準の API 管理およびセキュリティ機能を活用することにより、企業は AI サービングと API ガバナンスのレイヤを統合することが可能になります。Apigee のフル機能を備えた API 管理プラットフォームを利用することで、コアミッションである、GKE 上で推論エンジンを実行し、パブリック クラウドで利用可能な最高水準の AI インフラストラクチャを活用するという作業に専念できます。