Em fevereiro, anunciamos o Gemma, nossa família de modelos abertos leves e de última geração, criados a partir da mesma pesquisa e tecnologia usadas para criar os modelos Gemini. A incrível resposta da comunidade, incluindo impressionantes variantes ajustadas, notebooks do Kaggle, integração com ferramentas e serviços, receitas para RAG usando bancos de dados como o MongoDB e muito mais, tem sido verdadeiramente inspiradora.

Hoje, temos o prazer de anunciar nossa primeira rodada de adições à família Gemma, que expande as possibilidades para os desenvolvedores de ML inovarem de forma responsável: o CodeGemma, para tarefas de sugestão e geração de código, além de acompanhamento de instruções, e o RecurrentGemma, uma arquitetura otimizada para eficiência para experimentação de pesquisas. Além disso, estamos compartilhando algumas atualizações do Gemma e de nossos termos, que visam melhorias com base no feedback inestimável que recebemos da comunidade e de nossos parceiros.

Com o aproveitamento da base de nossos modelos Gemma, o CodeGemma traz recursos de codificação poderosos, porém leves, para a comunidade. Os modelos CodeGemma estão disponíveis como uma variante 7B pré-treinada e especializada em tarefas de sugestão e geração de código, uma variante 7B ajustada por instrução para chats de código e acompanhamento de instruções e uma variante 2B pré-treinada para sugestões rápidas de código adaptada para computadores locais. Os modelos CodeGemma têm várias vantagens:

Saiba mais sobre o CodeGemma em nosso relatório ou experimente-o neste guia de início rápido.

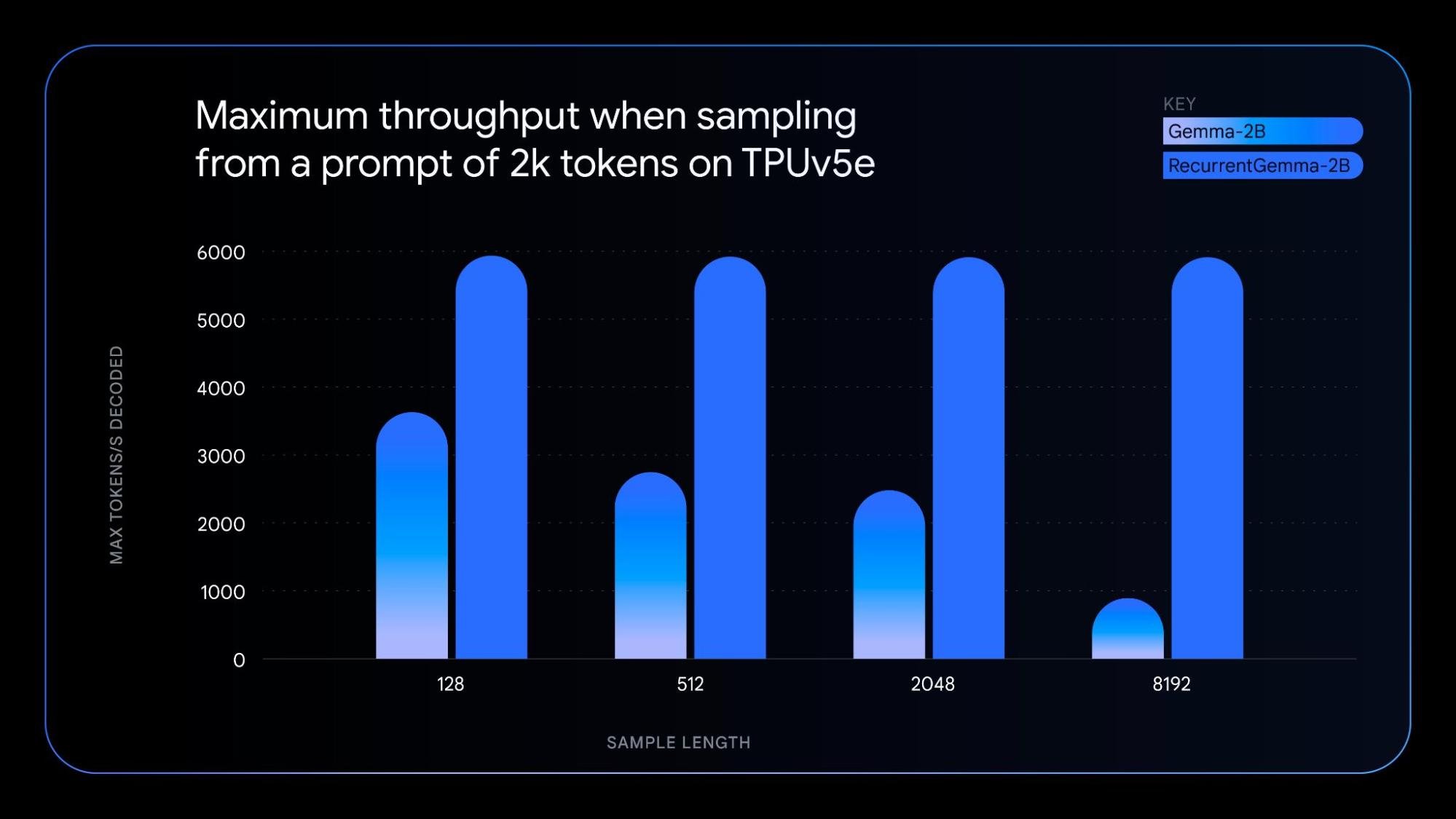

O RecurrentGemma é um modelo tecnicamente diferenciado que aproveita as redes neurais recorrentes e a atenção local para melhorar a eficiência da memória. Embora tenha um desempenho de pontuação de comparativo de mercado semelhante ao do modelo Gemma 2B, a arquitetura exclusiva do RecurrentGemma oferece várias vantagens:

Para entender a tecnologia subjacente, confira nosso artigo. Para uma exploração prática, experimente o notebook, que demonstra como ajustar o modelo.

Orientadas pelos mesmos princípios dos modelos Gemma originais, as novas variantes de modelo oferecem:

- CodeGemma e RecurrentGemma: criados com JAX e compatíveis com JAX, PyTorch, Hugging Face Transformers e Gemma.cpp. Habilite a experimentação local e a implantação econômica em vários tipos de hardware, incluindo laptops, computadores, GPUs NVIDIA e Google Cloud TPUs.

- CodeGemma: compatível também com Keras, NVIDIA NeMo, TensorRT-LLM, Optimum-NVIDIA e MediaPipe e disponível no Vertex AI.

- RecurrentGemma: o suporte a todos os produtos citados estará disponível nas próximas semanas.

Juntamente com as novas variantes de modelo, estamos lançando o Gemma 1.1, que inclui melhorias de desempenho. Além disso, ouvimos o feedback dos desenvolvedores, corrigimos os bugs e atualizamos nossos termos para oferecer mais flexibilidade.

Essas primeiras variantes do modelo Gemma estão disponíveis em vários locais ao redor do mundo, começando hoje com o Kaggle, o Hugging Face e o Vertex AI Model Garden. Veja como começar:

Convidamos você a experimentar os modelos CodeGemma e RecurrentGemma e a compartilhar seu feedback no Kaggle. Juntos, vamos moldar o futuro da criação e compreensão de conteúdo com base em IA.