En febrero, anunciamos Gemma, nuestra familia de modelos abiertos ligeros y de última generación desarrollados a partir de la misma investigación y tecnología utilizadas para crear los modelos Gemini. La increíble respuesta de la comunidad, entre la que se incluyen impresionantes variantes ajustadas, notebooks de Kaggle, integración en herramientas y servicios, recetas para RAG utilizando bases de datos como MongoDB y mucho más, fue realmente inspiradora.

Hoy, nos complace presentar nuestra primera ronda de soluciones que agregamos a la familia de Gemma y que nos permitirán ampliar las posibilidades para que los desarrolladores de AA innoven de manera responsable: CodeGemma para tareas de finalización y generación de código, así como seguimiento de instrucciones, y RecurrentGemma, una arquitectura de eficiencia optimizada para la experimentación de investigación. Además, compartimos algunas actualizaciones de Gemma y de los términos dirigidos a mejoras basadas en comentarios invaluables que recibimos de la comunidad y nuestros socios.

Al aprovechar la base de nuestros modelos de Gemma, CodeGemma ofrece a la comunidad capacidades de codificación potentes pero livianas. Los modelos CodeGemma están disponibles como una variante preentrenada 7B que se especializa en tareas de finalización y generación de código, una variante ajustada a instrucciones 7B para chat de código y seguimiento de instrucciones, y una variante preentrenada 2B para la finalización rápida de código que puede almacenarse en su computadora local. Los modelos CodeGemma tienen varias ventajas:

Para obtener más información sobre CodeGemma, consulta nuestro informe o pruébalo con esta guía de inicio rápido.

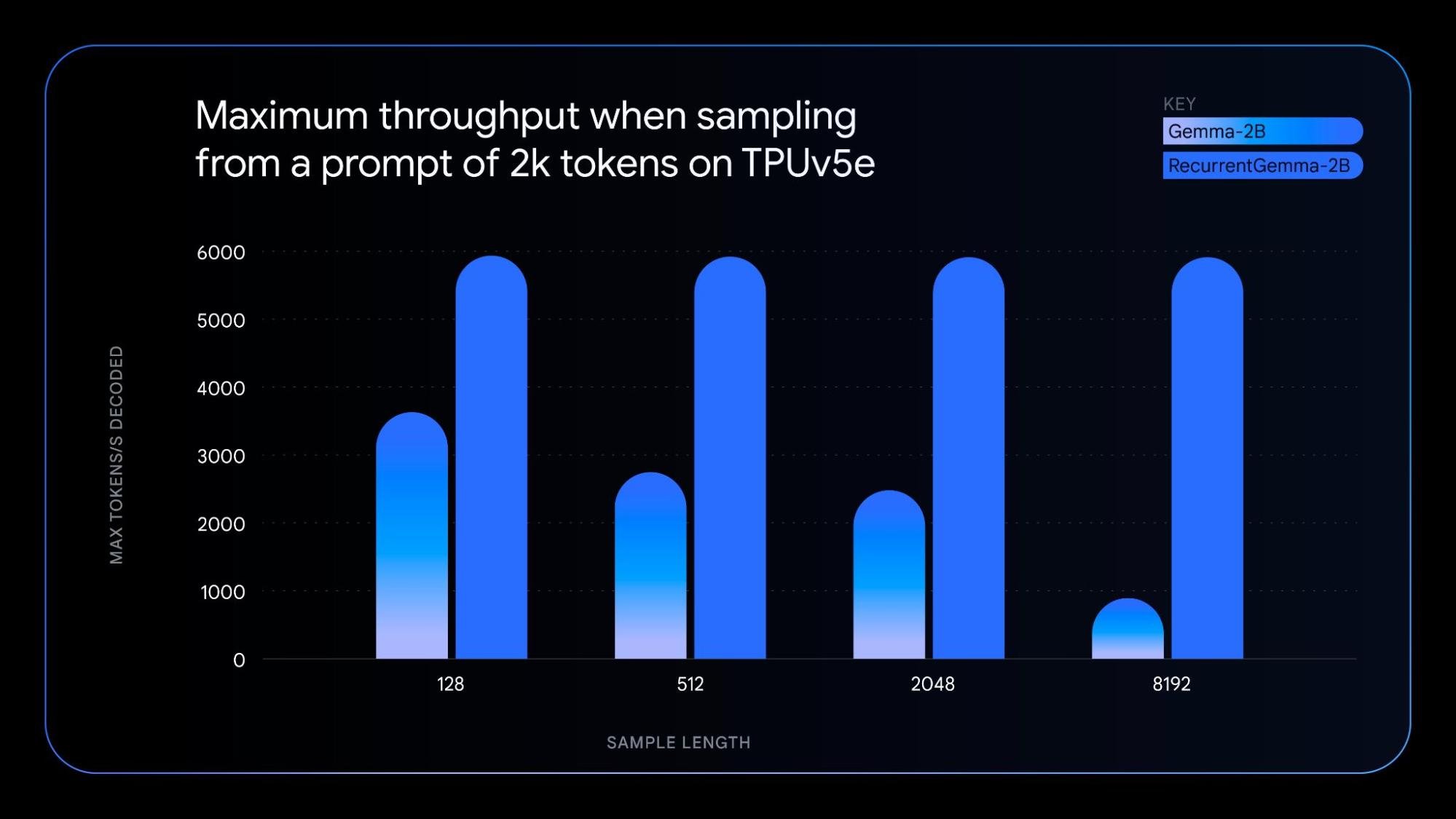

RecurrentGemma es un modelo técnicamente distintivo que aprovecha las redes neuronales recurrentes y la atención local para mejorar la eficiencia de la memoria. Si bien logra un rendimiento de puntaje de referencia similar al modelo Gemma 2B, la arquitectura única de RecurrentGemma tiene varias ventajas:

Para comprender la tecnología subyacente, consulta nuestro documento. Para realizar una exploración práctica, prueba este notebook, en el que se muestra cómo optimizar el modelo.

Las nuevas variantes del modelo, guiadas por los mismos principios de los modelos originales de Gemma, ofrecen lo siguiente:

- CodeGemma y RecurrentGemma: desarrollados con JAX y compatibles con JAX, PyTorch, Hugging Face Transformers y Gemma.cpp. Esto permite la experimentación local y la implementación rentable en varios hardware, como laptops, computadoras de escritorio, GPU NVIDIA y Google Cloud TPU.

- CodeGemma: además, es compatible con Keras, NVIDIA NeMo, TensorRT-LLM, Optimum-NVIDIA, MediaPipe y está disponible en Vertex AI.

- RecurrentGemma: la compatibilidad con todos los productos mencionados estará disponible en las próximas semanas.

Junto con las nuevas variantes del modelo, lanzamos Gemma 1.1, que incluye mejoras de rendimiento. Además, escuchamos los comentarios de los desarrolladores, corregimos errores y actualizamos nuestros términos para brindar más flexibilidad.

A partir de hoy, estas primeras variantes del modelo de Gemma están disponibles en varios lugares del mundo, en Kaggle, Hugging Face y Vertex AI Model Garden. Aquí te mostramos cómo empezar:

Te invitamos a probar los modelos CodeGemma y RecurrentGemma y a que compartas tus comentarios sobre Kaggle. Juntos, podemos darle forma al futuro de la creación y la comprensión de contenidos impulsados por IA.