150 resultados

14 DE JULHO DE 2025 / Gemini

The Gemini Embedding text model is now generally available in the Gemini API and Vertex AI. This versatile model has consistently ranked #1 on the MTEB Multilingual leaderboard since its experimental launch in March, supports over 100 languages, has a 2048 maximum input token length, and is priced at $0.15 per 1M input tokens.

10 DE JULHO DE 2025 / Gemini

GenAI Processors is a new open-source Python library from Google DeepMind designed to simplify the development of AI applications, especially those handling multimodal input and requiring real-time responsiveness, by providing a consistent "Processor" interface for all steps from input handling to model calls and output processing, for seamless chaining and concurrent execution.

10 DE JULHO DE 2025 / Cloud

Updates in Firebase Studio include new Agent modes, foundational support for the Model Context Protocol (MCP), and Gemini CLI integration, all designed to redefine AI-assisted development allow developers to create full-stack applications from a single prompt and integrate powerful AI capabilities directly into their workflow.

9 DE JULHO DE 2025 / Gemma

O T5Gemma é uma nova família de LLMs codificadores-decodificadores desenvolvida por meio da conversão e adaptação de modelos somente decodificadores pré-treinados com base no framework do Gemma 2. Ele oferece desempenho e eficiência superiores em comparação com seus equivalentes somente decodificadores, em particular para tarefas que exigem compreensão profunda de entradas, como resumos e traduções.

7 DE JULHO DE 2025 / Gemini

O novo modo de lote na API Gemini foi projetado para cargas de trabalho de IA de alta capacidade de processamento e não críticas em relação à latência, simplificando jobs grandes ao lidar com o agendamento e processamento. Além disso, ele torna tarefas como análise de dados, criação de conteúdo em massa e avaliação de modelos mais econômicas e escalonáveis, para que os desenvolvedores possam processar grandes volumes de dados com eficiência.

26 DE JUNHO DE 2025 / Gemma

O modelo Gemma 3n foi totalmente lançado, dando continuidade ao sucesso dos modelos Gemma anteriores e trazendo recursos multimodais avançados no dispositivo para dispositivos de borda com desempenho sem precedentes. Explore as inovações do Gemma 3n, incluindo arquitetura com foco em dispositivos móveis, tecnologia MatFormer, Per-Layer Embeddings, compartilhamento de cache KV e novos codificadores de áudio e visão MobileNet-V5, e veja como os desenvolvedores podem começar a criar com ele hoje mesmo.

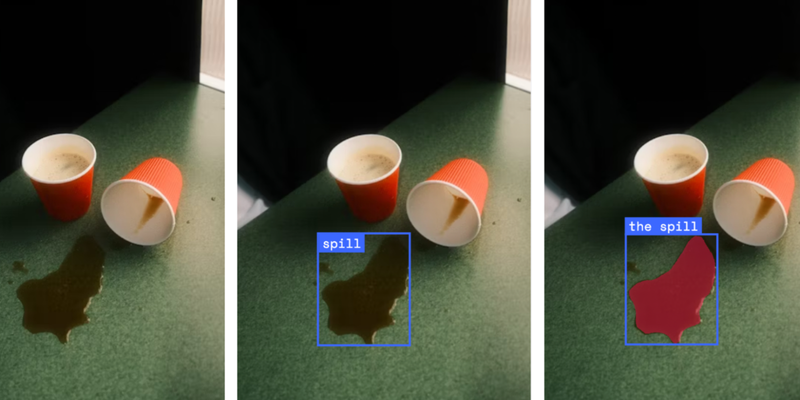

25 DE JUNHO DE 2025 / Gemini

Um protótipo de pesquisa que simula um sistema operacional neural gera IUs em tempo real, adaptando-se às interações do usuário com o Gemini 2.5 Flash-Lite, usando o rastreamento de interações para obter consciência contextual, fazendo o streaming da IU para garantir a capacidade de resposta e atingindo a manutenção de estado com um gráfico de IU na memória.

24 DE JUNHO DE 2025 / Gemini

O novo Google Colab com foco em IA aumenta a produtividade com melhorias promovidas por recursos como consulta iterativa para codificação conversacional, um Agente de ciência de dados de última geração para fluxos de trabalho autônomos e transformação de código sem esforço. Os usuários iniciais relatam um grande aumento de produtividade, projetos de ML acelerados, depuração de código mais rápida e criação de visualizações de alta qualidade sem esforço.

24 DE JUNHO DE 2025 / Kaggle

O KerasHub oferece aos usuários a capacidade de misturar e combinar arquiteturas e pesos de modelos em diferentes frameworks de aprendizado de máquina, permitindo que pontos de verificação de origens como o Hugging Face Hub (incluindo aqueles criados com o PyTorch) sejam carregados em modelos Keras para uso com JAX, PyTorch ou TensorFlow. Essa flexibilidade significa que você pode aproveitar uma vasta gama de modelos ajustados da comunidade, mantendo o controle total sobre o framework de back-end escolhido.

24 DE JUNHO DE 2025 / Gemini

O Gemini 2.5 Pro e o Gemini 2.5 Flash estão transformando a robótica ao melhorar a codificação, o raciocínio e os recursos multimodais, incluindo a compreensão espacial. Esses modelos são usados na compreensão semântica de cenas, na geração de código para controle de robôs e na criação de aplicativos interativos com a API Live, com forte ênfase em melhorias de segurança e aplicativos da comunidade.