32 resultados

4 DE SETEMBRO DE 2025 / Gemma

Apresentamos o EmbeddingGemma: um novo modelo de incorporação do Google, projetado para aplicativos de IA eficientes no dispositivo. Esse modelo aberto é o modelo de incorporação multilíngue somente de texto com a mais alta classificação na categoria de até 500 milhões de parâmetros no comparativo de mercado MTEB. Ele habilita recursos avançados, como RAG e pesquisa semântica, diretamente em dispositivos móveis sem necessidade de conexão com a Internet.

14 DE AGOSTO DE 2025 / Gemma

O novo Gemma 3 270M do Google é um modelo compacto de 270 milhões de parâmetros que oferece eficiência energética, quantização pronta para produção e um robusto acompanhamento de instruções, tornando-se uma solução poderosa para o ajuste específico de tarefa em configurações no dispositivo e de pesquisa.

9 DE JULHO DE 2025 / Gemma

O T5Gemma é uma nova família de LLMs codificadores-decodificadores desenvolvida por meio da conversão e adaptação de modelos somente decodificadores pré-treinados com base no framework do Gemma 2. Ele oferece desempenho e eficiência superiores em comparação com seus equivalentes somente decodificadores, em particular para tarefas que exigem compreensão profunda de entradas, como resumos e traduções.

26 DE JUNHO DE 2025 / Gemma

O modelo Gemma 3n foi totalmente lançado, dando continuidade ao sucesso dos modelos Gemma anteriores e trazendo recursos multimodais avançados no dispositivo para dispositivos de borda com desempenho sem precedentes. Explore as inovações do Gemma 3n, incluindo arquitetura com foco em dispositivos móveis, tecnologia MatFormer, Per-Layer Embeddings, compartilhamento de cache KV e novos codificadores de áudio e visão MobileNet-V5, e veja como os desenvolvedores podem começar a criar com ele hoje mesmo.

23 DE JUNHO DE 2025 / Kaggle

Os desenvolvedores adaptam LLMs como o Gemma para diversos idiomas e contextos culturais, demonstrando o potencial da IA para preencher lacunas de comunicação global ao lidar com desafios como tradução de textos antigos, localização de compreensão matemática e melhoria da sensibilidade cultural na tradução de letras de música.

20 DE MAIO DE 2025 / Gemma

O Gemma 3n é um modelo aberto de última geração, projetado para oferecer experiências de IA multimodal, rápidas e com execução local. Ele combina desempenho otimizado e flexibilidade singular com uma arquitetura 2 em 1 e compreensão multimodal expandida de áudio, permitindo que desenvolvedores criem aplicações interativas em tempo real e experiências avançadas centradas em voz.

9 DE MAIO DE 2025 / Cloud

Reveja os anúncios da Games Developer Conference (GDC) deste ano. Explore como os modelos Gemma e Gemini podem ajudar a incorporar experiências de IA a jogos com o lançamento do Gemma 3, o plug-in do Unity, sua aplicação em um jogo de exemplo e o escalonamento de jogos com a IA generativa no Google Cloud.

30 DE ABRIL DE 2025 / Gemma

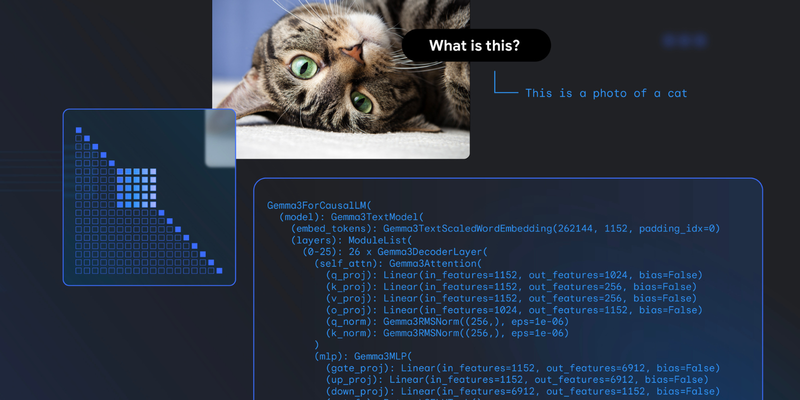

Os novos destaques do Gemma 3 incluem recursos de visão-linguagem e mudanças arquitetônicas para melhorar a eficiência da memória e o tratamento de contextos mais longos, em comparação com os modelos Gemma anteriores.

18 DE ABRIL DE 2025 / Gemma

O lançamento de versões int4 quantizadas dos modelos Gemma 3, otimizadas com treinamento com reconhecimento de quantização (QAT, na sigla em inglês) traz requisitos de memória significativamente reduzidos, permitindo que os usuários executem modelos poderosos, como Gemma 3 27B, em GPUs de consumidor final, como a NVIDIA RTX 3090.

25 DE MARÇO DE 2025 / Gemini

O Google DeepMind lança o TxGemma, que se baseia no Gemma e prevê propriedades terapêuticas, e o Agentic-Tx, que é habilitado pelo Gemini 2.0 Pro e lida com a resolução de problemas complexos de pesquisa usando ferramentas avançadas.