155 resultados

26 DE JUNHO DE 2025 / Gemma

O modelo Gemma 3n foi totalmente lançado, dando continuidade ao sucesso dos modelos Gemma anteriores e trazendo recursos multimodais avançados no dispositivo para dispositivos de borda com desempenho sem precedentes. Explore as inovações do Gemma 3n, incluindo arquitetura com foco em dispositivos móveis, tecnologia MatFormer, Per-Layer Embeddings, compartilhamento de cache KV e novos codificadores de áudio e visão MobileNet-V5, e veja como os desenvolvedores podem começar a criar com ele hoje mesmo.

25 DE JUNHO DE 2025 / Gemini

Um protótipo de pesquisa que simula um sistema operacional neural gera IUs em tempo real, adaptando-se às interações do usuário com o Gemini 2.5 Flash-Lite, usando o rastreamento de interações para obter consciência contextual, fazendo o streaming da IU para garantir a capacidade de resposta e atingindo a manutenção de estado com um gráfico de IU na memória.

24 DE JUNHO DE 2025 / Gemini

O novo Google Colab com foco em IA aumenta a produtividade com melhorias promovidas por recursos como consulta iterativa para codificação conversacional, um Agente de ciência de dados de última geração para fluxos de trabalho autônomos e transformação de código sem esforço. Os usuários iniciais relatam um grande aumento de produtividade, projetos de ML acelerados, depuração de código mais rápida e criação de visualizações de alta qualidade sem esforço.

24 DE JUNHO DE 2025 / Kaggle

KerasHub enables users to mix and match model architectures and weights across different machine learning frameworks, allowing checkpoints from sources like Hugging Face Hub (including those created with PyTorch) to be loaded into Keras models for use with JAX, PyTorch, or TensorFlow. This flexibility means you can leverage a vast array of community fine-tuned models while maintaining full control over your chosen backend framework.

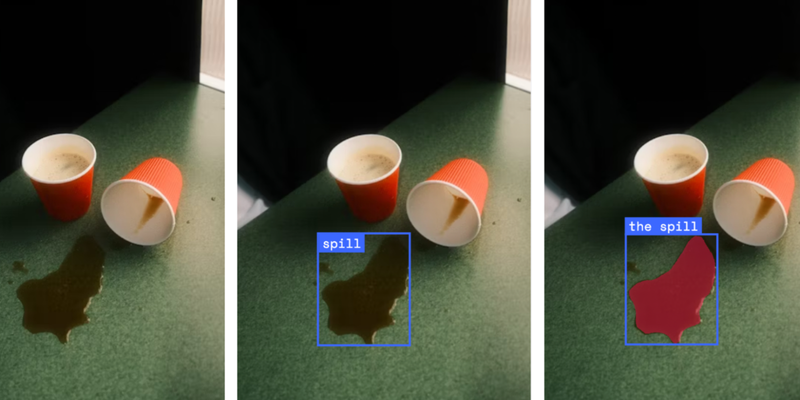

24 DE JUNHO DE 2025 / Gemini

O Gemini 2.5 Pro e o Gemini 2.5 Flash estão transformando a robótica ao melhorar a codificação, o raciocínio e os recursos multimodais, incluindo a compreensão espacial. Esses modelos são usados na compreensão semântica de cenas, na geração de código para controle de robôs e na criação de aplicativos interativos com a API Live, com forte ênfase em melhorias de segurança e aplicativos da comunidade.

24 DE JUNHO DE 2025 / Gemini

O Imagen 4, o avançado modelo de texto para imagem do Google, já está disponível na versão de pré-lançamento paga por meio da API Gemini e do Google AI Studio, oferecendo melhorias significativas de qualidade, especialmente para geração de texto dentro de imagens. A família Imagen 4 inclui o Imagen 4 para tarefas gerais e o Imagen 4 Ultra para resposta a prompts de alta precisão, com todas as imagens geradas apresentando uma marca d'água SynthID não visível.

23 DE JUNHO DE 2025 / Cloud

O Google, juntamente com a Amazon e a Cisco, anuncia a formação da Agent2Agent Foundation sob a The Linux Foundation, estabelecendo o A2A como um padrão do setor para a interoperabilidade de agentes de IA, promovendo um ecossistema diversificado, assegurando a governança neutra e acelerando a inovação segura em aplicativos de IA.

23 DE JUNHO DE 2025 / Kaggle

Os desenvolvedores adaptam LLMs como o Gemma para diversos idiomas e contextos culturais, demonstrando o potencial da IA para preencher lacunas de comunicação global ao lidar com desafios como tradução de textos antigos, localização de compreensão matemática e melhoria da sensibilidade cultural na tradução de letras de música.

18 DE JUNHO DE 2025 / Cloud

O Gemini Code Assist no gerenciamento de APIs da Apigee aprimora o desenvolvimento de APIs com recursos assistidos por IA, como criação de APIs em linguagem natural, resumos gerados por IA e design iterativo, permitindo uma integração simplificada com o ecossistema de APIs existente de sua organização e garantindo consistência, segurança e redução de duplicação, além de oferecer segurança de nível empresarial e um fluxo de trabalho de desenvolvimento simplificado.

17 DE JUNHO DE 2025 / Gemini

O Google está lançando atualizações na família de modelos Gemini 2.5, incluindo Gemini 2.5 Pro e Flash, disponíveis e estáveis, e os novos "modelos de pensamento" Gemini 2.5 Flash-Lite em pré-lançamento, oferecendo desempenho e acurácia aprimorados em uma opção de menor custo.