303 resultados

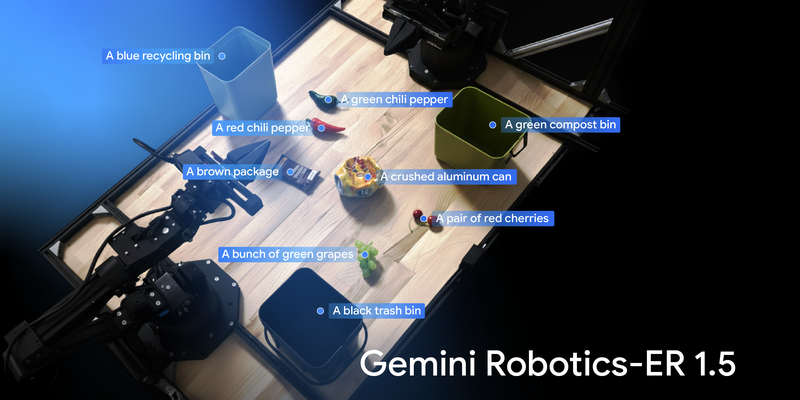

25 DE SETEMBRO DE 2025 / AI

O Gemini Robotics-ER 1.5, já disponível para desenvolvedores, é um modelo de raciocínio incorporado de última geração para robôs. Ele se destaca na compreensão visual e espacial, no planejamento de tarefas e na estimativa de progresso, permitindo que os robôs executem tarefas complexas com várias etapas.

25 DE SETEMBRO DE 2025 / AI

O Google está lançando os modelos Gemini 2.5 Flash e Flash-Lite de pré-lançamento atualizados, com melhorias de qualidade, velocidade e eficiência. Essas versões introduzem um alias "-latest" para facilitar o acesso às versões mais recentes, permitindo que os desenvolvedores testem e forneçam feedback para moldar futuras versões estáveis.

24 DE SETEMBRO DE 2025 / Cloud

O Colab está de volta com alguns recursos novos e empolgantes destinados a simplificar e melhorar se...

24 DE SETEMBRO DE 2025 / Mobile

O Google AI Edge fornece as ferramentas para executar recursos de IA no dispositivo, e seu novo ambiente de execução LiteRT-LM é um salto significativo para a IA generativa. O LiteRT-LM é uma API C++ de código aberto multiplataforma e com aceleração de hardware projetada para executar com eficiência modelos de linguagem grandes, como Gemma e Gemini Nano, em uma vasta gama de tipos de hardware. Sua principal inovação é uma arquitetura flexível e modular que pode ser escalonada para habilitar recursos multitarefa complexos no Chrome e no Chromebook Plus. Ele também é enxuto o suficiente para dispositivos com recursos limitados, como o Pixel Watch. Essa versatilidade já está habilitando uma nova onda de IA generativa no dispositivo, trazendo recursos como IA da Web e respostas inteligentes para os usuários.

24 DE SETEMBRO DE 2025 / AI

O Data Commons anuncia a disponibilidade de seu MCP Server, um marco importante para tornar todos os vastos conjuntos de dados públicos do Data Commons instantaneamente acessíveis e acionáveis para desenvolvedores de IA em todo o mundo.

22 DE SETEMBRO DE 2025 / AI

O Gemini CLI agora está totalmente integrado ao FastMCP, a principal biblioteca do Python para a criação de servidores MCP. Temos o prazer de anunciar essa integração entre dois projetos de código aberto, que permite a conexão fácil de ferramentas e prompts personalizados de MCP diretamente ao Gemini CLI!

16 DE SETEMBRO DE 2025 / AI

A recente versão 0.2.0 do Agent Development Kit (ADK) para Java do Google adiciona uma integração co...

10 DE SETEMBRO DE 2025 / AI

A API Batch agora dá suporte a incorporações e à compatibilidade com OpenAIHoje, estamos estendendo ...

9 DE SETEMBRO DE 2025 / AI

Embora o JAX seja bem conhecido como um framework muito utilizado no desenvolvimento de modelos de I...

9 DE SETEMBRO DE 2025 / AI

As extensões do A2A fornecem uma maneira flexível de adicionar funcionalidades personalizadas à comunicação entre agentes, indo além do protocolo A2A central. Elas habilitam recursos especializados e são definidas e implementadas abertamente.