130 resultados

18 DE JUNHO DE 2025 / Cloud

O Gemini Code Assist no gerenciamento de APIs da Apigee aprimora o desenvolvimento de APIs com recursos assistidos por IA, como criação de APIs em linguagem natural, resumos gerados por IA e design iterativo, permitindo uma integração simplificada com o ecossistema de APIs existente de sua organização e garantindo consistência, segurança e redução de duplicação, além de oferecer segurança de nível empresarial e um fluxo de trabalho de desenvolvimento simplificado.

17 DE JUNHO DE 2025 / Gemini

O Google está lançando atualizações na família de modelos Gemini 2.5, incluindo Gemini 2.5 Pro e Flash, disponíveis e estáveis, e os novos "modelos de pensamento" Gemini 2.5 Flash-Lite em pré-lançamento, oferecendo desempenho e acurácia aprimorados em uma opção de menor custo.

29 DE MAIO DE 2025 / Cloud

Três soluções de MarTech para desenvolvedores — sGTM Pantheon para controle de dados, GA4 Dataform para transformação de dados e FeedX para testes A/B de feeds de compras — capacitam os desenvolvedores a utilizar dados de marketing para obter insights, estratégias e resultados melhores.

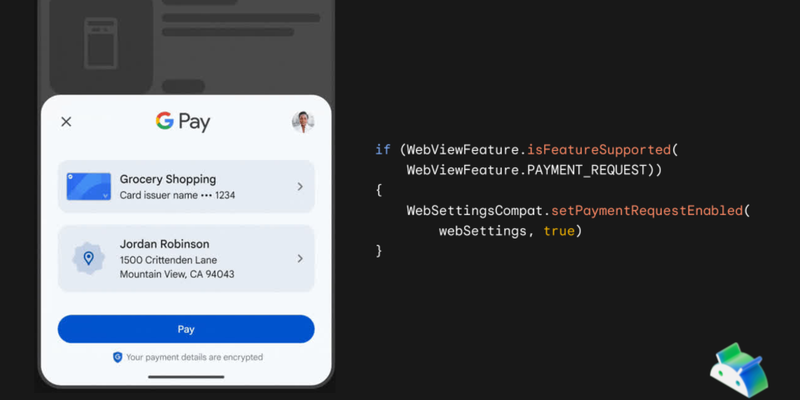

28 DE MAIO DE 2025 / Android

O suporte ao Google Pay no Android WebView já está disponível a partir do WebView versão 137 e do Google Play Services 25.18.30, permitindo que os usuários utilizem a planilha de pagamentos nativa do Google Pay em processos incorporados de finalização de compra na Web.

23 DE MAIO DE 2025 / Gemini

Anunciamos novos recursos e modelos para a API Gemini com a introdução da versão de Pré-lançamento do Gemini 2.5 Flash com raciocínio e eficiência aprimorados, do suporte da conversão de texto em voz a vários idiomas e falantes no Gemini 2.5 Pro e Flash e do diálogo de áudio nativo do Gemini 2.5 Flash para IA conversacional.

22 DE MAIO DE 2025 / Smart Home

A inteligência do Gemini está sendo integrada às APIs do Google Home, oferecendo aos desenvolvedores acesso a mais de 750 milhões de dispositivos e possibilitando recursos avançados, como análise de câmeras com IA e rotinas automatizadas.

22 DE MAIO DE 2025 / Wallet

A Carteira do Google se expandiu globalmente e introduziu novos recursos, como IDs digitais por meio de uma nova API Digital Credentials, notificações detalhadas de atualizações de cartões de transporte e notificações de cartões de transporte nas proximidades, além de outros recursos, como oportunidades de valor agregado e upgrade de cartões de transporte.

21 DE MAIO DE 2025 / Pay

No Google I/O 2025, novas atualizações da API Google Pay foram reveladas para melhorar as experiências de finalização de compra com recursos como a integração ao Android WebViews, uma API mais versátil e ferramentas aprimoradas para desenvolvedores.

21 DE MAIO DE 2025 / Google AI Studio

O Google AI Studio foi aprimorado para melhorar a experiência dos desenvolvedores, com geração de código nativo usando o Gemini 2.5 Pro, ferramentas para agentes, recursos expandidos de geração multimodal e novas funcionalidades como a aba Build, Live API e ferramentas aprimoradas para criar aplicações de IA mais sofisticadas.

20 DE MAIO DE 2025 / Gemini

O Google Colab está lançando uma versão reformulada com foco em IA no Google I/O, que traz um colaborador agêntico habilitado pelo Gemini 2.5 Flash com recursos de consulta iterativa, o upgrade do Agente de ciência de dados, transformação de código sem esforço e métodos de interação flexíveis com o objetivo de melhorar significativamente os fluxos de trabalho de codificação.