248 resultados

21 DE JULIO DE 2025 / Gemini

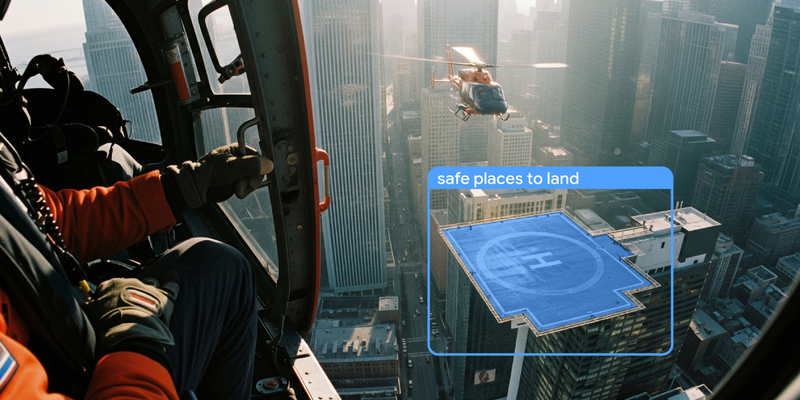

La función avanzada de Gemini para la segmentación de imágenes conversacionales permite una interacción intuitiva con datos visuales a través de la comprensión de frases complejas, lógica condicional y conceptos abstractos, agilizando la experiencia del desarrollador y abriendo puertas para nuevas aplicaciones en edición de medios, monitoreo de seguridad y evaluación de daños.

17 DE JULIO DE 2025 / Gemini

Veo 3, el modelo de generación de video de IA de Google más reciente, ahora está disponible en versión preliminar pagada a través de la API de Gemini y Google AI Studio. Presentado en Google I/O 2025, Veo 3 puede generar tanto video como audio sincronizado, y puede incluir diálogos, sonidos de fondo e incluso ruidos de animales. Este modelo ofrece efectos visuales realistas, iluminación natural y física, con una sincronización de labios y un sonido precisos que coinciden con la acción en pantalla.

16 DE JULIO DE 2025 / AI

La función "logprobs" se introdujo oficialmente en la API de Gemini en Vertex AI. Proporciona información sobre la toma de decisiones del modelo al mostrar puntajes de probabilidad para tokens elegidos y alternativos. Esta guía paso a paso te mostrará cómo habilitar e interpretar esta función, y aplicarla a casos de uso poderosos, como la clasificación segura, el autocompletado dinámico y la evaluación cuantitativa de RAG.

16 DE JULIO DE 2025 / Cloud

El proyecto Marin tiene como objetivo ampliar la definición de "abierto" en IA para incluir todo el proceso científico, no solo el modelo en sí, haciendo que el proceso de desarrollo completo sea accesible y reproducible. Esta iniciativa, impulsada por el framework JAX y su herramienta Levanter, permite realizar un profundo escrutinio, confiar y compilar sobre modelos básicos, fomentando un futuro más transparente para la investigación en IA.

16 DE JULIO DE 2025 / Gemini

El Agent Development Kit (ADK) actualizado simplifica y acelera el proceso de creación de agentes de IA proporcionando a la CLI una comprensión profunda y rentable del marco de trabajo del ADK, lo que permite a los desarrolladores crear, generar, probar y mejorar rápidamente los agentes funcionales a través de indicaciones conversacionales, con lo que se elimina la fricción y se mantiene a los agentes en un estado de “flujo” productivo.

14 DE JULIO DE 2025 / Cloud

El concentrador de APIs de Apigee y los portales para desarrolladores son partes distintas, pero interconectadas, de la plataforma Apigee que ayudan a las organizaciones a descubrir y administrar APIs para diferentes perfiles ficticios, revelando el potencial de la API y acelerando la innovación.

14 DE JULIO DE 2025 / Gemini

El modelo de texto Gemini Embedding ahora está disponible de forma general en la API de Gemini y Vertex AI. Este versátil modelo se ha clasificado constantemente como el número 1 en el ranking multilingüe de MTEB desde su lanzamiento experimental en marzo, admite más de 100 idiomas, tiene una longitud máxima de token de entrada de 2,048 y tiene un precio de USD 0.15 por 1 millón de tokens de entrada.

10 DE JULIO DE 2025 / Gemini

GenAI Processors es una nueva biblioteca Python de código abierto de Google DeepMind diseñada para simplificar el desarrollo de aplicaciones de IA, especialmente aquellas que manejan entradas multimodales y requieren capacidad de respuesta en tiempo real, al proporcionar una interfaz de “procesador” coherente para todos los pasos, desde el manejo de entradas hasta el procesamiento de llamadas y salidas de modelos, para un encadenamiento sin interrupciones y una ejecución simultánea.

10 DE JULIO DE 2025 / Cloud

Las actualizaciones en Firebase Studio incluyen nuevos modos de agente, soporte fundamental para el protocolo de contexto de modelo (MCP) e integración de Gemini CLI, todos diseñados para redefinir el desarrollo asistido por IA, lo que permite a los desarrolladores crear aplicaciones de pila completa a partir de una sola indicación e integrar potentes capacidades de IA directamente en su flujo de trabajo.

9 DE JULIO DE 2025 / Gemma

T5Gemma es una nueva familia de LLM de codificador-decodificador desarrollados mediante la conversión y adaptación de modelos preentrenados de solo decodificador basados en el marco Gemma 2, que ofrecen un rendimiento y una eficiencia superiores en comparación con sus contrapartes de solo decodificador, en particular para tareas que requieren una profunda comprensión de entrada, como resúmenes y traducción.