32 resultados

10 DE JULIO DE 2025 / Gemini

GenAI Processors is a new open-source Python library from Google DeepMind designed to simplify the development of AI applications, especially those handling multimodal input and requiring real-time responsiveness, by providing a consistent "Processor" interface for all steps from input handling to model calls and output processing, for seamless chaining and concurrent execution.

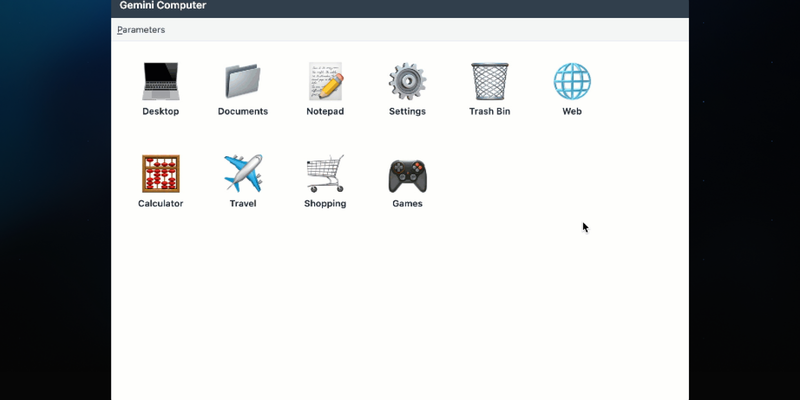

25 DE JUNIO DE 2025 / Gemini

Un prototipo de investigación que simula un sistema operativo neural genera una interfaz de usuario en tiempo real que se adapta a las interacciones del usuario con Gemini 2.5 Flash-Lite, utilizando el rastreo de interacciones para la conciencia contextual, la transmisión de la interfaz de usuario para la capacidad de respuesta y el logro de estado con un gráfico de interfaz de usuario en memoria.

24 DE JUNIO DE 2025 / Kaggle

KerasHub permite a los usuarios mezclar y combinar arquitecturas y pesos de modelos en diferentes marcos de trabajo de aprendizaje automático, de modo que los puntos de control de fuentes como Hugging Face Hub (incluidos los creados con PyTorch) se puedan cargar en los modelos de Keras para usar con JAX, PyTorch o TensorFlow. Gracias a esta flexibilidad, puedes aprovechar una amplia gama de modelos ajustados por los miembros de la comunidad, al tiempo que mantienes un control total sobre el marco de trabajo de backend elegido.

24 DE JUNIO DE 2025 / Gemini

Gemini 2.5 Pro y Flash están transformando la robótica a través de la mejora de la codificación, el razonamiento y las capacidades multimodales, incluida la comprensión espacial. Estos modelos se utilizan para la comprensión semántica de escenas, la generación de código para el control de robots y la creación de aplicaciones interactivas con la API Live, con un fuerte énfasis en las mejoras de seguridad y las aplicaciones comunitarias.

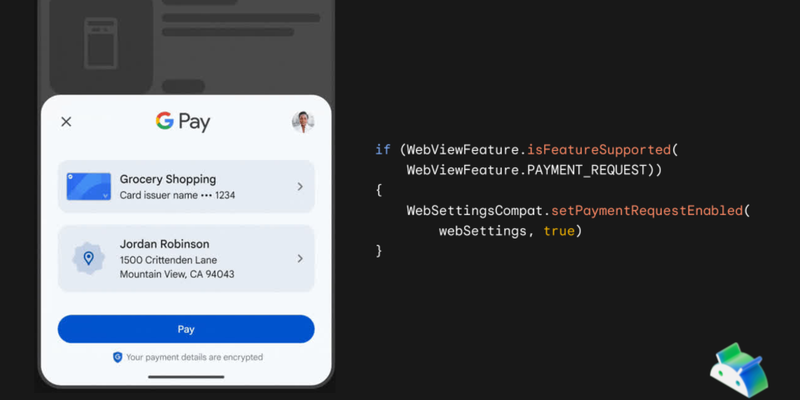

28 DE MAYO DE 2025 / Android

Ya está disponible la compatibilidad con Google Pay dentro de Android WebView, comenzando con la versión 137 de WebView y Servicios de Play 25.18.30, lo que permite a los usuarios utilizar el procesador de pagos nativo de Google Pay dentro de los procesos web incorporados de confirmación de la compra.

28 DE MAYO DE 2025 / Gemini

El proyecto “Espejo Mágico” utiliza la API de Gemini, e incluye la API Live, la llamada a funciones y la conexión con la Búsqueda de Google, para crear una experiencia interactiva y dinámica, y demostrar el poder de los modelos de Gemini para generar imágenes, contar historias y brindar información en tiempo real a través de un objeto familiar.

20 DE MAYO DE 2025 / AI Edge

Se implementaron mejoras en LiteRT para aumentar el rendimiento y la eficiencia del modelo de IA en dispositivos móviles mediante la utilización efectiva de GPU y NPU, que ahora requieren mucho menos código, lo que permite una selección simplificada del acelerador de hardware y ofrece más capacidades para lograr un rendimiento óptimo en el dispositivo.

31 DE MARZO DE 2025 / Gemini

La API de Gemini y el microcontrolador ESP32 simplifican los comandos de voz personalizados para dispositivos IoT, ya que aprovechan el reconocimiento de voz para que los dispositivos comprendan los comandos personalizados y reaccionen a ellos, de modo que se cierra la brecha entre el mundo digital y el físico.

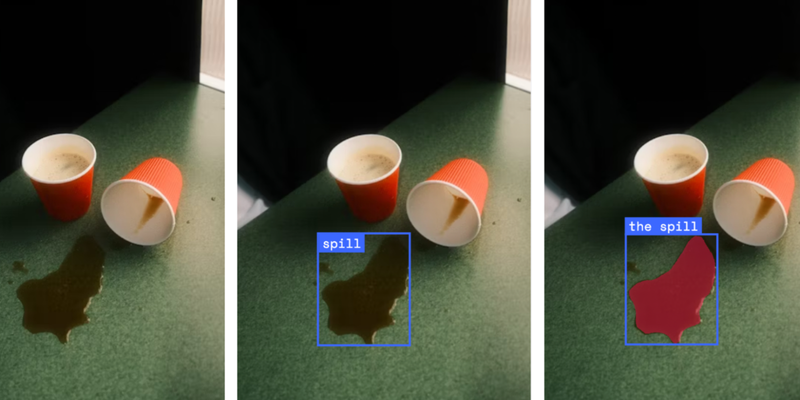

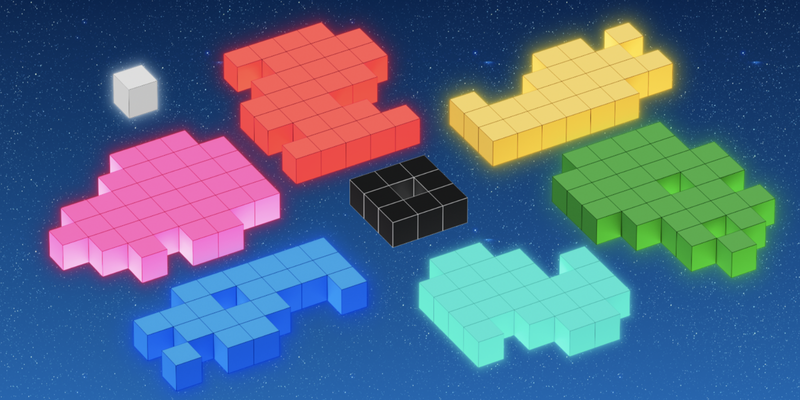

13 DE MARZO DE 2025 / Gemini

En el rompecabezas de Google I/O 2025, se utilizó la API de Gemini a fin de generar acertijos dinámicos para mundos de bonificación, lo que mejoró el compromiso y la escalabilidad de los jugadores. Aquí te contamos lo que nuestros desarrolladores aprendieron sobre el uso efectivo de la API de Gemini, incluidas la creatividad, el diseño y las estrategias de implementación.

12 DE MARZO DE 2025 / Gemma

Gemma 3 1B, un nuevo modelo de lenguaje pequeño para aplicaciones móviles y web a través de Google AI Edge, ya está disponible y ahora cuenta con mayor eficiencia, rendimiento mejorado y disponibilidad sin conexión.