Exploremos los aspectos más destacados y los logros de las vastas comunidades de Machine Learning (ML) de Google durante el segundo trimestre de 2023. Estamos entusiasmados y agradecidos por todas las actividades que realizó la red global de comunidades de ML. ¡Estos son los aspectos destacados!

Más de 35 comunidades de todo el mundo organizaron campañas de ML, distribuidas por el equipo de Programas para Desarrolladores de ML durante la primera mitad del año. ¡Gracias a todos por los esfuerzos hechos para entrenar a toda la comunidad de ML!

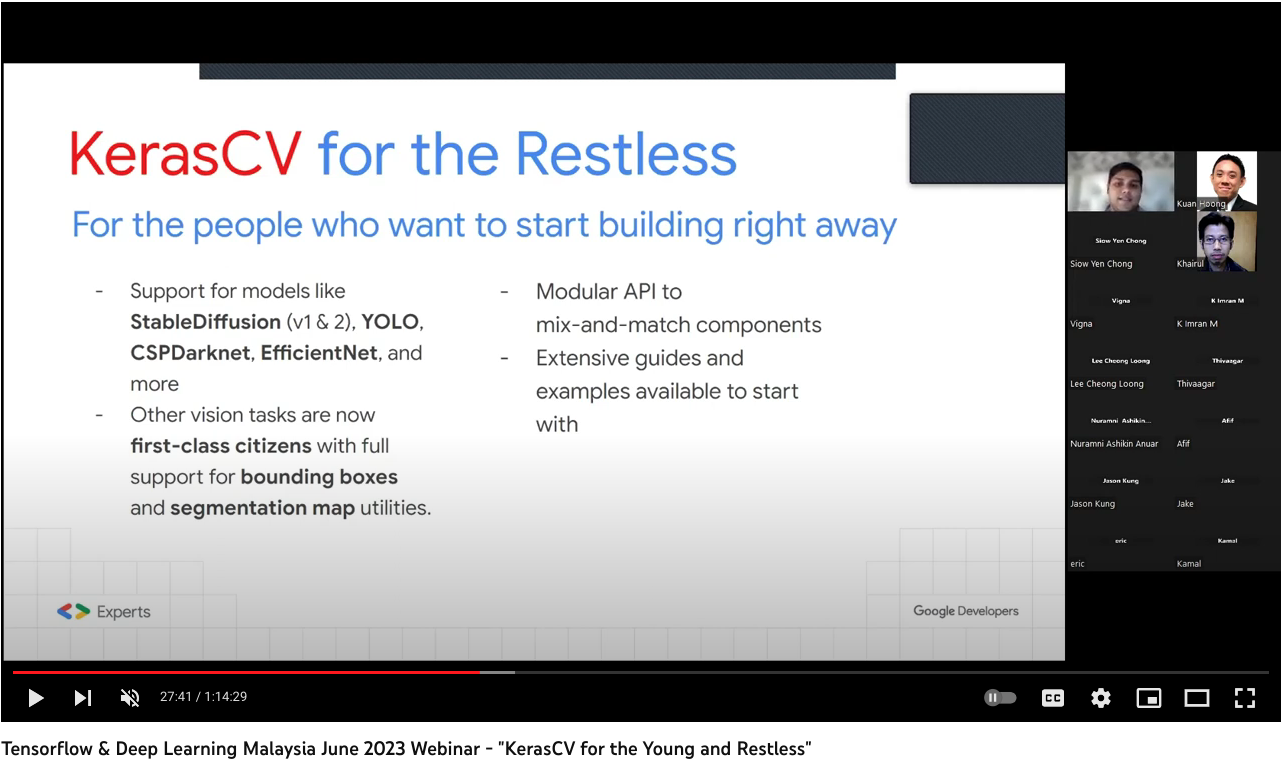

Image Segmentation using Composable Fully-Convolutional Networks de Suvaditya Mukherjee (India), GDE de ML, es un ejemplo de Kears.io, que explica cómo implementar una red totalmente convolucional con un backend VGG-16 y cómo usarla para realizar la segmentación de imágenes. Su presentación, KerasCV for the Young and Restless (diapositivas | video) en TFUG Malaysia y TFUG Kolkata fue una introducción a KerasCV. En ella, contó sobre cómo funcionan los componentes básicos de visión por computadora, por qué Keras es una herramienta importante y cómo KerasCV se basa en el ecosistema TFX y Keras establecido.

En [ML Story] My Keras Chronicles, Aritra Roy Gosthipaty (India), GDE de ML, resumió la historia de cómo se involucró en el aprendizaje profundo con Keras. Incluyó consejos sobre la forma en que se puede ingresar a la comunidad de código abierto. Además, sus notas de Kaggle, [0.11] keras starter: unet + tf data pipeline son una guía de inicio para Vesuvius Challenge. Subvaditya y él también compartieron la implementación de Keras de redes de cuello de botella latente temporal, que se propone en el documento.

KerasFuse, de Ayse Ayyuce Demirbas (Portugal), GDE de ML, es una biblioteca de Python que combina el poder de TensorFlow y Keras con varias técnicas de visión por computadora para tareas de análisis de imágenes médicas. Proporciona una colección de módulos y funciones que facilitan el desarrollo de modelos de aprendizaje profundo en TensorFlow y Keras en relación con tareas como segmentación de imágenes, clasificación y más.

En TensorFlow en Google I/O 23: A Preview of the New Features and Tools, de TFUG Ibadán, se analizó la versión preliminar de las últimas funciones y herramientas de TensorFlow. Se cubrió una amplia variedad de temas, incluidos Dtensor, KerasCV, & KerasNLP, API de cuantificación de TF y JAX2TF.

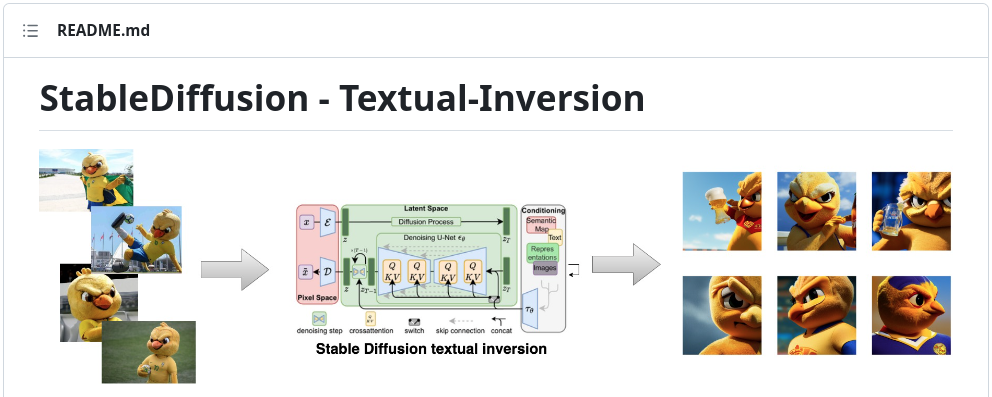

La app de implementación de inversión textual de Stable Diffusion, de Dimitre Oliveira (Brasil), GDE de ML, es un ejemplo de cómo implementar el código de la investigación y afinarlo mediante el proceso de inversión textual. También proporciona casos de uso relevantes para herramientas y marcos de trabajo valiosos, como HuggingFace, Gradio, TensorFlow y KerasCV.

En Understanding Gradient Descent and Building an Image Classifier in TF From Scratch, Tanmay Bakshi (Canadá), GDE de ML, habló sobre cómo desarrollar una intuición sólida para los fundamentos que respaldan la tecnología de ML y compiló un sistema de clasificación de imágenes reales para perros y gatos, desde cero, en TF.Keras.

El documento TensorFlow y Keras Implementation of the CVPR 2023, de Usha Rengaraju (India), es una investigación sobre la implementación de BiFormer: transformador de visión con atención de enrutamiento de dos niveles.

Smile Detection with Python, OpenCV, and Deep Learning, de Rouizi Yacine, es un tutorial en el que se explica cómo usar el aprendizaje profundo para crear un detector de sonrisas más sólido con TensorFlow, Keras y OpenCV.

La Olimpiada de ML para estudiantes, de GDSC UNINTER, se dirigió a estudiantes y aspirantes a profesionales de ML que deseaban mejorar las habilidades de ML. Consistió en un desafío de predicción de las solicitudes de visa de trabajo de los Estados Unidos. Más de 320 asistentes se registraron para el evento de apertura, hubo más de 700 visitas en YouTube, 66 equipos compitieron y el ganador obtuvo un 71% de puntuación F1.

ICR | EDA & Baseline, de Ertuğrul Demir (Turquía), GDE de ML es un bloc de notas para quienes recién están interesados en el último concurso de código presentado en Kaggle. Obtuvo más de 200 votos a favor y más de 490 tenedores.

Compete More Effectively on Kaggle using Weights and Biases, de TFUG Hajipur, fue un encuentro en el que se exploraron las técnicas que utilizan pesos y sesgos para mejorar el rendimiento de los modelos en las competiciones de Kaggle. Usha Rengaraju (India) expuso sus ideas sobre Kaggle y las estrategias para ganar competiciones. Compartió sugerencias y trucos, y demostró cómo configurar una cuenta W&B y cómo realizar integraciones con Google Colab y Kaggle.

Skeleton Based Action Recognition: A failed attempt, de Ayush Thakur (India), GDE de ML, es una publicación en la que se discute acerca de la documentación de sus aprendizajes al participar de la competencia Kaggle, Google - Reconocimiento de lenguaje de señas aislado. Compartió su repositorio, los registros de capacitación y las ideas que abordó en la competencia. Además, en su artículo Keras Dense Layer: How to Use It Correctly, analizó qué es la capa densa en Keras y cómo funciona en la práctica.

Add Machine Learning to your Android App, de Pankaj Rai (India), GDE de ML, parte de Tech Talks for Educators, fue una sesión sobre aprendizaje automático integrado en el dispositivo y cómo agregar capacidades de aprendizaje automático a las aplicaciones de Android, como, por ejemplo, detectar objetos y gestos. Explicó las capacidades del kit de ML, MediaPipe, TF Lite y cómo usar estas herramientas. Más de 700 personas se inscribieron en la charla.

En MediaPipe with a bit of Bard en I/O Extended Singapore 2023, Martin Andrews (Singapur), GDE de ML, mostró cómo MediaPipe se adapta al ecosistema y presentó 4 demostraciones diferentes de la funcionalidad de MediaPipe: clasificación de audio, puntos de referencia faciales, segmentación interactiva y clasificación de texto.

Adding ML to our apps with Google ML Kit and MediaPipe de Juan Guillermo Gómez Torres (Bolivia), GDE de ML, presentó ML Kit y MediaPipe, y los beneficios de ML integrados en el dispositivo. En Startup Academy México (Google for Startups), compartió cómo aumentar el valor para los clientes con ML y MediaPipe.

En Introduction to Google's PaLM 2 API, Hannes Hapke (Estados Unidos), GDE de ML, presentó cómo usar PaLM2 y resumió sus principales ventajas. En su otro artículo The role of ML Engineering in the time of GPT-4 & PaLM 2, explica cuál es el papel de los expertos en ML a la hora de buscar el equilibrio y la alineación adecuados entre las partes interesadas para explorar de manera óptima las oportunidades y los desafíos planteados por esta tecnología emergente. Hizo presentaciones con el mismo título en North America Connect 2023 y en el evento GDG Portland.

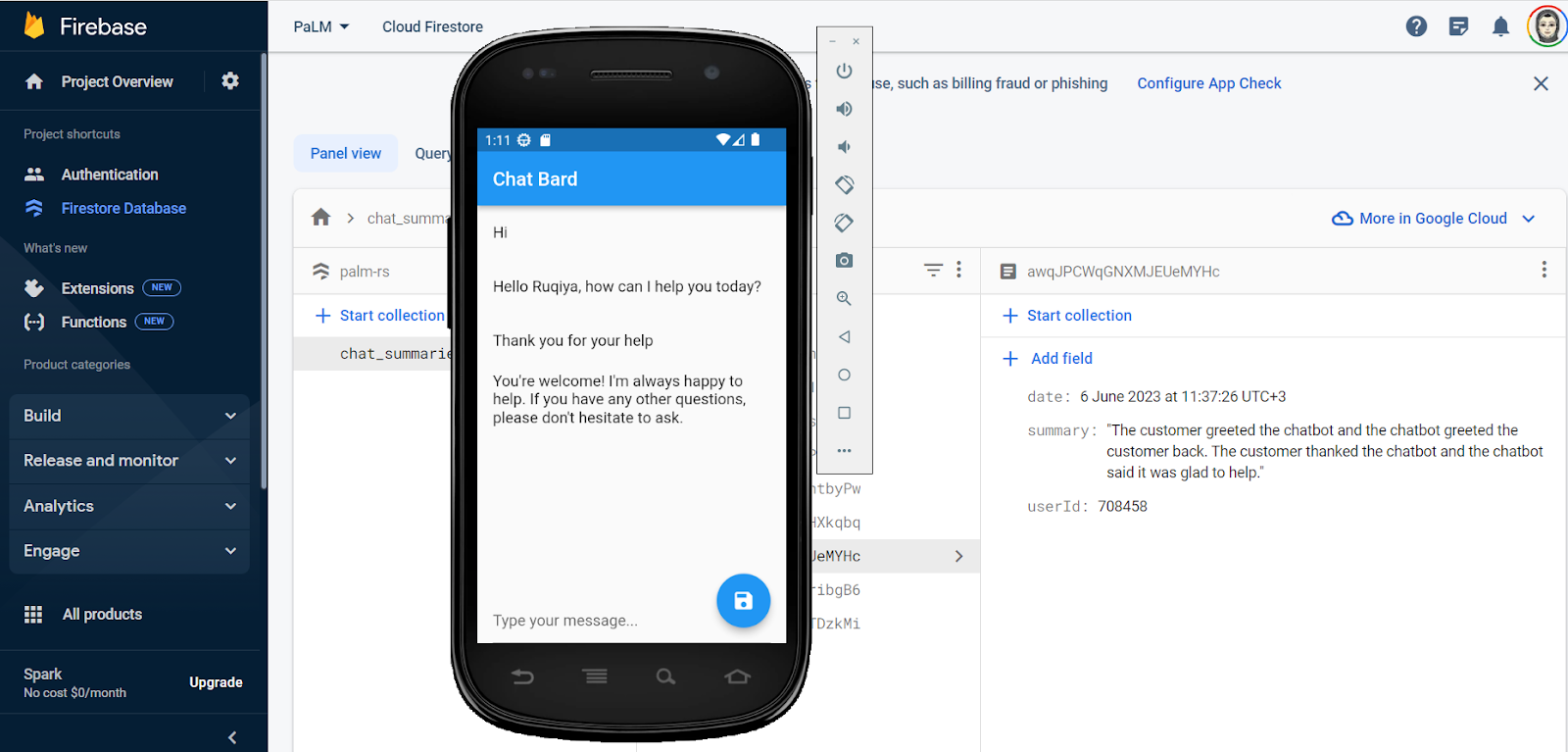

ChatBard: An Intelligent Customer Service Center App, de Ruqiya Bin Safi (Arabia Saudita), GDE de ML, es una app inteligente del centro de servicio al cliente que cuenta con tecnología de IA generativa y LLM, y utiliza API PaLM2.

En Bard can now code and put that code in Colab for you, Sam Witteveen (Singapur), GDE de ML, mostró cómo Bard crea código. Sam tiene un canal de Youtube en el que explora el aprendizaje automático y la IA, con listas de reproducción como Generative AI, Paper Reviews, LLM y LangChain.

En Bard Can Write Code de Google, Bhavesh Bhatt (India), GDE de ML, muestra las capacidades de codificación de Bard, cómo crear un juego 2048 con esta app y cómo agregar algunas características básicas al juego. También cargó videos sobre LangChain en una lista de reproducción y presentó el nuevo curso sobre IA generativa de Google Cloud en este video.

Attention Mechanisms and Transformers, de GDG Cloud Arabia Saudita, trata sobre la atención y el transformador en PLN. Por su parte, Ruqiya Bin Safi (Arabia Saudita), GDE de ML, participó como ponente. En otro evento, Hands-on with the PaLM2 API to create smart apps (Jeddah), se mostró qué son LLM, PaLM2 y Bard, cómo usar la API PaLM2 y cómo crear apps inteligentes con la API de PaLM2.

Hands-on with Generative AI: Google I/O Extended [Virtual], de Henry Ruiz (Estados Unidos), GDE de ML, y Rabimba Karanjai (Estados Unidos), GDE Web, fue un taller sobre IA generativa en el que se mostraron los desafíos prácticos de cómo comenzar a usar herramientas como PaLM API, Hugging Face Transformers y el marco de trabajo LangChain.

Generative AI with Google PaLM and MakerSuite, de Kuan Hoong (Malasia), GDE de ML, en el marco de Google I/O Extended George Town 2023, fue una charla sobre LLM con Google PaLM y MakerSuite. GDG George Town organizó el evento y también se incluyeron temas de ML, como LLM, IA responsable y MLOps.

Intro to Gen AI with PaLM API and MakerSuite, de TFUG San Pablo, se dirigió a aquellas personas que desean aprender IA generativa y cómo las herramientas de Google pueden ayudar a adoptar y crear valor. Se analizó cómo comenzar a crear prototipos de ideas de IA generativa con MakerSuite y cómo acceder a las funciones avanzadas de las API de PaLM2 y PaLM. El grupo también organizó Opening Pandora's box: Understanding the paper that revolutionized the field of NLP (video), y los GDE de ML Pedro Gengo (Brasil) y Vinicius Caridá (Brasil) compartieron el secreto detrás del famoso LLM y otros modelos de IA generativa. Los miembros del grupo analizaron juntos el documento Attention Is All You Need y se informaron de todo el potencial que puede ofrecer la tecnología.

Language models which PaLM can speak, see, move, and understand, de GDG Cloud Taipei, se dirigió a aquellas personas que desean comprender el concepto y la app de PaLM. Jerry Wu (Taiwán), GED de ML, compartió las principales características, funciones, etc. del PaLM.

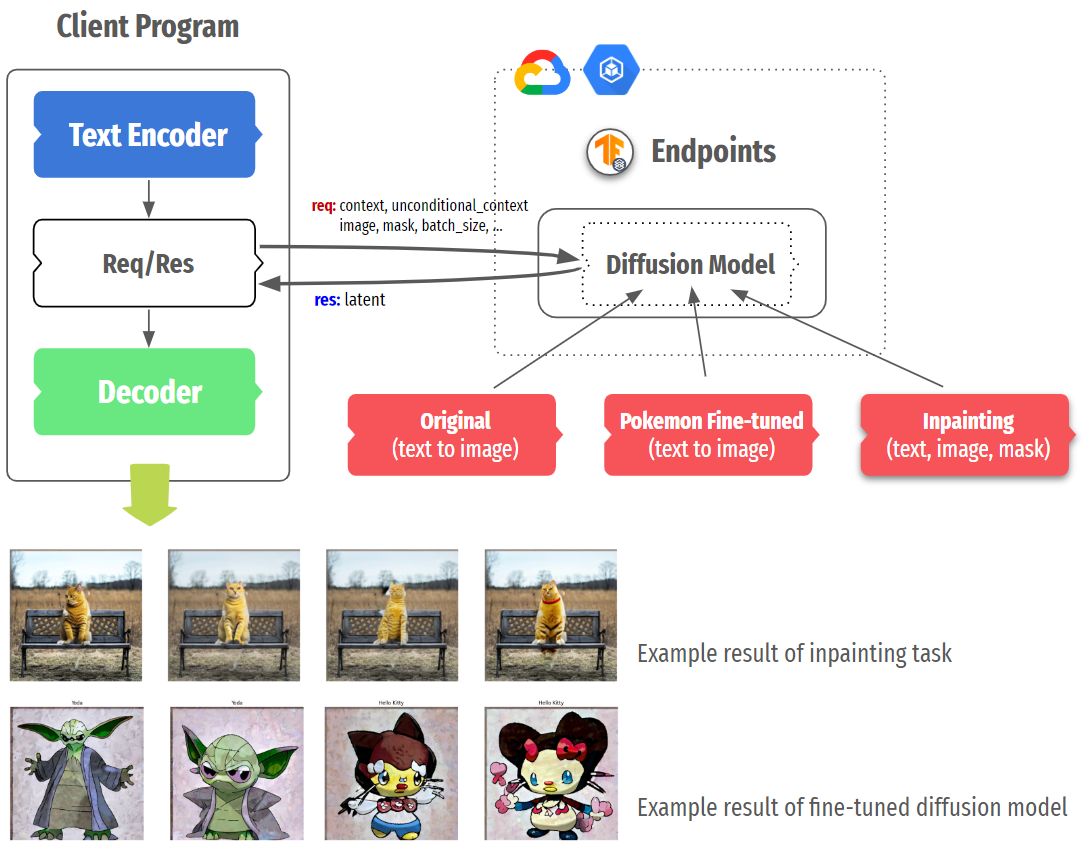

En Serving With TF and GKE: Stable Diffusion, Chansung Park (Corea), GDE de ML, y Sayak Paul (India), GDE de ML, analizan cómo TF Serving y Kubernetes Engine pueden servir a un sistema con implementación en línea. Analizaron los componentes principales de la difusión y explicaron qué influencia tienen a la hora de considerar su despliegue. Luego, también hablaron sobre los bits específicos de la implementación, como la implementación de TF Serving y la configuración del clúster k8s.

En TFX + W&B Integration, Chansung Park (Corea), GDE de ML, se muestra cómo se puede usar KerasTuner con la función de seguimiento de experimentos de W&B dentro del componente TFX Tuner. Chansung desarrolló un componente TFX personalizado para llevar un modelo completamente entrenado a la tienda W&B Artifact y publicar una aplicación de trabajo en Hugging Face Space con la versión actual del modelo. Además, en su charla titulada, ML Infra and High Level Framework in Google Cloud Platform, explicó qué es MLOps, por qué es difícil usarlo, por qué cloud + TFX es un buen comienzo y cómo TFX se integra a la perfección con Vertex AI y Dataflow. Compartió casos de uso de los proyectos anteriores que él y Sayak Paul (India), GDE de ML, realizaron en los últimos 2 años.

Open and Collaborative MLOps, de Sayak Paul (India), GDE de ML, fue una charla sobre por qué la apertura y la colaboración son dos aspectos importantes de MLOps. Dio una descripción general de Hugging Face Hub y cómo se integra correctamente con TFX para promover la apertura y la colaboración en los flujos de trabajo de MLOps.

En Paper review: PaLM 2 Technical Report, Grigory Sapunov (Reino Unido), GDE de ML, analizó los detalles de PaLM2 y el documento en sí. Compartió reseñas de artículos relacionados con Google y DeepMind a través de sus canales sociales y aquí se muestran algunos de ellos: Evaluación de modelos para riesgos extremos (artículo), Algoritmos de clasificación más rápidos descubiertos mediante el aprendizaje de refuerzo profundo (artículo), La búsqueda de poder puede ser probable y predictiva para agentes capacitados (artículo).

En Learning JAX in 2023: Part 3 — A Step-by-Step Guide to Training Your First Machine Learning Model with JAX, de Aritra Roy Gosthipaty (India) y Ritwik Raha (India), GDE de ML, se muestra cómo JAX puede entrenar modelos de regresión lineal y no lineal y el uso de la biblioteca PyTrees para entrenar un modelo de perceptrón multicapa. Además, en May 2023 Meetup, organizado por TFUG Mumbai, ofrecieron una charla titulada Decoding End to End Object Detection with Transformers y trataron la arquitectura del modo y los diversos componentes que llevaron al origen de DETR.

En 20 steps to train a deployed version of the GPT model on TPU, Jerry Wu (Taiwán), GDE de ML, brindó información sobre cómo usar JAX y TPU para entrenar e inferir datos chinos de preguntas y respuestas.

Multimodal Transformers - Custom LLMs, ViTs& BLIPs, de TFUG Singapore, se analizó qué modelos, sistemas y técnicas se lanzaron recientemente en relación con las tareas multimodales. Sam Witteveen (Singapur), GDE de ML, analizó varios modelos y sistemas multimodales y la forma en que puede crear los suyos propios con el modelo PaLM2. En junio, este grupo invitó a Blaise Agüera y Arcas (vicepresidente y miembro de Google Research) y compartió el proyecto Cerebra y la investigación que se lleva a cabo en Google DeepMind, incluidos los desarrollos actuales y futuros en IA generativa y las tendencias emergentes.

En Training a recommendation model with dynamic embeddings, Thushan Ganegedara (Australia), GDE de ML, explica cómo construir un modelo de recomendación de películas aprovechando TensorFlow Recommenders (TFR) y TensorFlow Recommenders Addons (TFRA). El objetivo principal era mostrar cómo se pueden utilizar las incrustaciones dinámicas proporcionadas en la biblioteca TFRA para aumentar y reducir dinámicamente el tamaño de las tablas de incrustación en el entorno de recomendaciones.

How I built the most efficient deepfake detector in the world for $100, de Mathis Hammel (Francia), GDE de ML, fue una charla en la que se exploró un método para detectar imágenes generadas a través de ThisPersonDoesNotExist.com e, incluso, una forma de saber la hora exacta en que se generó la foto. Además, su hilo de Twitter, OSINT Investigation on LinkedIn investigó una red de empresas falsas en LinkedIn. Utilizó una herramienta casera basada en un modelo de TensorFlow y la alojó en Google Cloud. También se incluyeron explicaciones técnicas de las redes neuronales generativas. Más de 701.000 personas vieron este hilo y obtuvo más de 1200 RT y más de 3100 Me gusta.

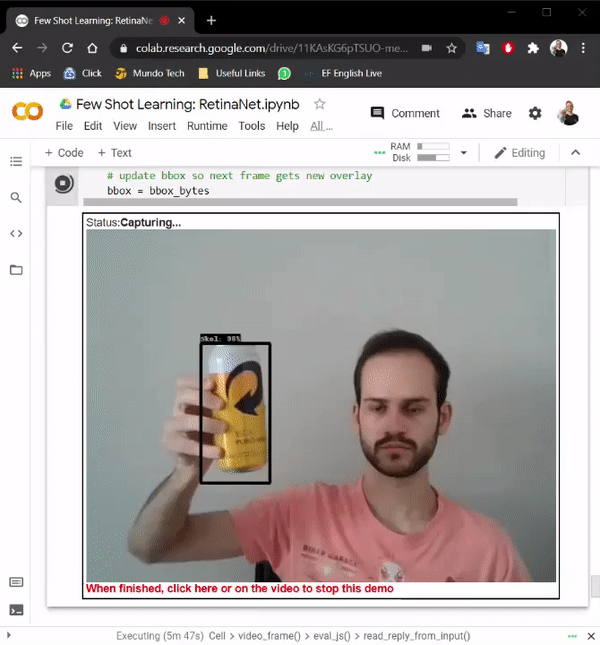

En Few-shot learning: Creating a real-time object detection using TensorFlow and Python, Hugo Zanini (Brasil), GDE de ML, muestra cómo tomar fotografías de un objeto con una cámara web, etiquetar las imágenes y entrenar un modelo de aprendizaje de pocas tomas para que se ejecute en tiempo real. Además, en su artículo Custom YOLOv7 Object Detection with TensorFlow.js, explica cómo entrenó un modelo personalizado de YOLOv7 para ejecutarlo directamente en el navegador en tiempo real y sin contar con conexión con TensorFlow.js.

The Lord of the Words: The Return of the experiments with DVC (slides), de Gema Parreno Piqueras (España), GDE de ML, fue una charla que se centró en Transformers en el escenario de aprendizaje automático neuronal y en cómo usar Tensorflow y DVC. En el proyecto, Gema utilizó el catálogo de traducción de conjuntos de datos de Tensorflow para cargar datos de varios idiomas y la biblioteca Transformers de TensorFlow para entrenar varios modelos.

En Accelerate your TensorFlow models with XLA (diapositivas) y Ship faster TensorFlow models with XLA, Sayak Paul (India), GDE de ML, compartió cómo acelerar los modelos TensorFlow con XLA en Cloud Community Days Kolkata 2023 y Cloud Community Days Pune 2023.

En Setup of NVIDIA Merlin and Tensorflow for Recommendation Models, Rubens Zimbres (Brasil), GDE de ML, presentó una revisión de los algoritmos de recomendación, el algoritmo Two Towers y la configuración de NVIDIA Merlin en las instalaciones y en Vertex AI.

En AutoML pipeline for tabular data on VertexAI in Go, Paolo Galeone (Italia), GDE de ML, profundizó en el desarrollo y la implementación de modelos tabulares utilizando VertexAI y AutoML con Go, lo que muestra el código Go real y comparte las estadísticas obtenidas a través de & prueba y error y una extensa investigación de Google para superar las limitaciones de la documentación.

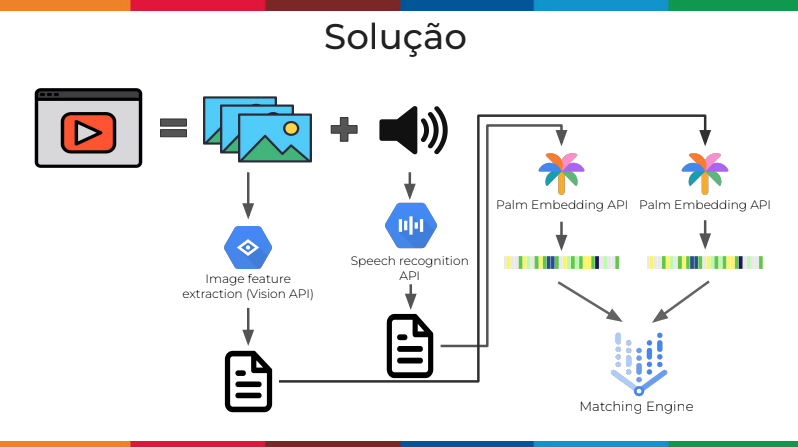

En Beyond images: searching information in videos using AI (diapositivas), Pedro Gengo (Brasil) y Vinicius Caridá (Brasil), GDE de ML, mostraron cómo crear un motor de búsqueda donde se pueda buscar información en los videos. Presentaron una arquitectura en la que transcriben el audio y subtitulan los fotogramas, convierten este texto en incrustaciones y los guardan en una base de datos vectorial en los que se puede buscar cuando un usuario hace una consulta.

En el podcast The secret sauce to creating amazing ML experiences for developers, Gant Laborde (Estados Unidos), GDE de ML, compartió su momento de iluminación, 20 años de experiencia en ML y el secreto para crear experiencias agradables y significativas para los desarrolladores.

En What's inside Google’s Generative AI Studio?, Gad Benram (Portugal), GDE de ML, compartió la versión preliminar de las nuevas funciones y lo que puedes esperar de ellas. Además, en How to pitch Vertex AI in 2023, brindó información sobre los seis puntos de venta simples y claros de los representantes de Google Cloud respecto de cómo convencer a los clientes de que Vertex AI es la plataforma adecuada.

En How to build a conversational AI Augmented Reality Experience with Sachin Kumar, Sachin Kumar (Qatar), GDE de ML, habló sobre cómo crear una aplicación de realidad aumentada que combine múltiples tecnologías como Google Cloud AI, Unity, etc. La sesión recorrió paso a paso el proceso de creación de la aplicación desde cero.

Machine Learning en Google Cloud Platform, de Nitin Tiwari (India), GDE de ML, fue una tutoría cuyo objetivo se centró en proporcionar a los estudiantes una comprensión profunda de los procesos involucrados en el entrenamiento de un modelo de ML y su implementación mediante GCP. En Building robust ML solutions with TensorFlow and GCP, compartió cómo aprovechar las capacidades de GCP y TensorFlow en relación con las soluciones de ML y cómo implementar modelos de ML personalizados.

En Data to AI on Google Cloud: Auto ML, Gen AI, and more, de TFUG Prayagraj, se brindó a los estudiantes información sobre cómo aprovechar las tecnologías avanzadas de IA de Google Cloud, incluidas AutoML y la IA generativa.